Decoupling of Antipodal Vivaldi Antenna Array Based on Multi-route Decoupling Network

-

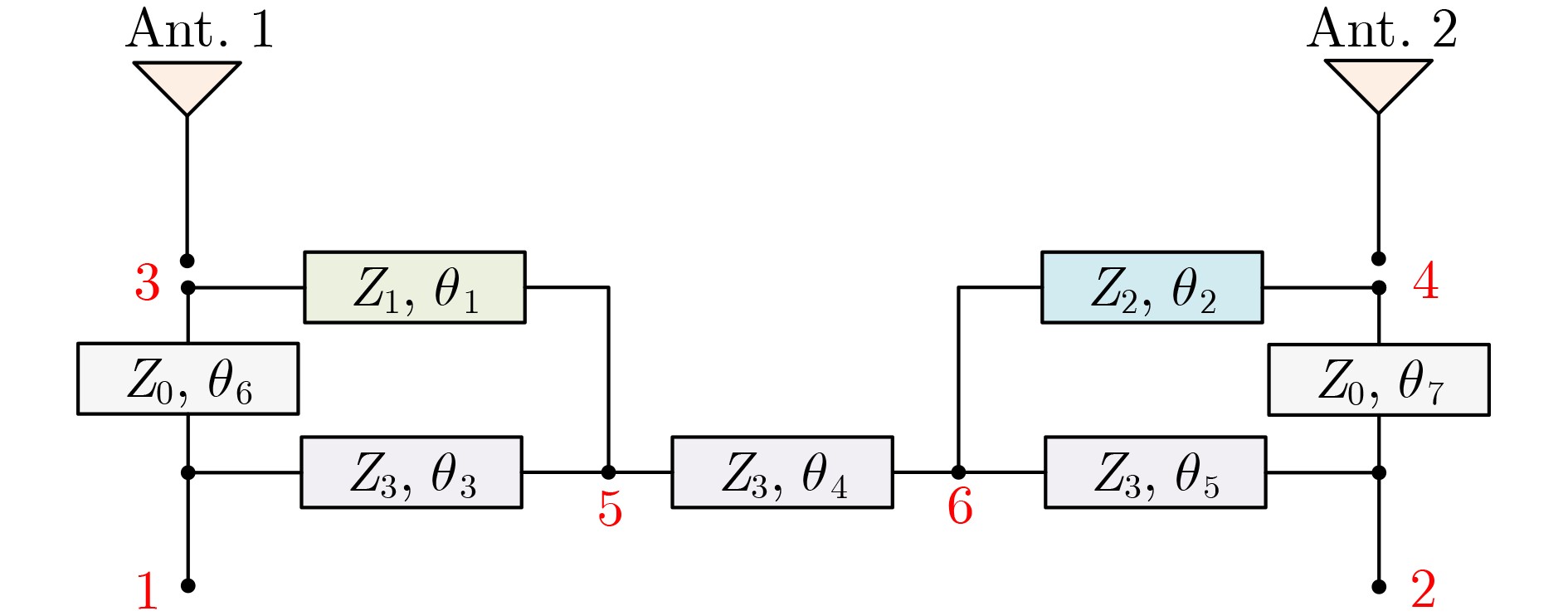

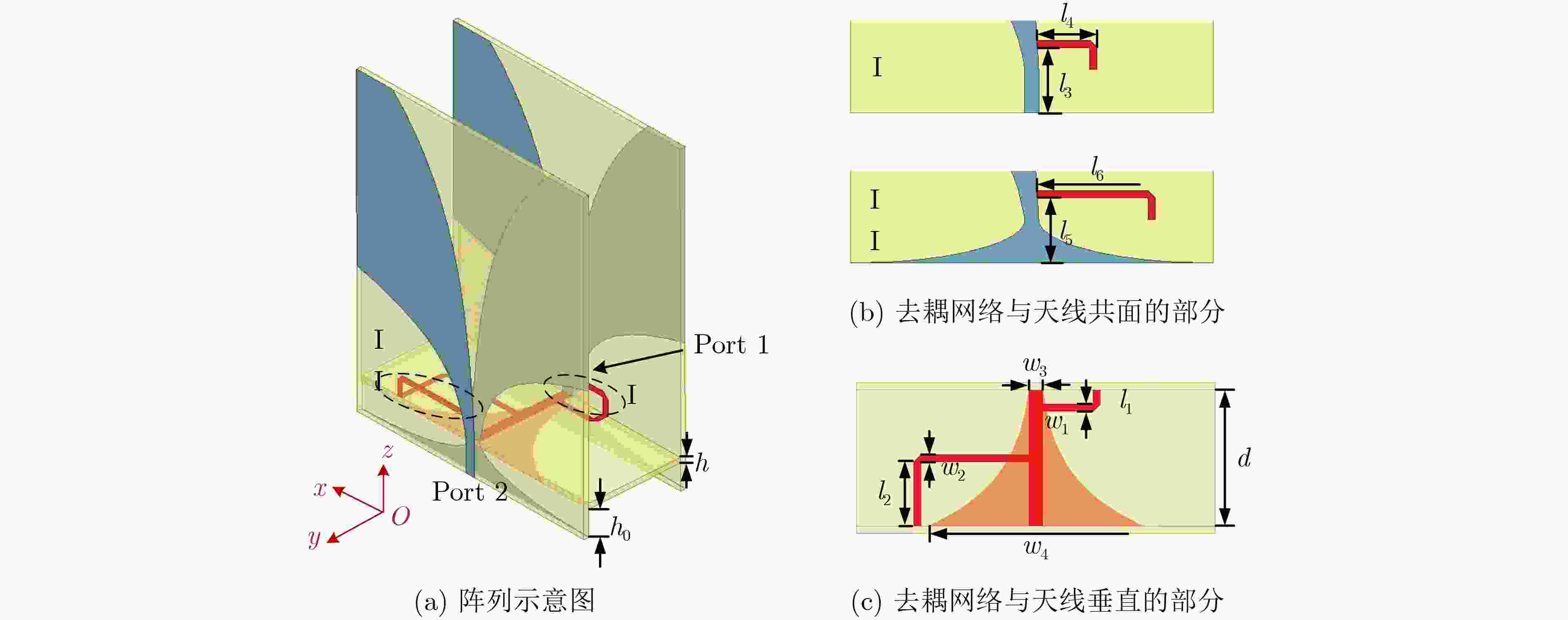

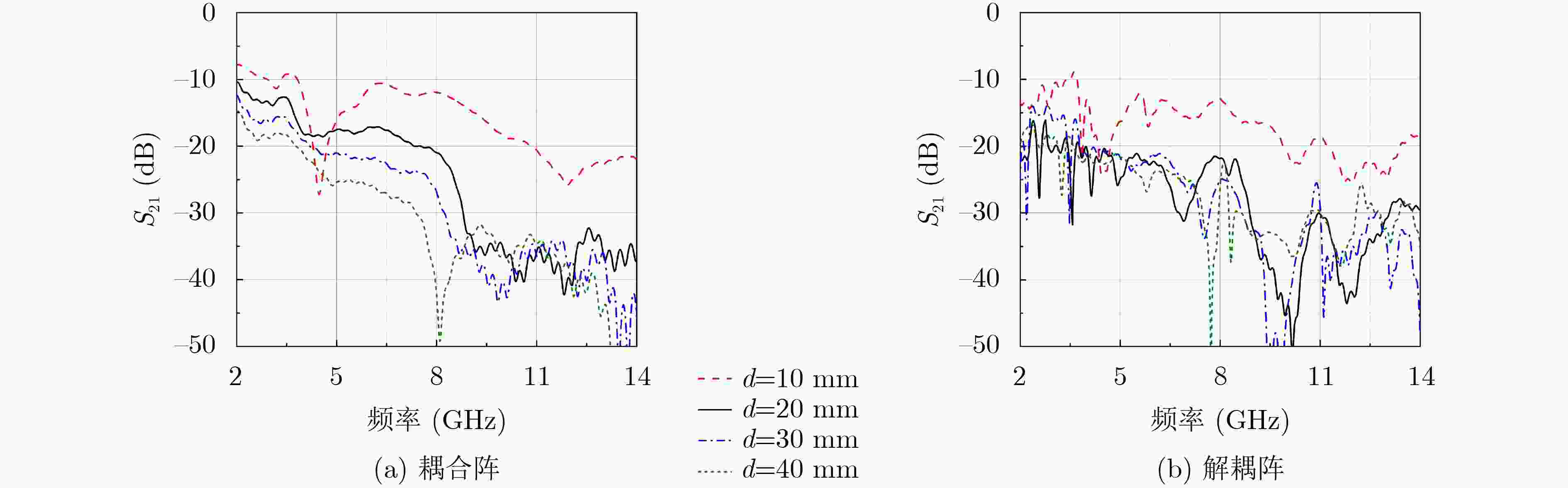

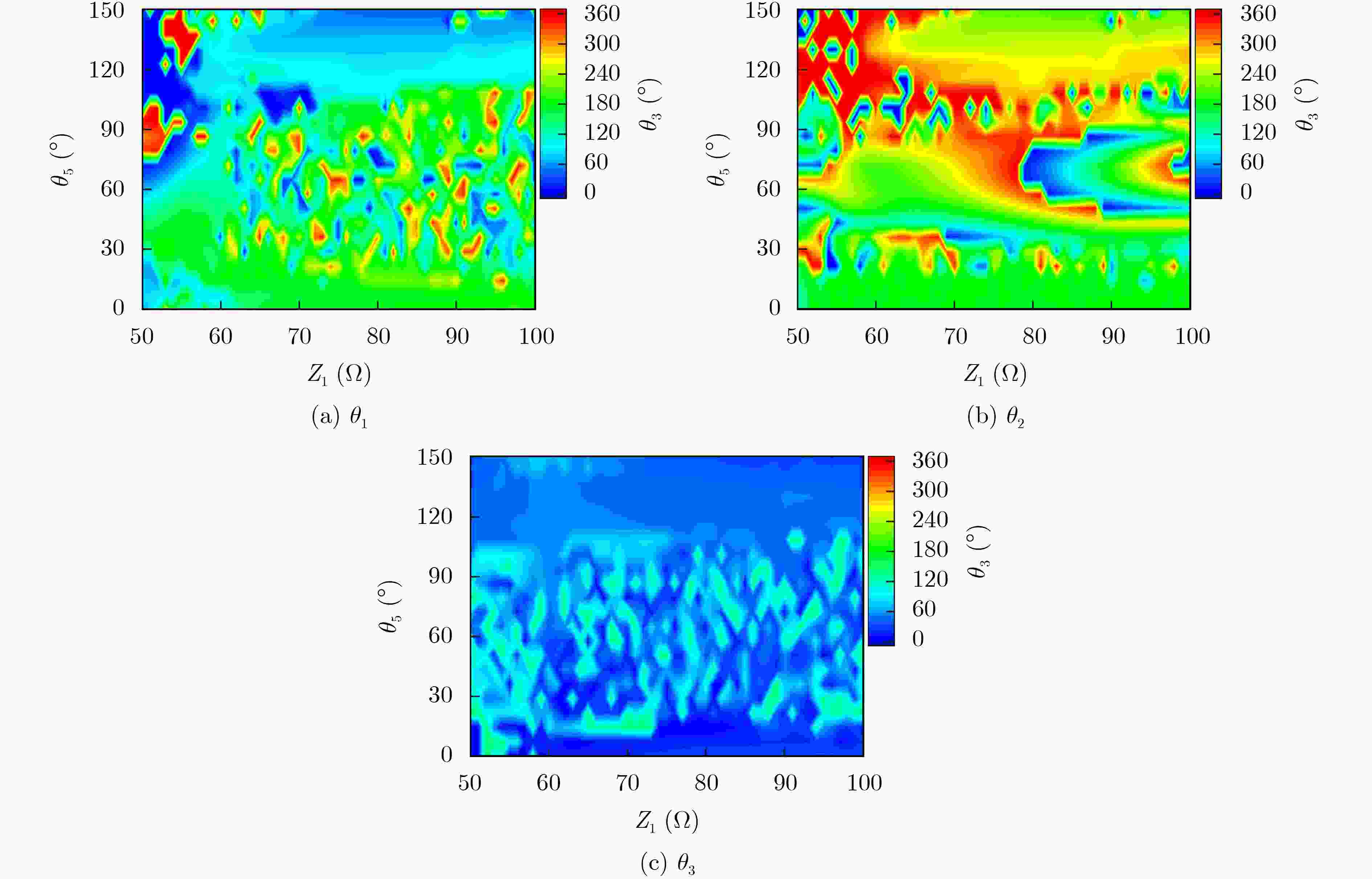

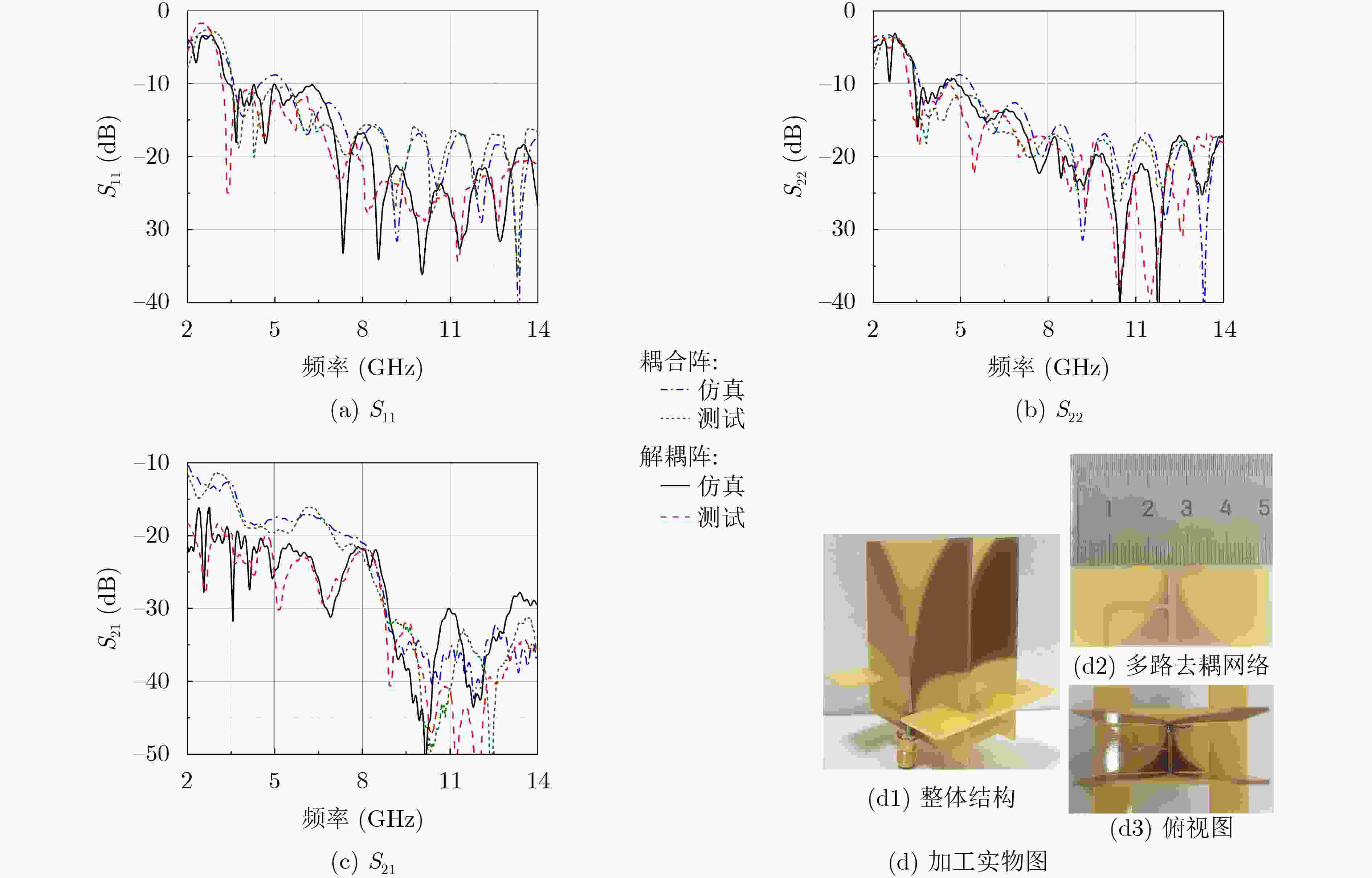

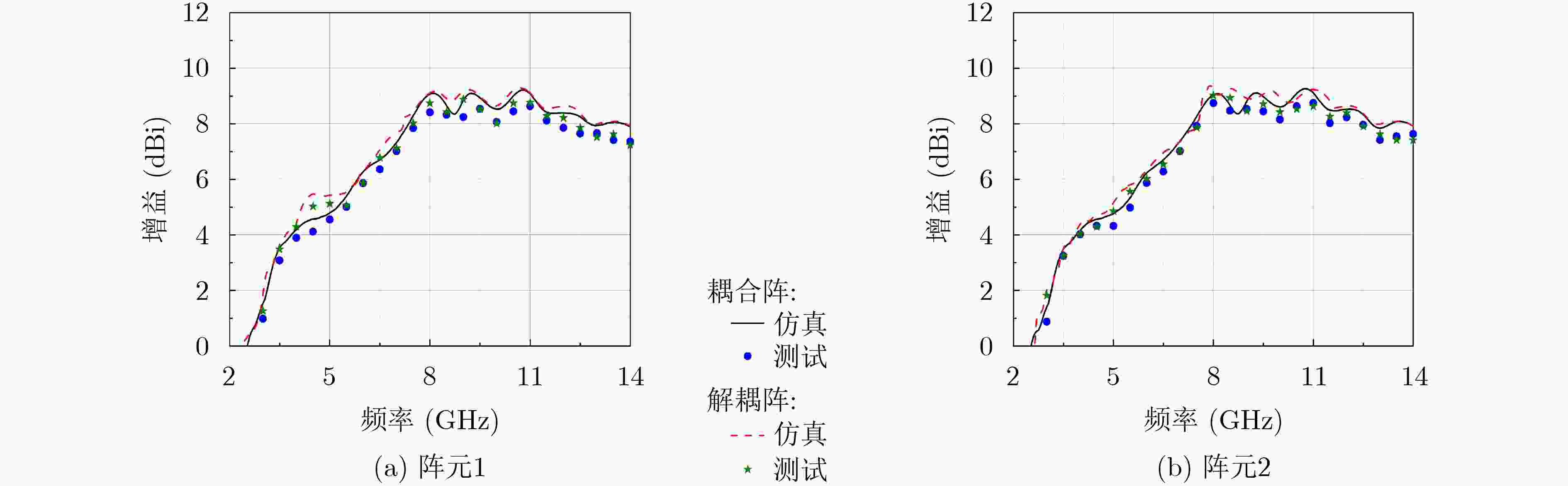

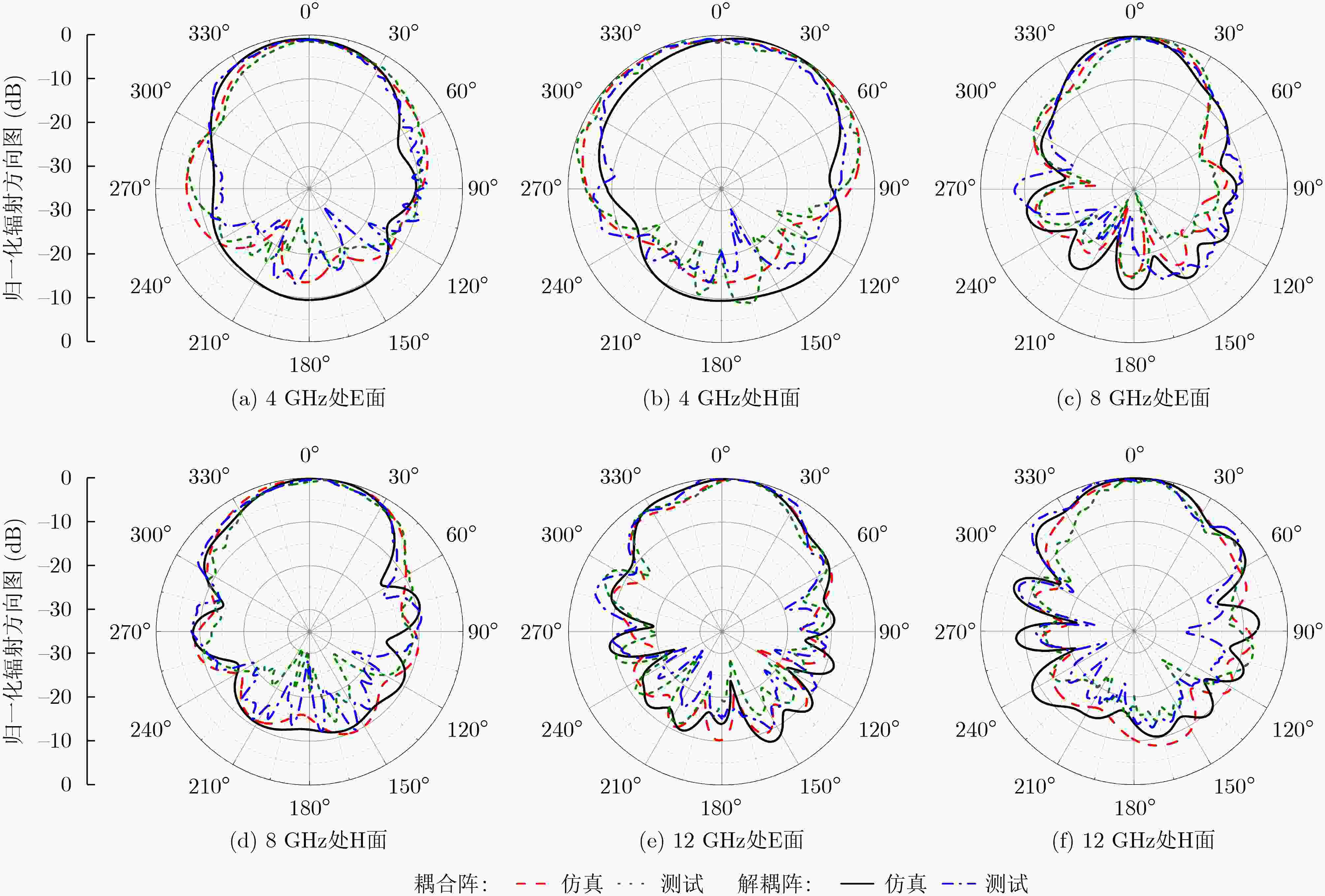

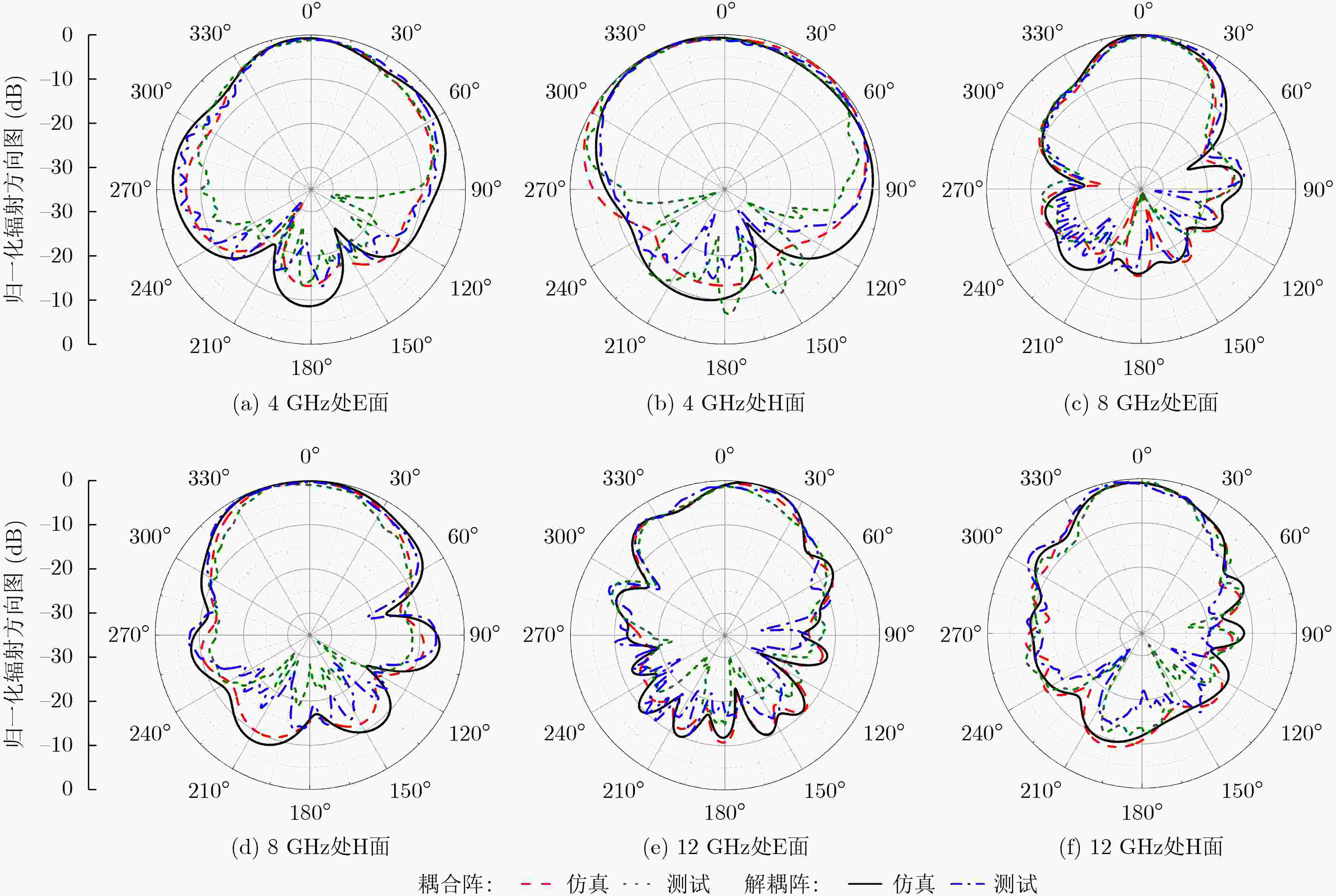

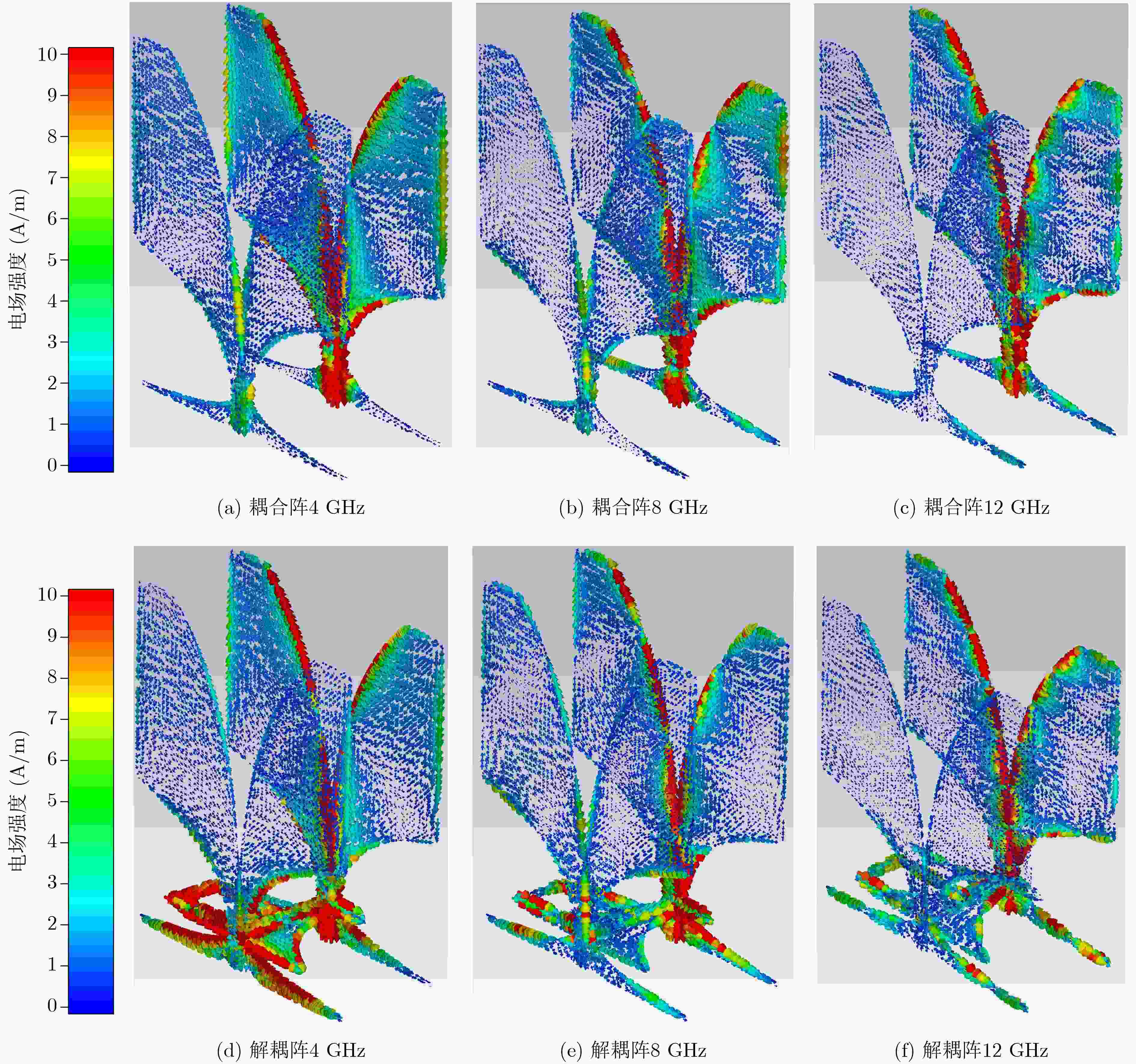

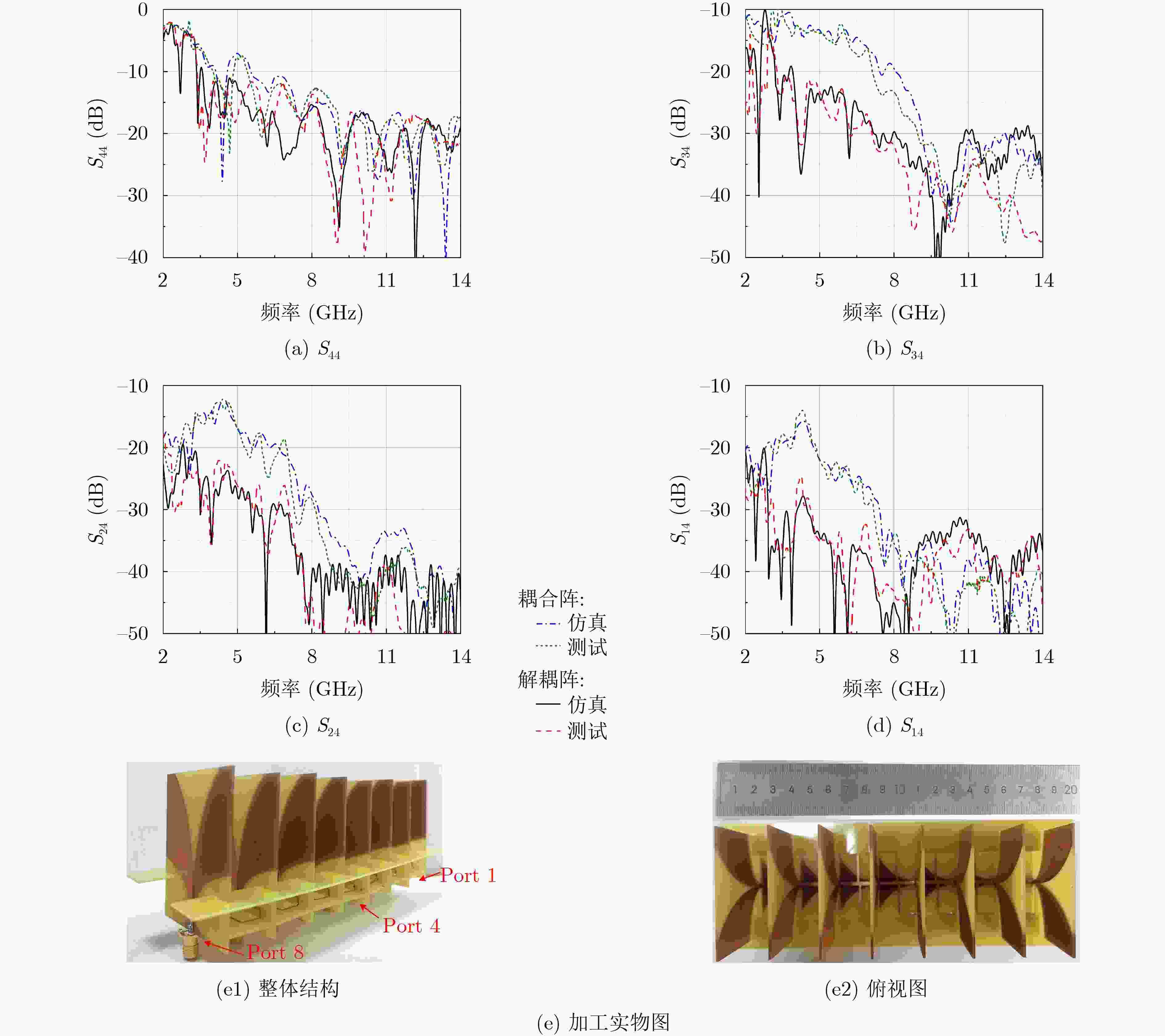

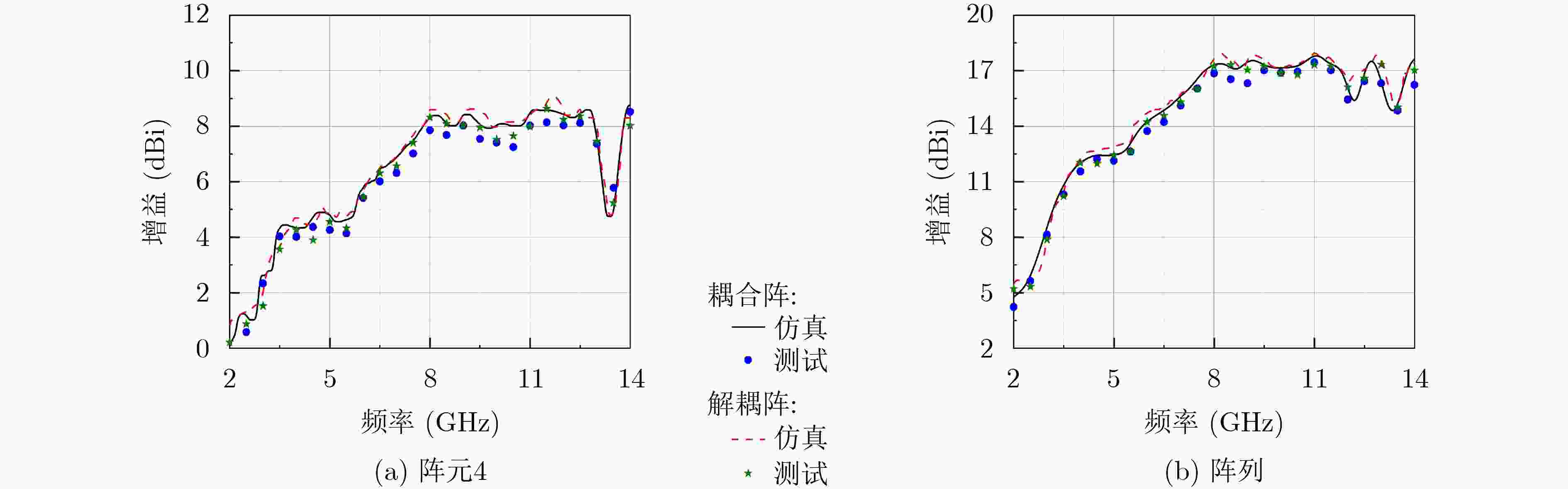

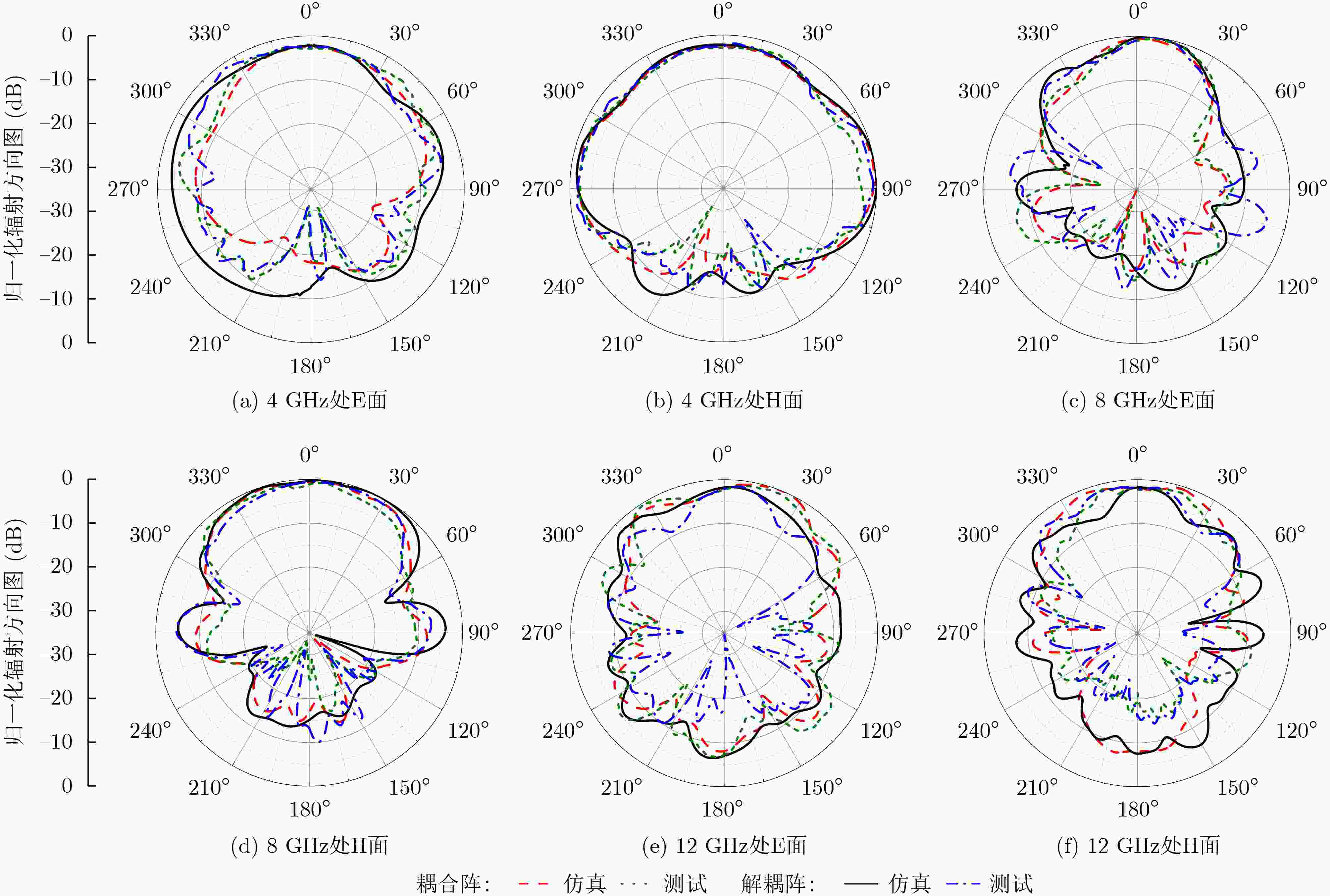

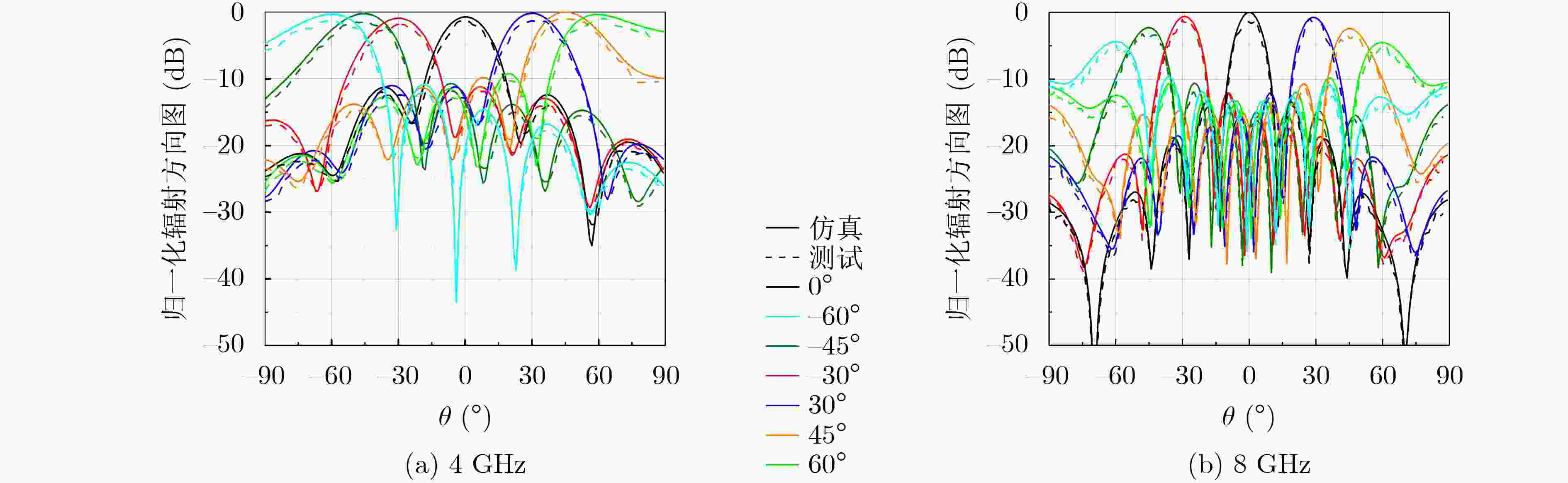

摘要: 该文提出一种基于多路去耦网络解耦宽带天线阵的设计方法。首先,通过节点分析法推导通用多路去耦网络模型的解耦条件和阻抗匹配条件,形成一般设计方法。其次,将多路去耦网络应用至2元对跖Vivaldi天线阵,以低频段为设计基点,依据设计原理得到多路去耦网络的结构参数,增加渐变传输线拓展去耦带宽。实测结果表明,阵列在3.34~13 GHz(3.89:1)的工作频段内隔离度均高于20 dB,与耦合阵相比隔离带宽增加58.8%,且辐射性能得到改善。最后,在1维8元阵列中验证多路去耦网络的有效性,阵列在带内隔离度均高于20 dB,且在±60°的扫描范围内具有良好的辐射性能。所设计的多路去耦网络具有通用性、结构简单和宽带解耦能力,在相控阵天线和大规模通信系统中具有极大的应用前景。Abstract: In this paper, one design method of decoupling wideband antenna array based on multi-route decoupling network is proposed. At the beginning, the decoupling and matching conditions of the common multi-route decoupling network model are derived by employing node analysis, and the general design process is obtained. Then, the proposed decoupling network is applied to a two-element antipodal Vivaldi array, and its dimensional parameters are achieved via the designing basis at low band and the design process. Also, gradient transmission lines are added to extend the decoupling bandwidth. The measured results indicate that the isolation is higher than 20 dB in the operation band of 3.34~13 GHz (3.89:1), which is 58.8% wider than that of the coupled array. Finally, the decoupling effectiveness is further verified in one-dimensional eight-element array, and in-band isolation is always higher than 20 dB. Moreover, the array owns good radiation performance in the scanning range of ±60°. The presented multi-route decoupling network features generality, simple structure and wideband decoupling performance, and is potential in the application of phased arrays and large-scale communication systems.

-

Key words:

- Antenna /

- Decoupling network /

- Decoupling

-

表 1 多路去耦网络的尺寸(mm)

参数 h0 h w1 w2 w3 w4 值 5 1 1 1 1.9 30 参数 l1 l2 l3 l4 l5 l6 值 0 8.9 6 8 6 16 -

[1] CHEN S C, WANG Y S, and CHUNG S J. A decoupling technique for increasing the port isolation between two strongly coupled antennas[J]. IEEE Transactions on Antennas and Propagation, 2008, 56(12): 3650–3658. doi: 10.1109/tap.2008.2005469 [2] SUI Jiangwei and WU Keli. A general T-stub circuit for decoupling of two dual-band antennas[J]. IEEE Transactions on Microwave Theory and Techniques, 2017, 65(6): 2111–2121. doi: 10.1109/tmtt.2017.2647951 [3] ZHANG Yiming, YE Qicheng, PEDERSEN G F, et al. A simple decoupling network with filtering response for patch antenna arrays[J]. IEEE Transactions on Antennas and Propagation, 2021, 69(11): 7427–7439. doi: 10.1109/tap.2021.3070632 [4] ZHAO Luyu, YEUNG L K, and WU Keli. A coupled resonator decoupling network for two-element compact antenna arrays in mobile terminals[J]. IEEE Transactions on Antennas and Propagation, 2014, 62(5): 2767–2776. doi: 10.1109/tap.2014.2308547 [5] ZHAO Luyu and WU Keli. A dual-band coupled resonator decoupling network for two coupled antennas[J]. IEEE Transactions on Antennas and Propagation, 2015, 63(7): 2843–2850. doi: 10.1109/tap.2015.2421973 [6] LI Min, YEUNG K L, JIANG Lijun, et al. Design of wideband decoupling networks for MIMO antennas based on an N-ary optimization algorithm[J]. IEEE Transactions on Vehicular Technology, 2022, 71(5): 5246–5258. doi: 10.1109/tvt.2022.3156397 [7] LI Min, ZHANG Yujie, WU Di, et al. Decoupling and matching network for dual-band MIMO antennas[J]. IEEE Transactions on Antennas and Propagation, 2022, 70(3): 1764–1775. doi: 10.1109/tap.2021.3118791 [8] VOLMER C, WEBER J, STEPHAN R, et al. An Eigen-analysis of compact antenna arrays and its application to port decoupling[J]. IEEE Transactions on Antennas and Propagation, 2008, 56(2): 360–370. doi: 10.1109/tap.2007.915450 [9] XIA Runliang, QU Shiwei, LI Pengfa, et al. Wide-angle scanning phased array using an efficient decoupling network[J]. IEEE Transactions on Antennas and Propagation, 2015, 63(11): 5161–5165. doi: 10.1109/tap.2015.2476342 [10] WANG Zitong and WU Qi. A novel decoupling feeding network for circularly polarized patch arrays using orthogonal mode decomposition[J]. IEEE Transactions on Antennas and Propagation, 2023, 71(2): 1448–1457. doi: 10.1109/tap.2022.3228693 [11] LI Min, JIANG Lijun, and YEUNG K L. A novel wideband decoupling network for two antennas based on the Wilkinson power divider[J]. IEEE Transactions on Antennas and Propagation, 2020, 68(7): 5082–5094. doi: 10.1109/tap.2020.2981679 [12] LI Min, YASIR J M, YEUNG K L, et al. A novel dual-band decoupling technique[J]. IEEE Transactions on Antennas and Propagation, 2020, 68(10): 6923–6934. doi: 10.1109/tap.2020.2995314 [13] ZOU Xiaojun, WANG Guangming, WANG Yawei, et al. An efficient decoupling network between feeding points for multielement linear arrays[J]. IEEE Transactions on Antennas and Propagation, 2019, 67(5): 3101–3108. doi: 10.1109/tap.2019.2899039 [14] WOJCIK D, SURMA M, NOGA A, et al. High port-to-port isolation dual-polarized antenna array dedicated for full-duplex base stations[J]. IEEE Antennas and Wireless Propagation Letters, 2020, 19(7): 1098–1102. doi: 10.1109/lawp.2020.2989698 [15] YANG Mengting, LIU Changrong, and LIU Xueguan. Design of π-shaped decoupling network for dual-polarized Y-probe antenna arrays[J]. IEEE Antennas and Wireless Propagation Letters, 2022, 21(6): 1129–1133. doi: 10.1109/lawp.2022.3158991 [16] ZOU Xiaojun, WANG Guangming, KANG Guoqin, et al. Wideband coupling suppression with neutralization-line-incorporated decoupling network in MIMO arrays[J]. AEU-International Journal of Electronics and Communications, 2023, 167: 154688. doi: 10.1016/j.aeue.2023.154688 [17] 童三强. 二维宽带宽角扫描紧耦合相控阵天线关键问题研究[D]. [博士论文], 电子科技大学, 2022.TONG Sanqiang. Studies on the key problems of two-dimensional wideband wide-angle scanning tightly coupled phased arrays[D]. [Ph. D. dissertation], University of Electronic Science and Technology of China, 2022. [18] ZHANG Tingting, CHEN Yikai, LIU Zhiyuan, et al. A low-scattering Vivaldi antenna array with slits on nonradiating edges[J]. IEEE Transactions on Antennas and Propagation, 2023, 71(2): 1999–2004. doi: 10.1109/tap.2022.3232690 -

下载:

下载:

下载:

下载: