Resource Allocation for Unmanned Aerial Vehicle-assisted Mobile Edge Computing to Minimize Weighted Energy Consumption

-

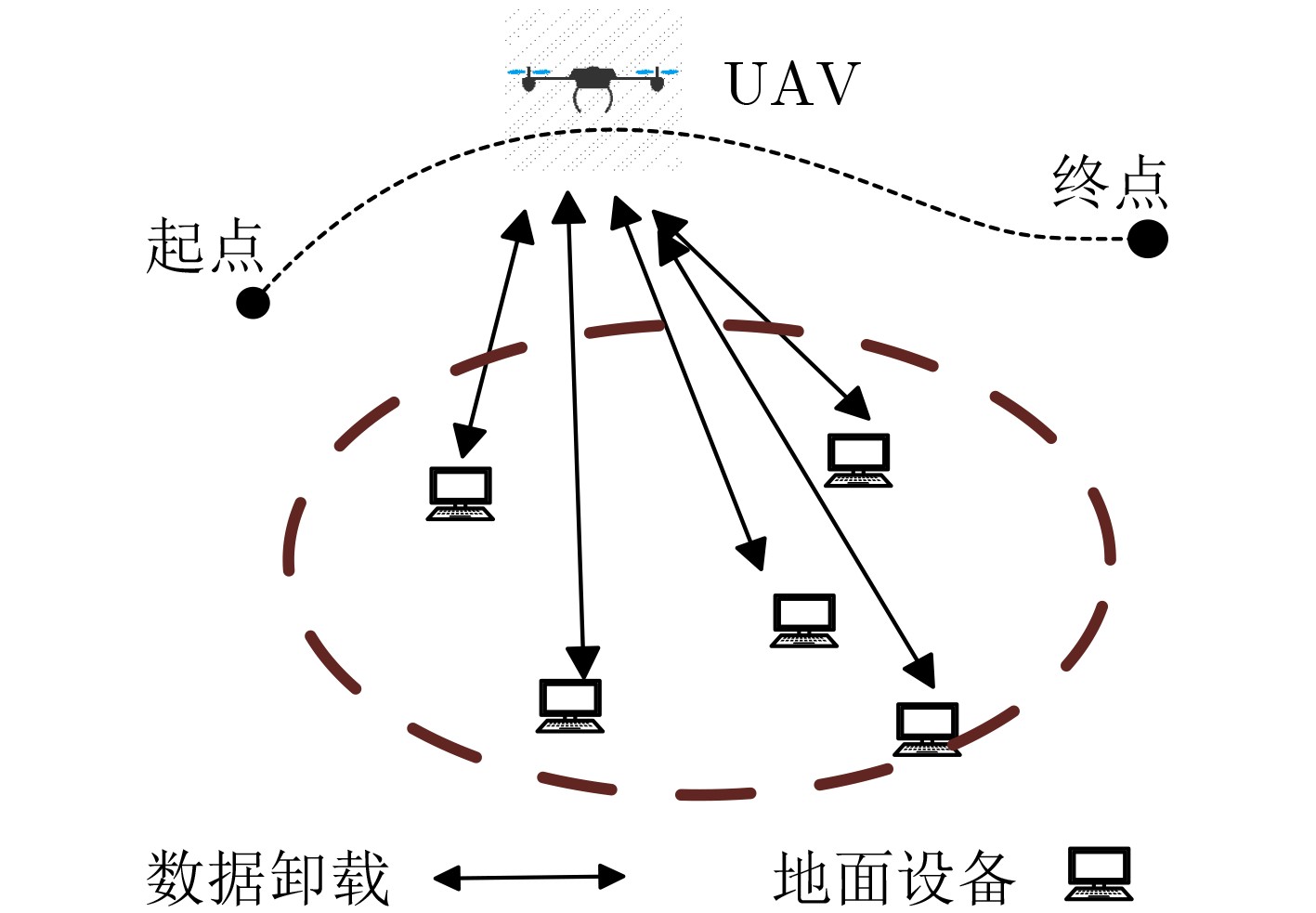

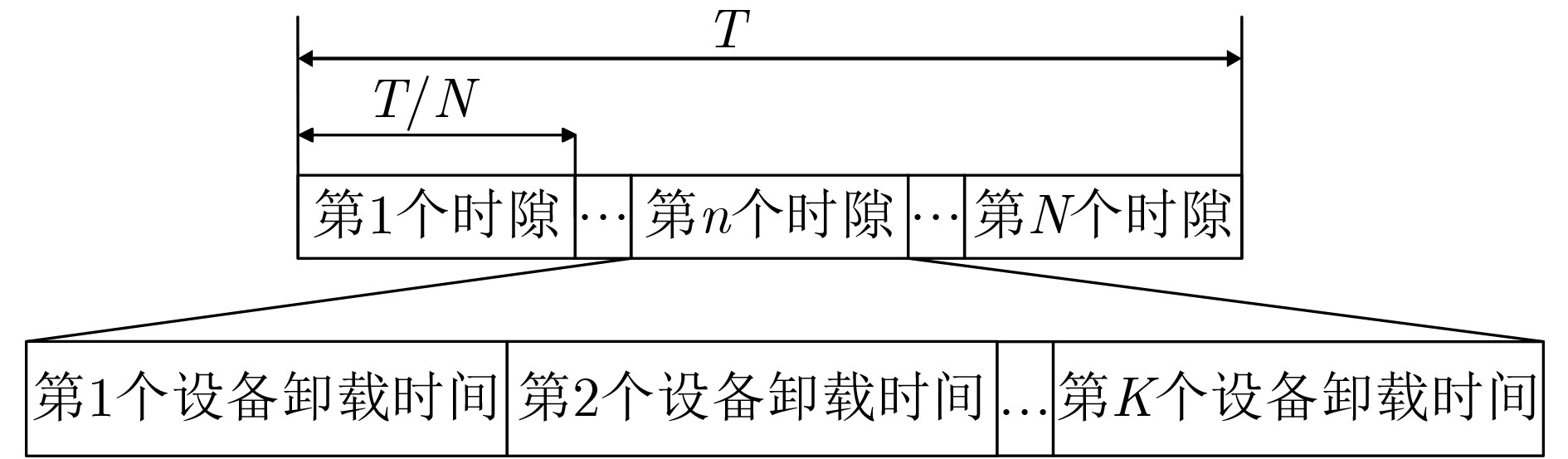

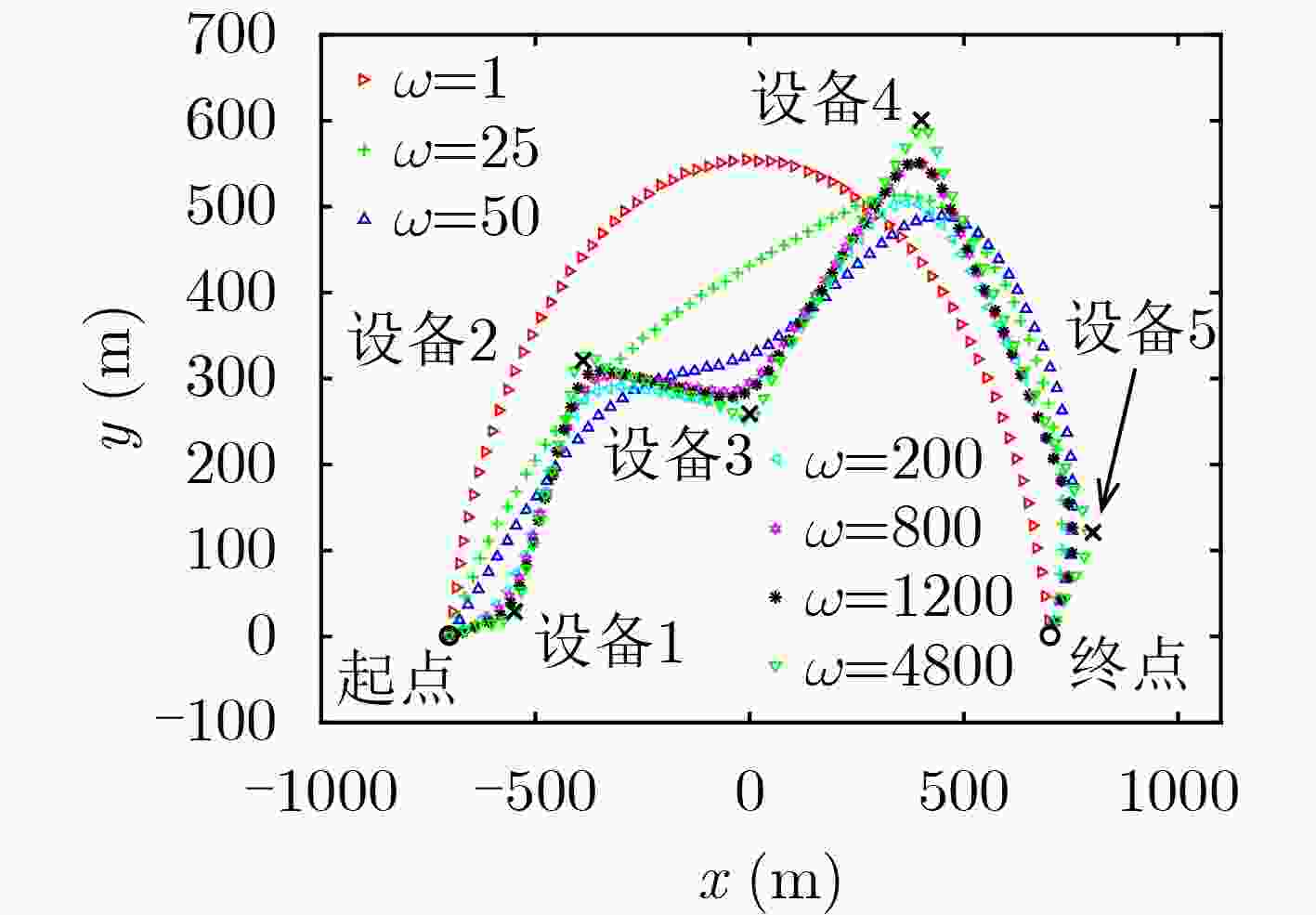

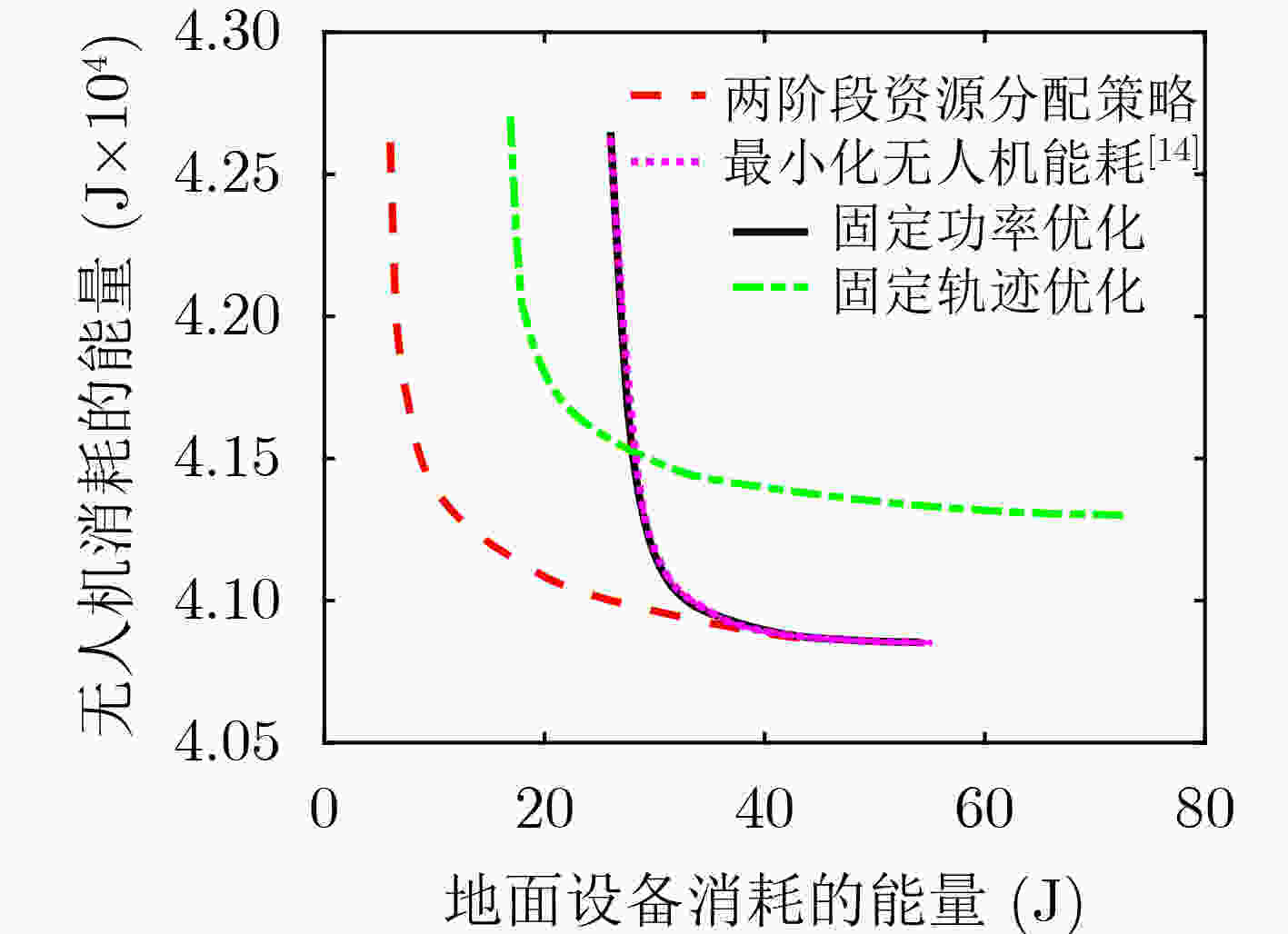

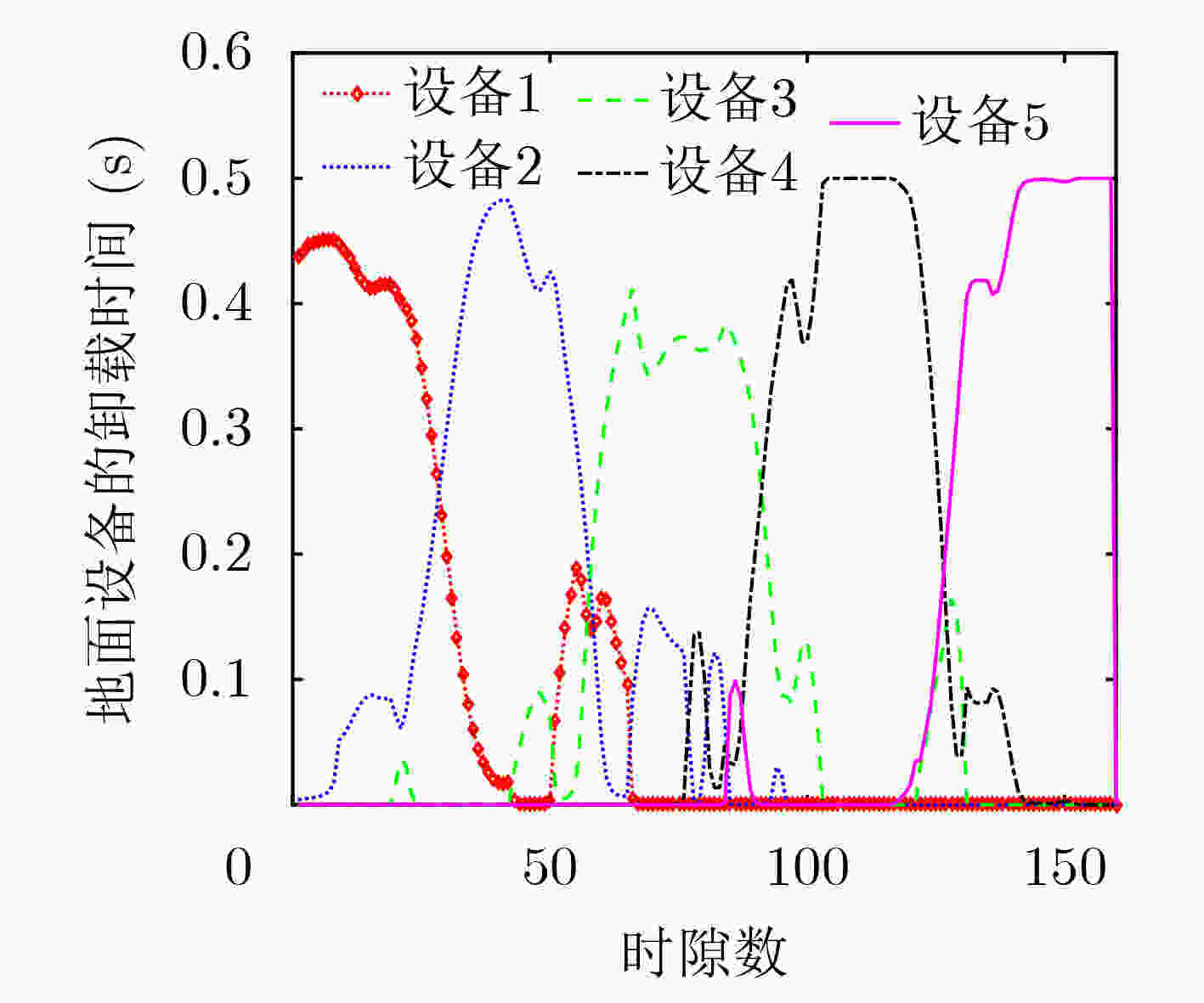

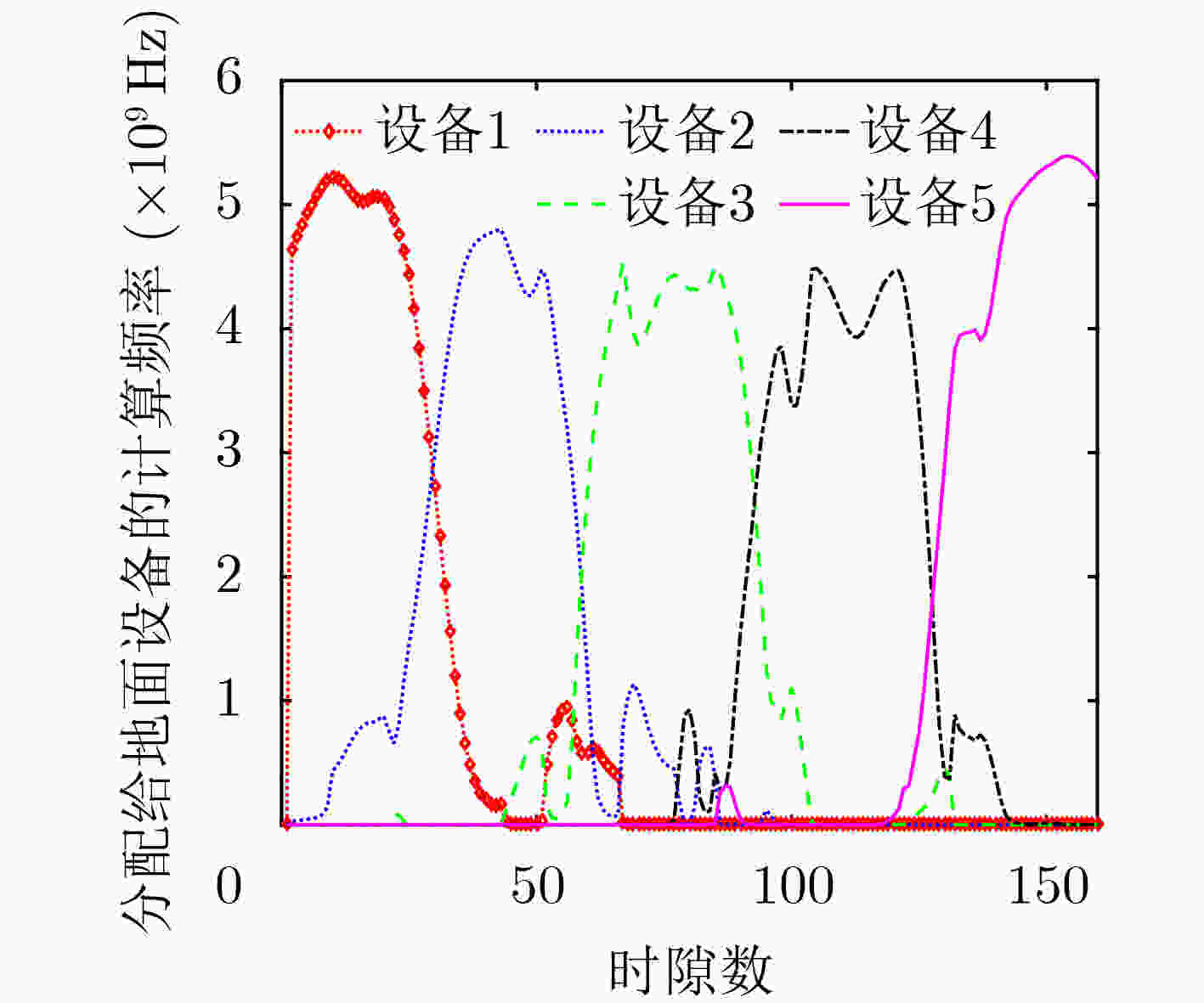

摘要: 针对无人机(UAV)辅助的移动边缘计算(MEC)系统,考虑到无人机能耗与地面设备能耗不在一个数量级,该文提出通过给地面设备能耗增加一个权重因子以平衡无人机能耗与地面设备能耗。同时在满足地面设备的任务需求下,通过联合优化无人机轨迹、系统资源分配以最小化无人机和地面设备的加权能耗。该问题高度非凸,为此提出一个基于交替优化算法的两阶段资源分配策略解决该非凸问题。第1阶段在给定地面设备的卸载功率下,利用连续凸逼近(SCA)方法求解无人机轨迹规划、CPU频率资源分配及卸载时间分配;第2阶段求解地面设备的卸载功率分配。通过两阶段的交替和迭代优化找到原问题的次优解。仿真结果验证了所提算法在降低系统能耗方面的有效性。Abstract: For the Unmanned Aerial Vehicle (UAV)-assisted Mobile Edge Computing (MEC) system, it is proposed to balance the energy consumption of UAV and ground equipment by adding a weight factor to the energy consumption of ground equipment, considering that their energy consumption is not in the same order of magnitude. At the same time, to meet the requirements of ground equipment tasks, the weighted energy consumption of UAV and ground equipment are minimized by joint optimization of UAV trajectory and system resource allocation. The formulated problem is highly non-convex, thus an alternating optimization based two-stage resource allocation optimization scheme is proposed to solve it. In the first stage, given the unloading power of the ground equipment, the Successive Convex Approximation (SCA) method is used to solve the UAV trajectory optimization, Central Processing Unit (CPU) frequency resource allocation and unloading time allocation. In the second stage, the unloading power allocation of ground equipment is optimized. Such two-stage alternating and iterative optimization is used to find the sub-optimal solution of the original problem. The effectiveness of the proposed scheme in reducing system energy consumption is verified by simulation results.

-

表 1 系统参数

参数 含义 $B$ 信号带宽(Hz) $H$ 无人机飞行高度(m) ${P_{kn}}$ 第k个地面设备第n时隙的卸载功率(W) $C$ 单位比特计算任务所需的 CPU 循环次数 ${w_{kn}}$ 第k个地面设备第n时隙的卸载时间 ${f_{u,kn}}$ 无人机分配给第k个地面设备第n时隙的计算频率 ${f_{kn}}$ 第k个地面设备第n时隙的计算频率 ${v_n}$ 第n时隙无人机的飞行速度 ${\kappa _k}$ 地面设备CPU有效电容系数 ${\kappa _u}$ 无人机CPU有效电容系数 $\rho $ 空气密度(kg/m3) $A$ 无人机叶片扫过的面积(m2) ${U_{{\rm{tip}}} }$ 无人机叶尖角速度(m/s) ${d_0}$ 机身阻力比 ${{\boldsymbol{v}}_0}$ 无人机悬停时平均旋翼诱导速度(m/s) ${s_0}$ 总叶片面积与叶片扫过面积之比 ${P_0}$ 无人机悬停状态下型阻功率 ${P_i}$ 无人机悬停状态下的诱导功率 表 2 算法1:基于交替优化算法的两阶段资源分配策略

输入:${\boldsymbol{q}}_n^0,{\boldsymbol{v}}_n^0,y_{kn}^0,u_n^0,P_{kn}^0,w_{kn}^0,\varepsilon$,并设置$ r = 0 $; Repeat (1)给定$P_{kn}^r,{\boldsymbol{q}}_n^r,{\boldsymbol{v}}_n^r,y_{kn}^r,u_n^r,w_{kn}^r$,求解问题P3得到

$\left\{ {{\boldsymbol{q}}_n^*,{\boldsymbol{v}}_n^*,y_{kn}^*,u_n^*,w_{kn}^*,f_{kn}^*,f_{u,kn}^*,D_{kn}^*} \right\}$;(2)给定$\left\{ {{\boldsymbol{q}}_n^*,{\boldsymbol{v}}_n^*,y_{kn}^*,u_n^*,w_{kn}^*,f_{kn}^*,f_{u,kn}^*,D_{kn}^*} \right\}$,求解问

题P4得到$P_{kn}^*$;(3)更新$r = r + 1$,并重新初始化迭代变量

$\left\{ {{\boldsymbol{q}}_n^r,{\boldsymbol{v}}_n^r,y_{kn}^r,u_n^r,w_{kn}^r,P_{kn}^r } \right\} \triangleq$

$\left\{ {{\boldsymbol{q}}_n^*,{\boldsymbol{v}}_n^*,y_{kn}^*,u_n^*,w_{kn}^*, P_{kn}^*} \right\}$;(4) if ${({\tilde E_{ {\rm{fly} } } }{\text{ + } }{E_{ {\rm{comp} } } }{\text{ + } }\omega {e_{{\rm{user}}} })^{r + 1} }$

$- {({\tilde E_{{\rm{fly}}} }{\text{ + } }{E_{{\rm{comp}}} }{\text{ + } }\omega {e_{{\rm{user}}} })^r} \le \varepsilon $,则退出循环,否则返回

步骤(1);输出:$\left\{ { {{\boldsymbol{q}}_n},{{\boldsymbol{v}}_n},{y_{kn} },{u_n},{w_{kn} },{f_{kn} },{f_{u,kn} },{D_{kn} } } \right\}$; 表 3 仿真参数值

参数 取值 参数 取值 $B$ 1 MHz $ \rho $ 1.225 kg/m3 $H$ 100 m $ A $ 0.603 m2 ${I_k}$ 100 Mbit ${U_{{\rm{tip}}} }$ 200 m/s $C$ 1000 cycles/bit ${d_0}$ 0.3010 $T$ 100 s ${v_0}$ 6.2089 m/s ${f^{{\rm{max}}} }$ 0.3 GHz ${s_0}$ 0.0499 $f_u^{{\rm{max}}}$ 6 GHz ${P_0}$ 225.79 W ${{\boldsymbol{q}}_I}$ [–700,0] m ${P_i}$ 426.07 W ${{\boldsymbol{q}}_F}$ [700,0] m ${\tau _n}$ 0.5 s ${V_{{\rm{max}}} }$ 40 m/s $N$ 200 ${\kappa _k}$ 10–28 ${\beta _0}$ –60 dB ${\kappa _u}$ 10–28 ${\sigma ^2}$ –100 dBm -

[1] YOU Changsheng, HUANG Kaibin, and CHAE H. Energy efficient mobile cloud computing powered by wireless energy transfer[J]. IEEE Journal on Selected Areas in Communications, 2016, 34(5): 1757–1771. doi: 10.1109/JSAC.2016.2545382 [2] SARKAR S, CHATTERJEE S, and MISRA S. Assessment of the suitability of fog computing in the context of internet of things[J]. IEEE Transactions on Cloud Computing, 2018, 6(1): 46–59. doi: 10.1109/TCC.2015.2485206 [3] LIN Xingqin, YAJNANARAYANA V, MURUGANATHAN S D, et al. The sky is not the limit: LTE for unmanned aerial vehicles[J]. IEEE Communications Magazine, 2018, 56(4): 204–210. doi: 10.1109/MCOM.2018.1700643 [4] WANG Jinyuan, MA Yang, LU Rongrong, et al. Hovering UAV-Based FSO communications: Channel modelling, performance analysis, and parameter optimization[J]. IEEE Journal on Selected Areas in Communications, 2021, 39(10): 2946–2959. doi: 10.1109/JSAC.2021.3088656 [5] 董超, 沈赟, 屈毓锛. 基于无人机的边缘智能计算研究综述[J]. 智能科学与技术学报, 2020, 2(3): 227–239. doi: 10.11959/j.issn.2096–6652.202025.DONG Chao, SHEN Yun, and QU Yuben. A survey of UAV-based edge intelligent computing[J]. Chinese Journal of Intelligent Science and Technology, 2020, 2(3): 227–239. doi: 10.11959/j.issn.2096–6652.202025. [6] MAO Yuyi, YOU Changsheng, ZHANG Jun, et al. A survey on mobile edge computing: The communication perspective[J]. IEEE Communications Surveys & Tutorials, 2017, 19(4): 2322–2358. doi: 10.1109/COMST.2017.2745201 [7] HU Qiyu, CAI Yunlong, YU Guanding, et al. Joint offloading and trajectory design for UAV-enabled mobile edge computing systems[J]. IEEE Internet of Things Journal, 2019, 6(2): 1879–1892. doi: 10.1109/JIOT.2018.2878876 [8] ZENG Ming, DU Rong, FODOR C, et al. Computation rate maximization for wireless powered mobile edge computing with NOMA[C]. IEEE 20th International Symposium on "A World of Wireless, Mobile and Multimedia Networks" (WoWMoM), Washington, USA, 2019: 1–9. doi: 10.1109/WoWMoM.2019.8792997. [9] ZHOU Fuhui and HU R Q. Computation efficiency maximization in wireless-powered mobile edge computing networks[J]. IEEE Transactions on Wireless Communications, 2020, 19(5): 3170–3184. doi: 10.1109/TWC.2020.2970920 [10] 吴启晖, 吴伟. 无人机辅助边缘计算的能量效率最大化算法设计[J]. 通信学报, 2020, 41(10): 15–24. doi: 10.11959/j.issn.1000-436x.2020204WU Qihui and WU Wei. Algorithm design on energy efficiency maximization for UAV-assisted edge computing[J]. Journal on Communications, 2020, 41(10): 15–24. doi: 10.11959/j.issn.1000-436x.2020204 [11] ZHOU Yi, PAN Cunhua, PHEE L Y, et al. Secure communications for UAV-enabled mobile edge computing systems[J]. IEEE Transactions on Communications, 2020, 68(1): 376–388. doi: 10.1109/TCOMM.2019.2947921 [12] DIAO Xianbang, ZHENG Jianchao, WU Yuan, et al. Joint trajectory design, task data, and computing resource allocations for NOMA-based and UAV-assisted mobile edge computing[J]. IEEE Access, 2019, 7: 117448–117459. doi: 10.1109/ACCESS.2019.2936437 [13] HUA Meng, WANG Yi, ZHANG Zhengming, et al. Optimal resource partitioning and bit allocation for UAV-enabled mobile edge computing[C]. IEEE 88th Vehicular Technology Conference, Chicago, USA, 2018: 1–6. doi: 10.1109/VTCFall.2018.8690707. [14] ZHAN Chen, HU Han, SUI Xiufeng, et al. Completion time and energy optimization in the UAV-enabled mobile-edge computing system[J]. IEEE Internet of Things Journal, 2020, 7(8): 7808–7822. doi: 10.1109/JIOT.2020.2993260 [15] LIU Yuan, XIONG Ke, NI Qiang, et al. UAV-assisted wireless powered cooperative mobile edge computing: Joint offloading, CPU control, and trajectory optimization[J]. IEEE Internet of Things Journal, 2020, 7(4): 2777–2790. doi: 10.1109/JIOT.2019.2958975 [16] MEI Haibo, WANG Kezhi, ZHOU Dongdai, et al. Joint trajectory-task-cache optimization in UAV-enabled mobile edge networks for cyber-physical system[J]. IEEE Access, 2019, 7: 156476–156488. doi: 10.1109/ACCESS.2019.2949032 [17] ZHANG Xiaochen, ZHANG Jiao, XIONG Jun, et al. Energy-efficient multi-UAV-enabled multiaccess edge computing incorporating NOMA[J]. IEEE Internet of Things Journal, 2020, 7(6): 5613–5627. doi: 10.1109/JIOT.2020.2980035 [18] ZHANG Tiankui, XU Yu, LOO J, et al. Joint computation and communication design for UAV-assisted mobile edge computing in IoT[J]. IEEE Transactions on Industrial Informatics, 2020, 16(8): 5505–5516. doi: 10.1109/TII.2019.2948406 [19] ZENG Yong, XU Jie, and ZHANG Rui. Energy minimization for wireless communication with rotary-wing UAV[J]. IEEE Transactions on Wireless Communications, 2019, 18(4): 2329–2345. doi: 10.1109/TWC.2019.2902559 -

下载:

下载:

下载:

下载: