Remote Sensing Image Change Detection Based on Fully Convolutional Neural Networks with Edge Change Information

-

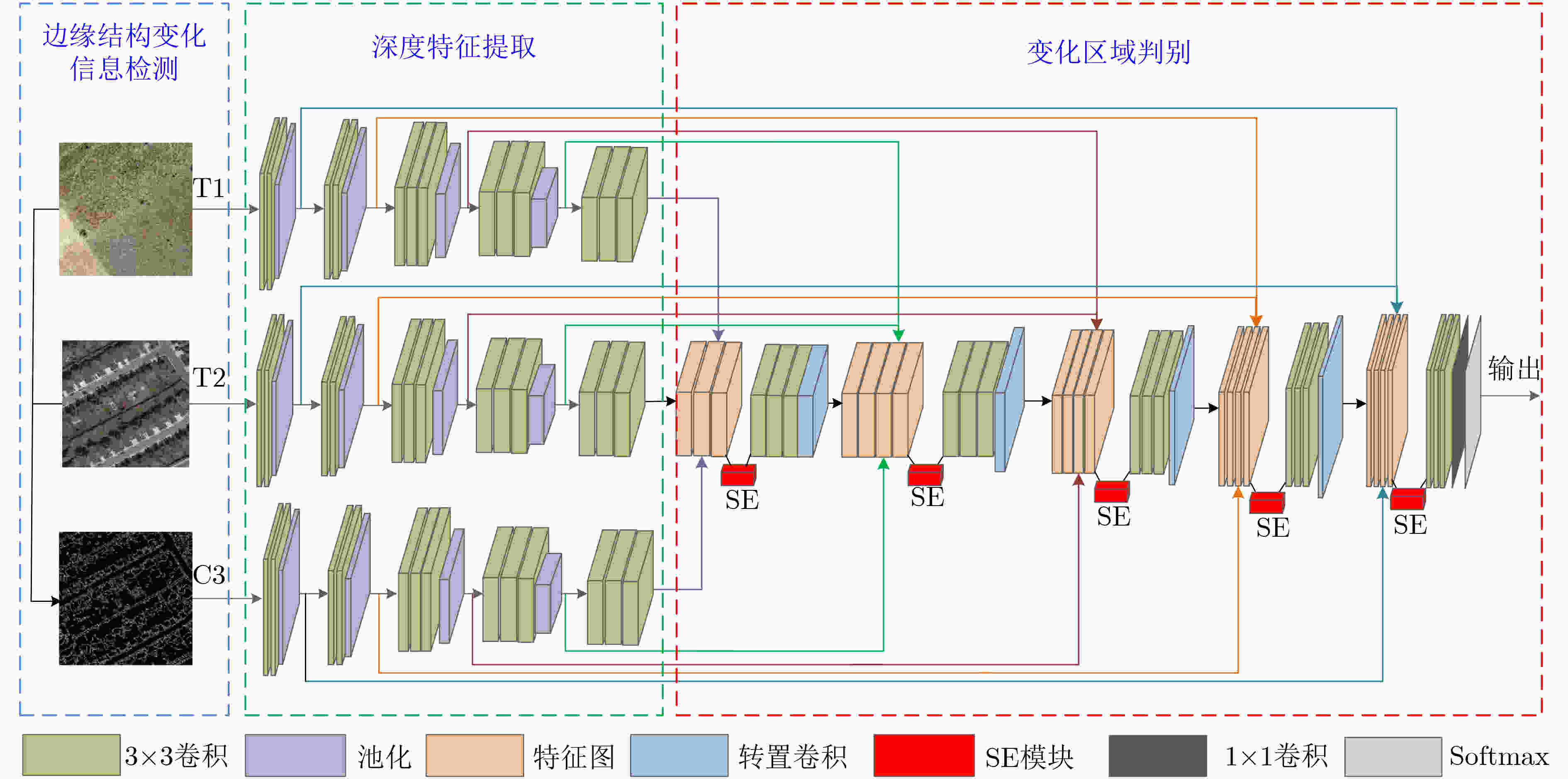

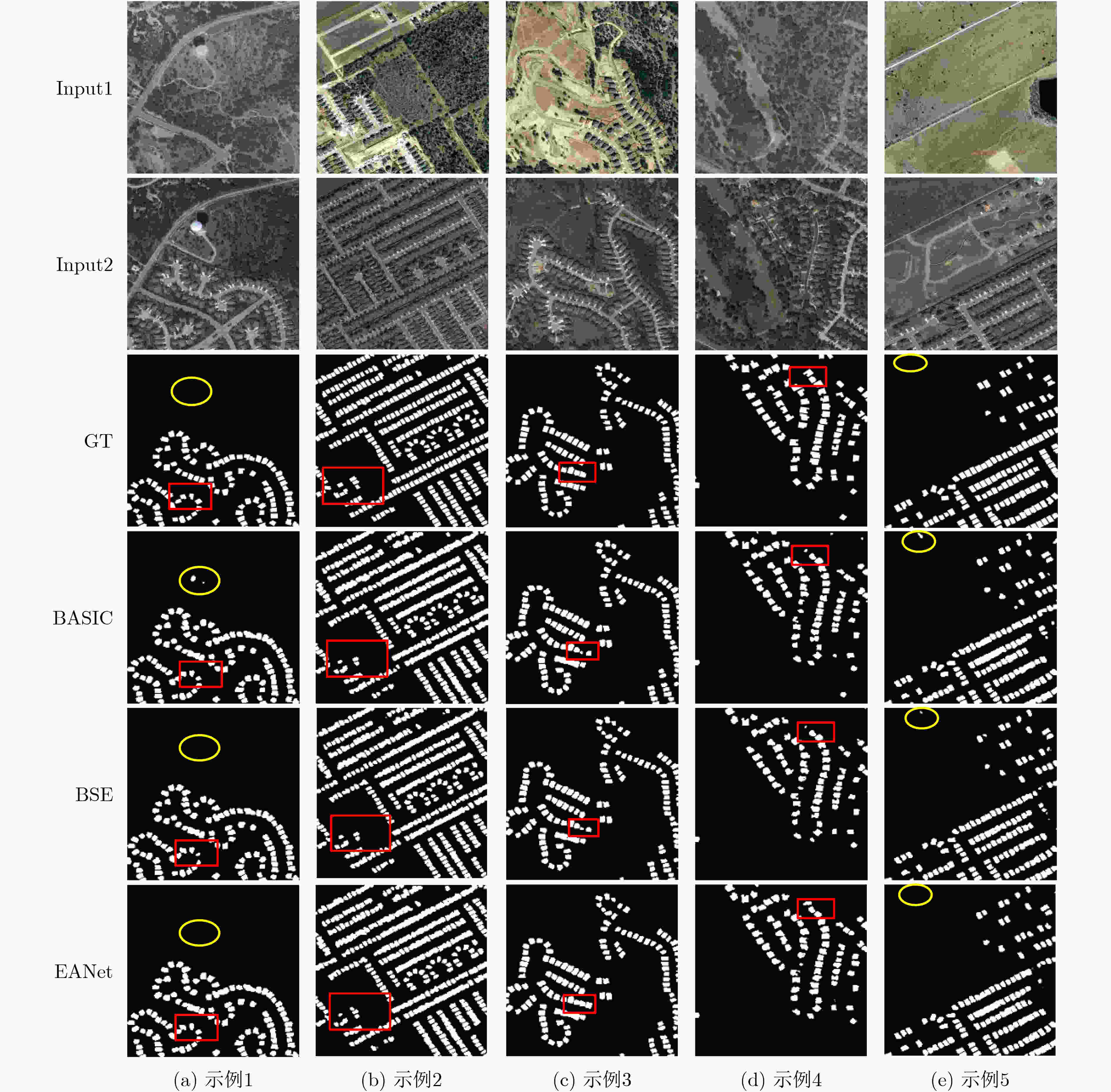

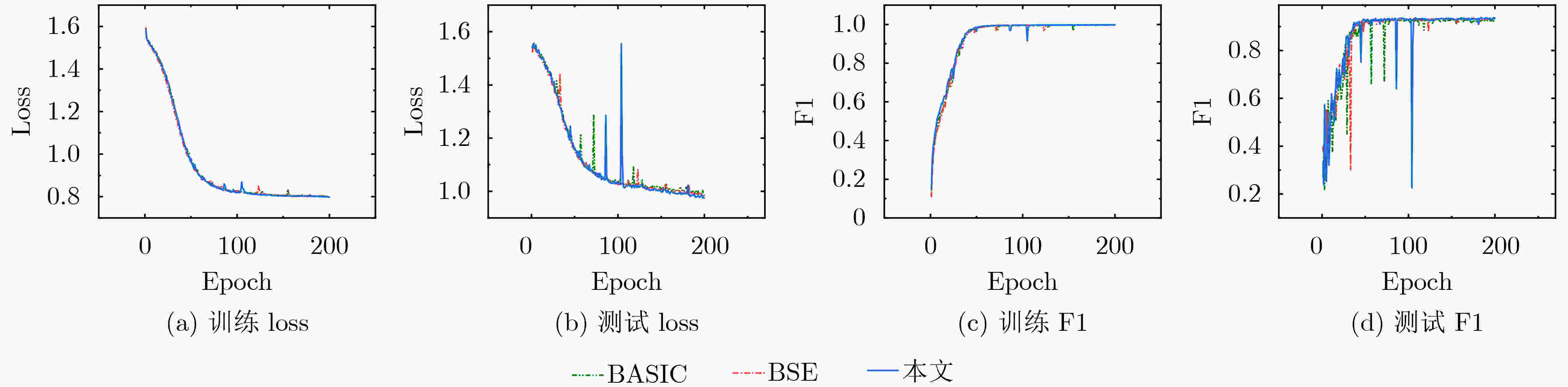

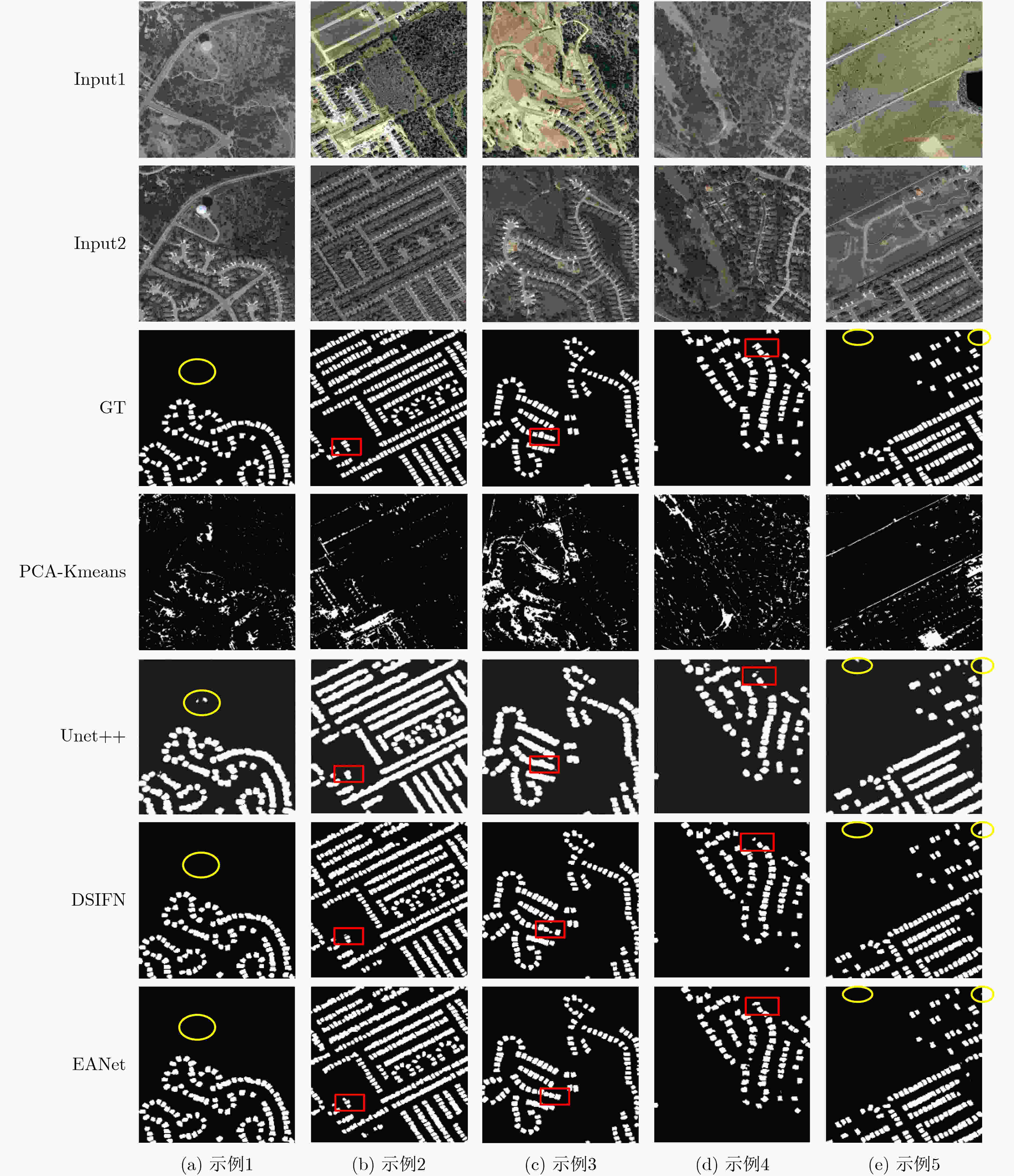

摘要: 高分辨率遥感图像变化检测是了解地表变化的关键,是遥感图像处理领域的一个重要分支。现有很多基于深度学习的变化检测方法,取得了良好的效果,但是不易获得高分辨率遥感图像中的结构细节且检测精度有待提高。因此,该文提出融合了边缘变化信息和通道注意力模块的网络框架(EANet),分为边缘结构变化信息检测、深度特征提取和变化区域判别3个模块。首先,为了得到双时相图像的边缘变化信息,对其进行边缘检测得到边缘图,并将边缘图相减得到边缘差异图;其次,考虑到高分辨率遥感图像精细的图像细节和复杂的纹理特征,为了充分提取单个图像的深度特征,构建基于VGG-16网络的3支路模型,分别提取双时相图像和边缘差异图的深度特征;最后,为了提高检测精度,提出将通道注意力机制嵌入到模型中,以关注信息量大的通道特征来更好地进行变化区域的判别。实验结果表明,无论从视觉解释或精度衡量上看,提出算法与目前已有的一些方法相比,具有一定的优越性。Abstract: Change detection in high resolution remote sensing images is the key to understanding of land surface changes. Change detection of remote sensing images is an important branch of remote sensing image processing. Many existing change detection methods based on deep learning have achieved good results, but it is not easy to obtain the structural details of high resolution remote sensing images, and the accuracy of the detection needs to be improved. Therefore, a network framework which combines Edge change information and channel Attention Network module (EANet) is proposed. EANet is divided into three modules: Edge structure change information detection, depth feature extraction and change area discrimination. Firstly, in order to get the edge change information of the two-phase images, the edge of the two-phase images is detected to get the edge images, and the edge images is subtracted to get the edge difference images. Secondly, in consideration of the fine image details and complex texture features of high resolution remote sensing images, in order to extract fully the depth features of a single image, a model with three branches based on VGG-16 network is constructed to extract the depth features of bitemporal images and edge difference images respectively. Finally, in order to improve the accuracy of the detection, the channel attention mechanism is embedded into the model to focus on the channel features with large amount of information to identify better the changed regions. The experimental results show that the proposed algorithm is superior to some existing methods in terms of visual interpretation and accuracy measurement.

-

Key words:

- Remote sensing image /

- Change detection /

- Deep learning /

- Attention mechanism /

- Edge change information

-

表 1 不同网络架构的变化检测定量结果对比(%)

架构 Acc Recall Precision F1 BASIC 99.63 90.77 95.15 92.91 BSE 99.66 91.50 95.67 93.54 本文EANet 99.67 92.35 95.38 93.85 表 2 不同算法的变化检测定量结果对比(%)

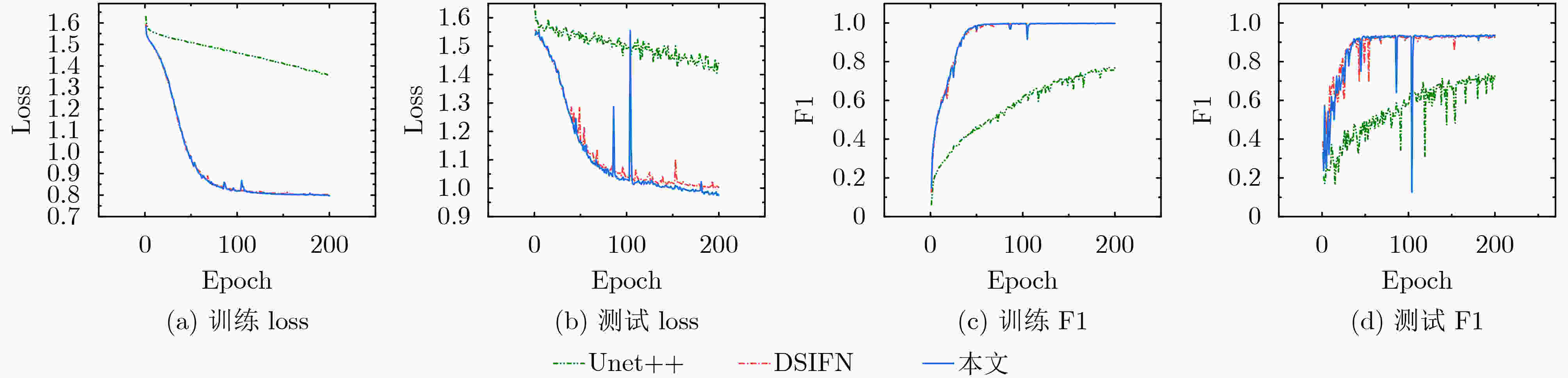

算法 Acc Recall Precision F1 PCA-Kmeans 90.57 10.95 10.09 10.50 Unet++ 98.41 92.37 63.98 75.60 DSIFN 99.64 91.78 94.54 93.14 本文 99.67 92.35 95.38 93.85 表 3 不同算法的计算效率结果对比

算法 FLOPs(G) Params(M) 训练时间(ms) Unet++ 38.11 9.20 95.86 DSIFN 63.00 50.44 115.35 本文 86.20 70.85 129.23 -

[1] 徐从安, 吕亚飞, 张筱晗, 等. 基于双重注意力机制的遥感图像场景分类特征表示方法[J]. 电子与信息学报, 2021, 43(3): 683–691. doi: 10.11999/JEIT200568XU Congan, LÜ Yafei, ZHANG Xiaohan, et al. A discriminative feature representation method based on dual attention mechanism for remote sensing image scene classification[J]. Journal of Electronics &Information Technology, 2021, 43(3): 683–691. doi: 10.11999/JEIT200568 [2] LYU H, LU Hui, MOU Lichao, et al. Long-term annual mapping of four cities on different continents by applying a deep information learning method to Landsat data[J]. Remote Sensing, 2018, 10(3): 471. doi: 10.3390/rs10030471 [3] 冀广宇, 梁兴东, 董勇伟, 等. 基于体散射约束的极化SAR相干变化检测方法[J]. 电子与信息学报, 2018, 40(10): 2461–2469. doi: 10.11999/JEIT180035JI Guangyu, LIANG Xingdong, DONG Yongwei, et al. Polarimetric SAR coherent change detection method based on volume scattering constraint[J]. Journal of Electronics &Information Technology, 2018, 40(10): 2461–2469. doi: 10.11999/JEIT180035 [4] HUANG Fenghua, YU Ying, and FENG Tinghao. Automatic building change image quality assessment in high resolution remote sensing based on deep learning[J]. Journal of Visual Communication and Image Representation, 2019, 63: 102585. doi: 10.1016/j.jvcir.2019.102585 [5] CHEN Jin, CHEN Xuehong, CUI Xihong, et al. Change vector analysis in posterior probability space: A new method for land cover change detection[J]. IEEE Geoscience and Remote Sensing Letters, 2011, 8(2): 317–321. doi: 10.1109/LGRS.2010.2068537 [6] LV Zhiyong, LIU Tongfei, SHI Cheng, et al. Novel land cover change detection method based on k-Means clustering and adaptive majority voting using bitemporal remote sensing images[J]. IEEE Access, 2019, 7: 34425–34437. doi: 10.1109/ACCESS.2019.2892648 [7] MALPICA J A, ALONSO M C, PAPÍ F, et al. Change detection of buildings from satellite imagery and lidar data[J]. International Journal of Remote Sensing, 2013, 34(5): 1652–1675. doi: 10.1080/01431161.2012.725483 [8] QIN Rongjun, HUANG Xin, GRUEN A, et al. Object-based 3-D building change detection on multitemporal stereo images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2015, 8(5): 2125–2137. doi: 10.1109/JSTARS.2015.2424275 [9] SAHA S, BOVOLO F, and BRUZZONE L. Unsupervised deep change vector analysis for multiple-change detection in VHR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(6): 3677–3693. doi: 10.1109/TGRS.2018.2886643 [10] CHEN Hongruixuan, WU Chen, DU Bo, et al. Deep siamese multi-scale convolutional network for change detection in multi-temporal VHR images[C]. The 2019 10th International Workshop on the Analysis of Multitemporal Remote Sensing Images, Shanghai, China, 2019: 1–4. [11] LONG J, SHELHAMER E, and DARRELL T. Fully convolutional networks for semantic segmentation[C]. 2015 IEEE Conference on Computer Vision and Pattern Recognition, Boston, USA, 2015: 3431–3440. [12] LAN Lingxiang, WU Dong, and CHI Mingmin. Multi-temporal change detection based on deep semantic segmentation networks[C]. The 2019 10th International Workshop on the Analysis of Multitemporal Remote Sensing Images, Shanghai, China, 2019: 1–4. [13] PENG Daifeng, ZHANG Yongjun, and GUAN Haiyan. End-to-end change detection for high resolution satellite images using improved UNet++[J]. Remote Sensing, 2019, 11(11): 1382. doi: 10.3390/rs11111382 [14] HOU Bin, WANG Yunhong, and LIU Qingjie. Change detection based on deep features and low rank[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(12): 2418–2422. doi: 10.1109/LGRS.2017.2766840 [15] DAUDT R C, LE SAUX B, and BOULCH A. Fully convolutional siamese networks for change detection[C]. The 2018 25th IEEE International Conference on Image Processing, Athens, Greece, 2018: 4063–4067. [16] ZHANG Chenxiao, YUE Peng, TAPETE D, et al. A deeply supervised image fusion network for change detection in high resolution bi-temporal remote sensing images[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 166: 183–200. doi: 10.1016/j.isprsjprs.2020.06.003 [17] JIANG Huiwei, HU Xiangyun, LI Kun, et al. PGA-SiamNet: Pyramid feature-based attention-guided Siamese network for remote sensing orthoimagery building change detection[J]. Remote Sensing, 2020, 12(3): 484. doi: 10.3390/rs12030484 [18] RONNEBERGER O, FISCHER P, and BROX T. U-Net: Convolutional networks for biomedical image segmentation[C]. The 18th International Conference on Medical Image Computing and Computer-Assisted Intervention, Munich, Germany, 2015: 234–241. [19] CANNY J. A computational approach to edge detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1986, PAMI-8(6): 679–698. doi: 10.1109/TPAMI.1986.4767851 [20] SIMONYAN K and ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[C]. The 3rd International Conference on Learning Representations, San Diego, USA, 2015: 1790–2022. [21] DENG Jia, DONG Wei, SOCHER R, et al. ImageNet: A large-scale hierarchical image database[C]. 2009 IEEE Conference on Computer Vision and Pattern Recognition, Miami, USA, 2009: 248–255. [22] HU Jie, SHEN Li, ALBANIE S, et al. Squeeze-and-excitation networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011–2023. doi: 10.1109/TPAMI.2019.2913372 [23] 倪黎, 邹卫军. 基于SE模块改进Xception的动物种类识别[J]. 导航与控制, 2020, 19(2): 106–111. doi: 10.3969/j.issn.1674-5558.2020.02.015NI Li and ZOU Weijun. Recognition of animal species based on improved Xception by SE module[J]. Navigation and Control, 2020, 19(2): 106–111. doi: 10.3969/j.issn.1674-5558.2020.02.015 [24] CHEN Hao and SHI Zhenwei. A spatial-temporal attention-based method and a new dataset for remote sensing image change detection[J]. Remote Sensing, 2020, 12(10): 1662. doi: 10.3390/rs12101662 -

下载:

下载:

下载:

下载: