Synchronous Frequency Hopping Signal Network Station Sorting Based on Underdetermined Blind Source Separation

-

摘要:

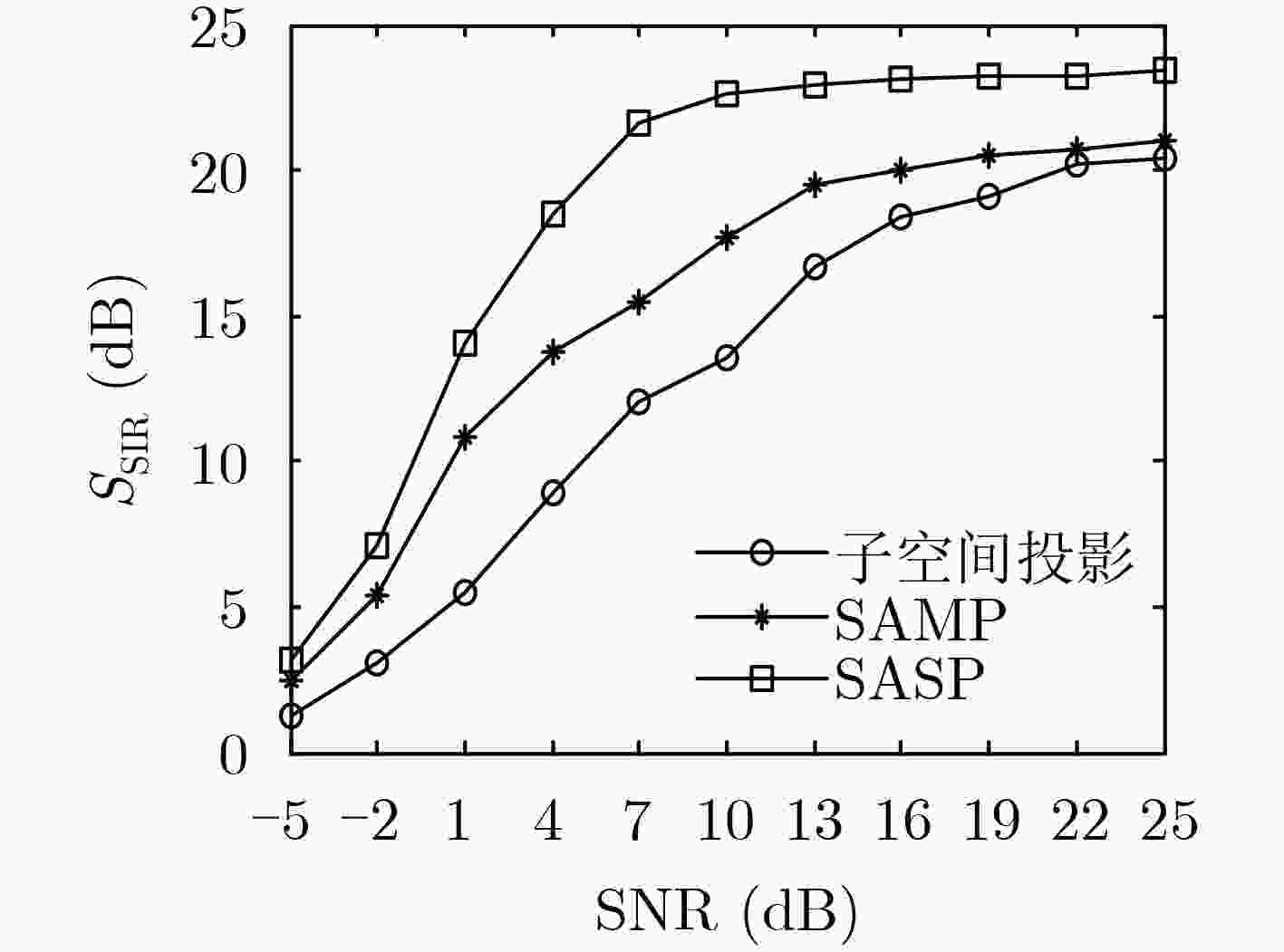

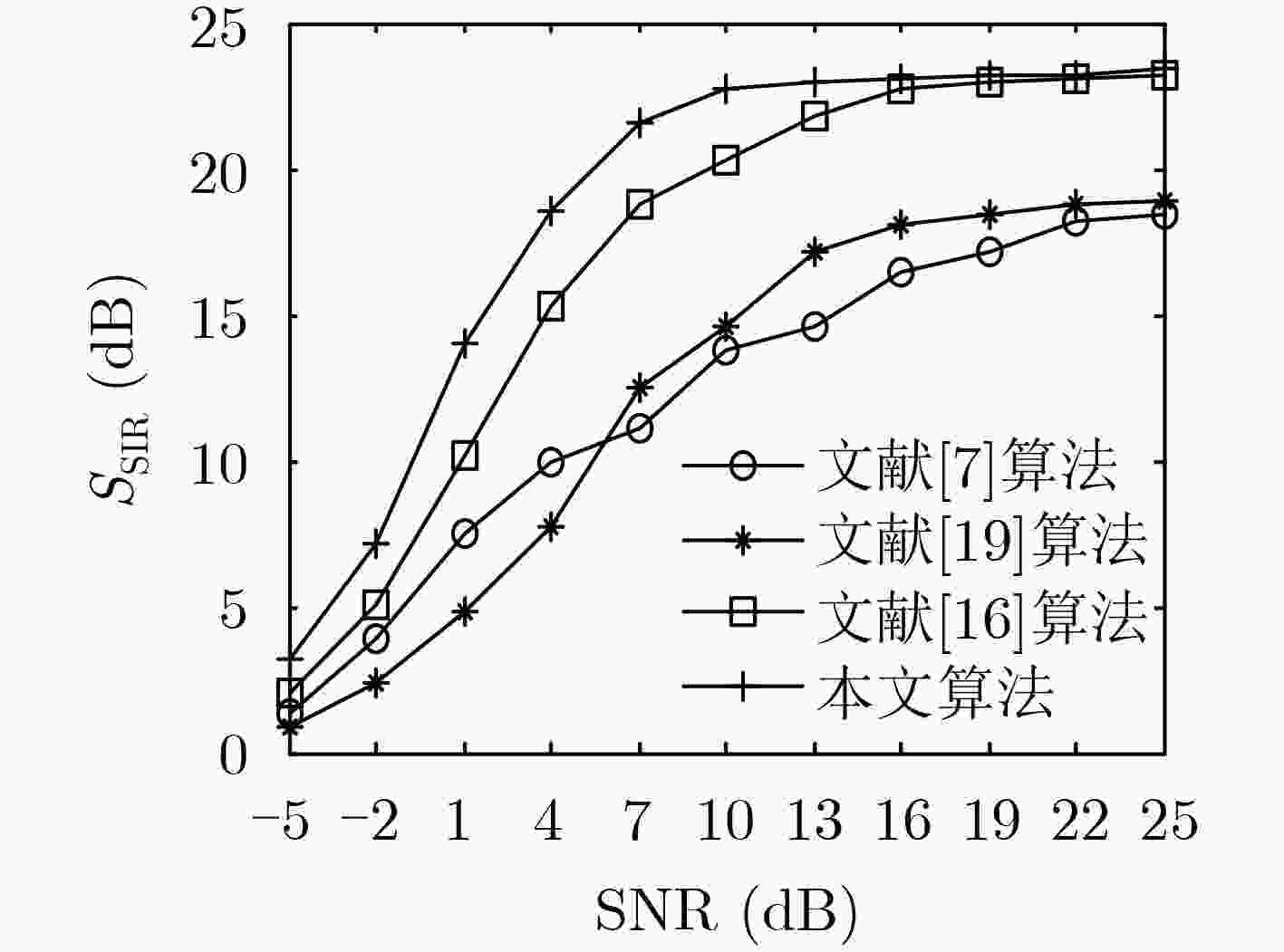

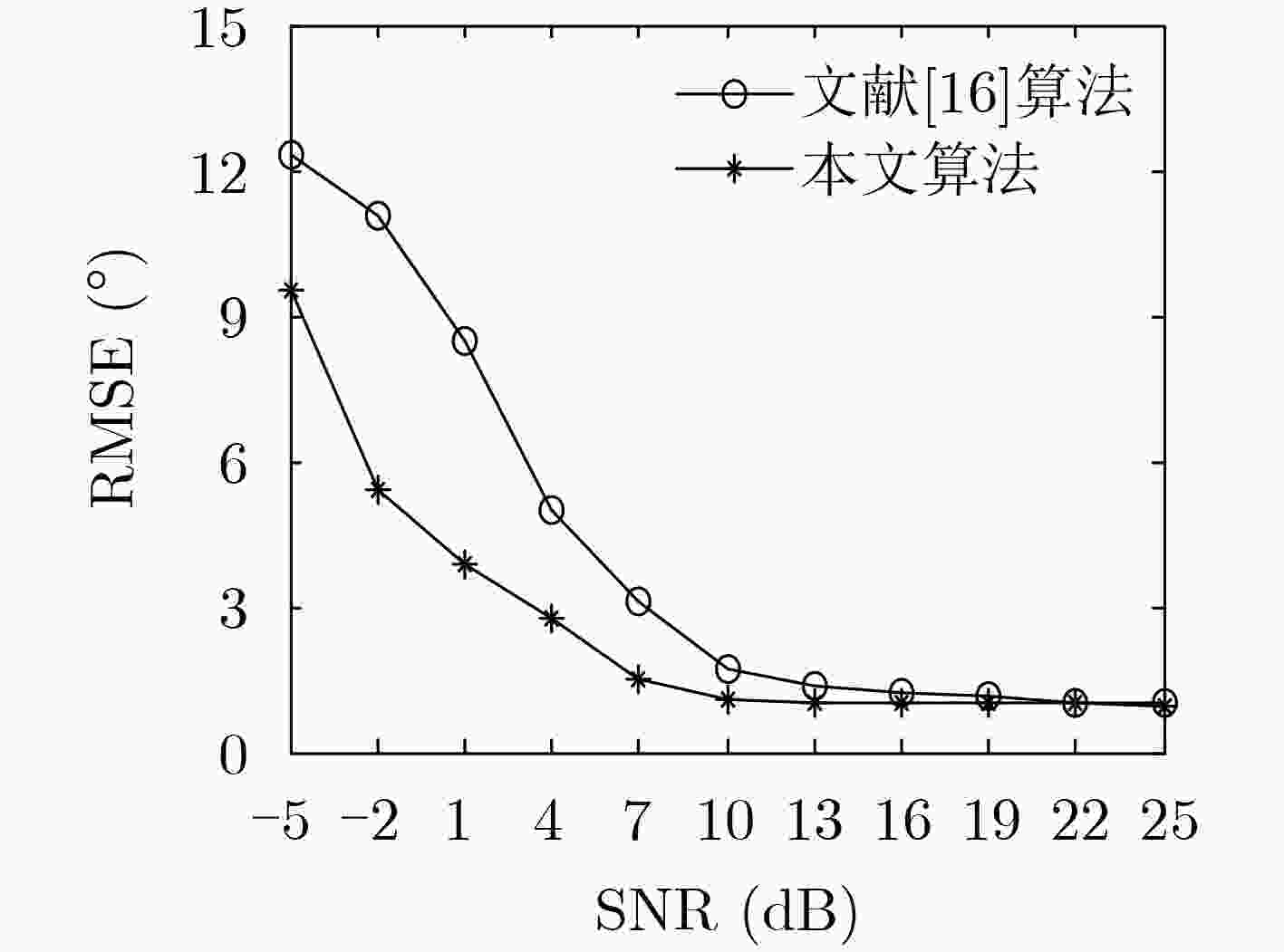

针对同步跳频(FH)网台分选问题,该文提出一种基于时频域单源点检测的欠定盲源分离(UBSS)分选算法。该算法首先对观测信号时频变换,利用自适应阈值去噪算法消除时频矩阵背景噪声,增加算法抗噪性能,然后根据信号绝对方位差算法进行单源点检测,有效保证单源点的充分稀疏性,并通过改进的模糊值聚类算法完成混合矩阵和2维波达方向估计,降低噪声和样本集分布差异对聚类结果的影响,提高估计精度。最后采用变步长的稀疏自适应子空间追踪(SASP)算法对源信号进行重构恢复。仿真实验表明,该算法在低信噪比(SNR)条件下,跳频信号波达方向估计和恢复精度较高,能够有效完成同步跳频信号的盲分离。

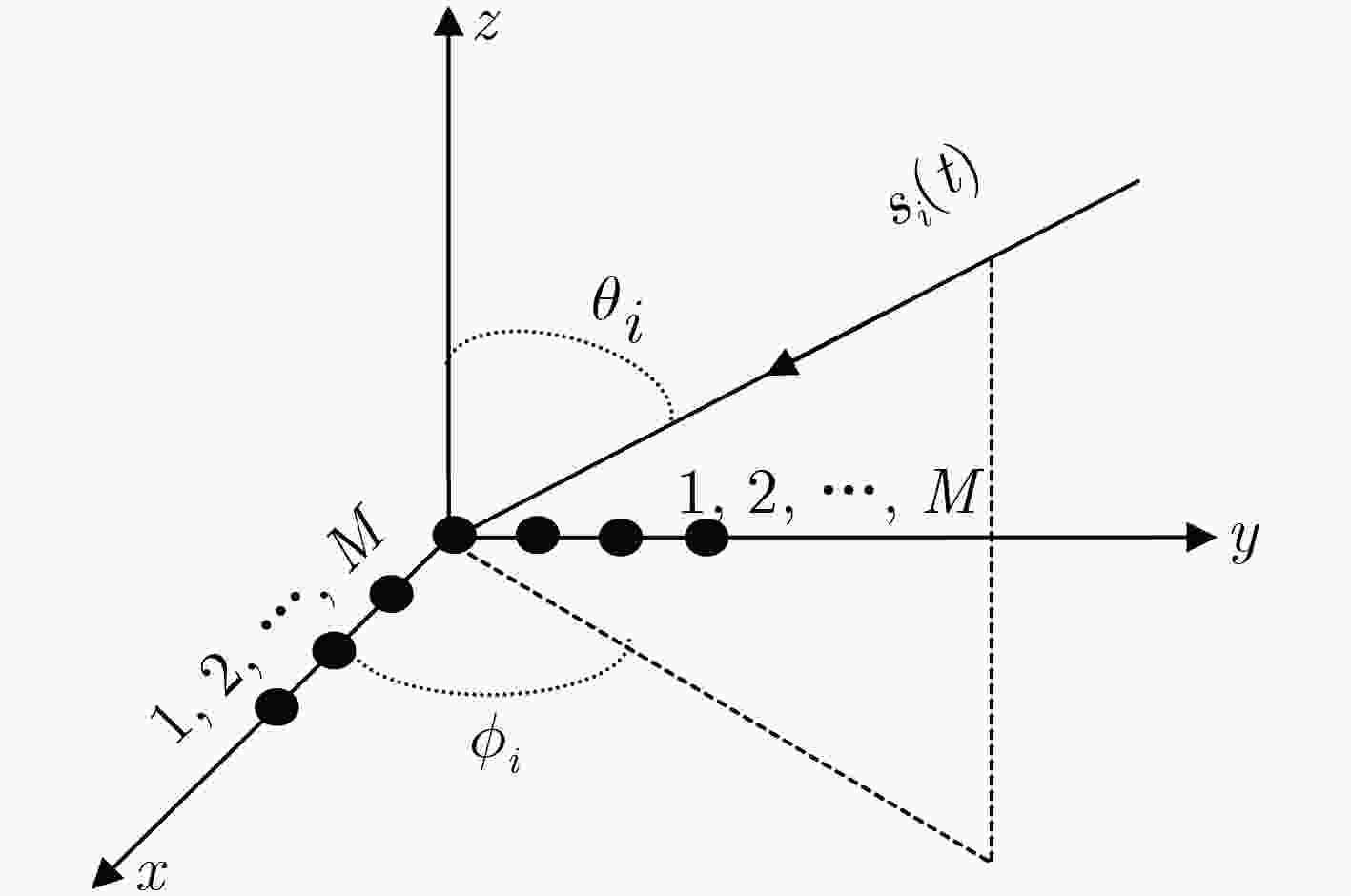

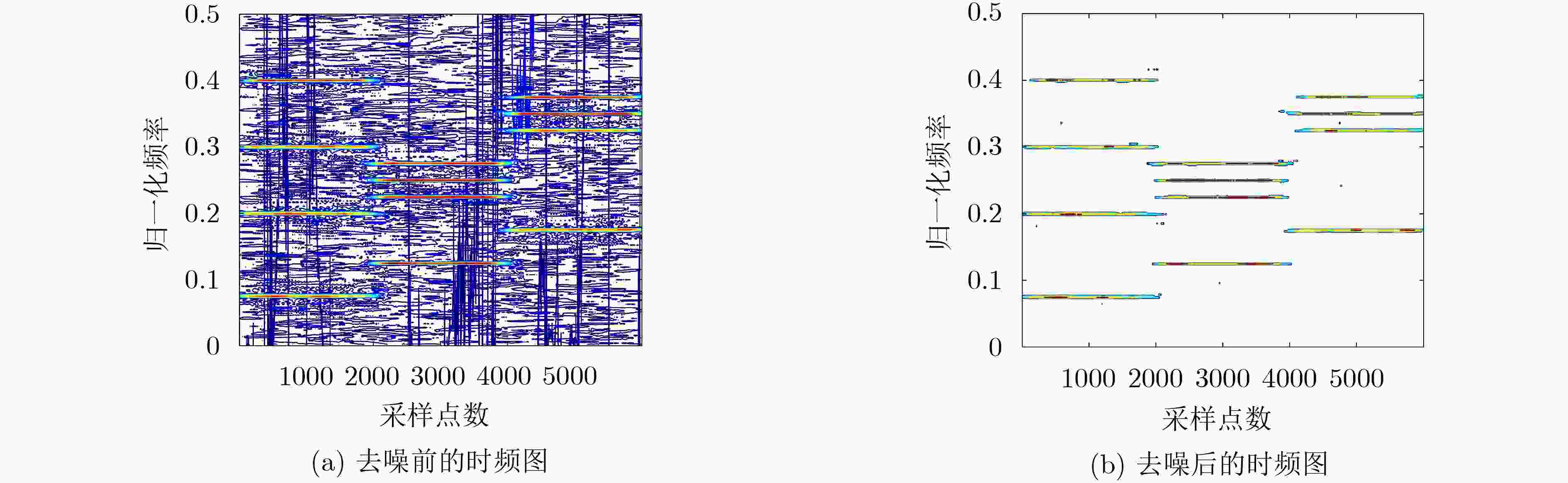

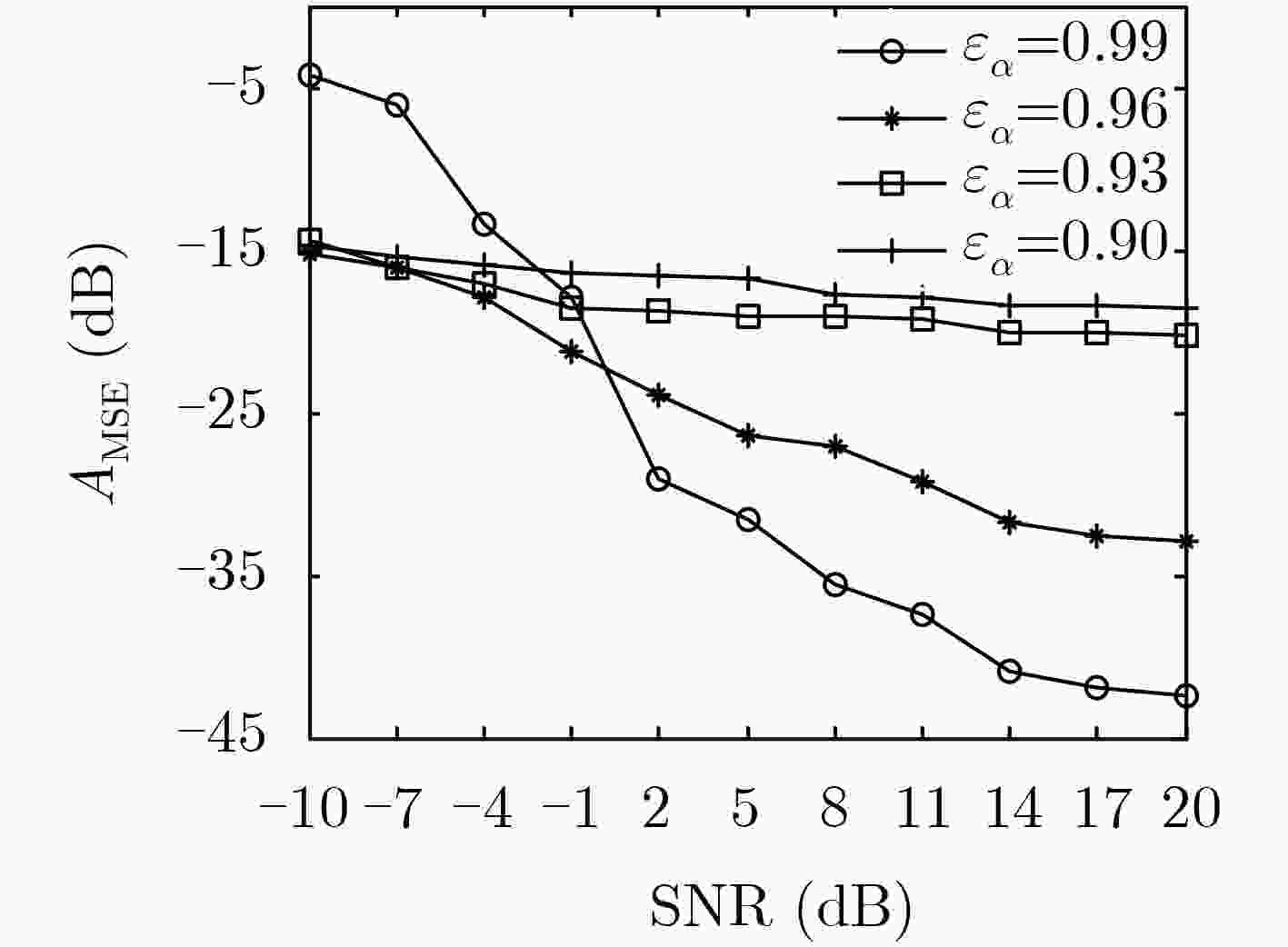

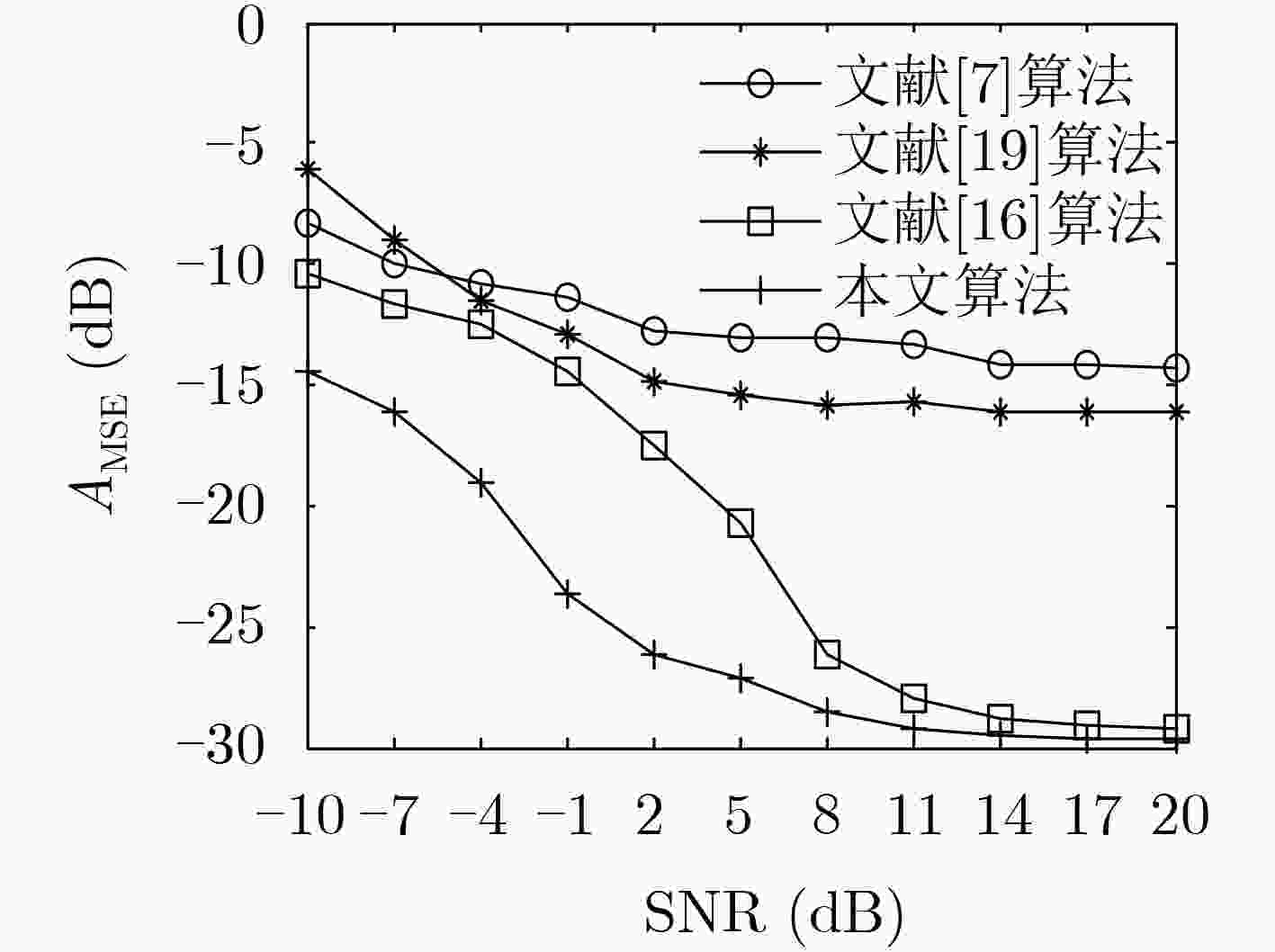

Abstract:Considering the problem of synchronous Frequency Hopping(FH) network station sorting, an Underdetermined Blind Source Separation(UBSS) algorithm based on time-frequency domain single source point detection is proposed. Firstly, the algorithm performs time-frequency transform on the observed signal, and uses adaptive threshold denoising algorithm to eliminate the background noise of the time-frequency matrix. It can increase the algorithm anti-noise performance. Then, single source point detection is performed according to the absolute azimuth difference of the signal. It can effectively ensure the sufficient sparsity of a single source point. The hybrid matrix estimation is completed by the improved fuzzy C value clustering algorithm. It can reduce the influence of noise and sample set distribution differences and improve the estimation accuracy. Finally, the source signal is reconstructed and restored by a variable step size Sparsity Adaptive Subspace Pursuit(SASP) algorithm. The simulation experiments show that the proposed algorithm has higher recovery accuracy of the frequency hopping signal under the condition of low Signal to Noise Ratio (SNR), and can effectively complete the blind separation of the synchronous frequency hopping signal.

-

Key words:

- Network sorting /

- Time-frequency transform /

- Single source point detection /

- Mixed matrix

-

表 1 各FH信源跳图案和方位参数

FH 跳图案(MHz) 方位/俯仰角(º) ${S_1}$ [1.5,4.5,6.5] 12/14 ${S_2}$ [4.0,2.5,7.0] 31/28 ${S_3}$ [6,5.5,7.5] 57/50 ${S_4}$ [8.0,5.0,3.5] 84/77 表 2 不同信噪比下相邻两跳的DOA和RMSE(°)

SNR=5 dB SNR=10 dB SNR=15 dB SNR=20 dB 第1跳FH信号DOA(º) ${S_1}$ 11.9198/15.1615 11.8283/14.4226 11.8012/14.4798 11.5617/13.2689 ${S_2}$ 31.3672/29.2193 31.6120/28.6810 31.1760/28.3617 31.7793/28.2577 ${S_3}$ 58.7108/51.0813 56.8921/50.6896 56.6015/50.6129 57.5726/50.4814 ${S_4}$ 84.6317/75.9538 85.5950/77.8221 85.6958/76.7450 84.7968/76.1847 RMSE 1.4634 1.1478 0.9883 0.9027 第2跳FH信号DOA(º) ${S_1}$ 11.8629/14.1215 12.1792/13.9243 11.4028/14.8058 11.0216/14.8689 ${S_2}$ 30.9463/29.4481 30.7387/27.3832 30.2968/28.6189 30.2267/28.1946 ${S_3}$ 56.7013/49.2631 57.7341/51.1026 56.1284/50.3891 57.3642/50.1739 ${S_4}$ 85.7185/78.5391 85.8328/76.3481 84.9185/77.6965 84.6301/77.2943 RMSE 1.4219 1.2273 1.0153 0.8653 -

张东伟, 郭英, 齐子森, 等. 多跳频信号波达方向与极化状态联合估计算法[J]. 电子与信息学报, 2015, 37(7): 1695–1701. doi: 10.11999/JEIT141315ZHANG Dongwei, GUO Ying, QI Zisen, et al. Joint estimation algorithm of direction of arrival and polarization for multiple frequency-hopping signals[J]. Journal of Electronics &Information Technology, 2015, 37(7): 1695–1701. doi: 10.11999/JEIT141315 KOLDOVSKÝ Z, TICHAVSKÝ P, PHAN A H, et al. A two-stage MMSE beamformer for underdetermined signal separation[J]. IEEE Signal Processing Letters, 2013, 20(12): 1227–1230. doi: 10.1109/LSP.2013.2285932 ZOU Liang, CHEN Xun, JI Xiangyang, et al. Underdetermined joint blind source separation of multiple datasets[J]. IEEE Access, 2017, 5: 7474–7487. doi: 10.1109/ACCESS.2017.2695497 SU Qiao, WEI Yimin, DENG Changliang, et al. Fast extraction for skewed source signals using conditional expectation[J]. Journal of Sensors, 2018, 2018: 6804197. doi: 10.1155/2018/6804197 PENG Tianliang, CHEN Yang, and LIU Zengli. A time-frequency domain blind source separation method for underdetermined instantaneous mixtures[J]. Circuits, Systems, and Signal Processing, 2015, 34(12): 3883–3895. doi: 10.1007/s00034-015-0035-3 BOFILL P and ZIBULEVSKY M. Underdetermined blind source separation using sparse representations[J]. Signal Processing, 2001, 81(11): 2353–2362. doi: 10.1016/S0165-1684(01)00120-7 YE Fang, CHEN Jie, GAO Lipeng, et al. A mixing matrix estimation algorithm for the time-delayed mixing model of the underdetermined blind source separation problem[J]. Circuits, Systems, and Signal Processing, 2019, 38(4): 1889–1906. doi: 10.1007/s00034-018-0930-5 ZHEN Liangli, PENG Dezhong, YI Zhang, et al. Underdetermined blind source separation using sparse coding[J]. IEEE Transactions on Neural Networks and Learning Systems, 2017, 28(12): 3102–3108. doi: 10.1109/TNNLS.2016.2610960 付卫红, 马丽芬, 李爱丽. 基于改进K-均值聚类的欠定混合矩阵盲估计[J]. 系统工程与电子技术, 2014, 36(11): 2143–2148. doi: 10.3969/j.issn.1001-506X.2014.11.06FU Weihong, MA Lifen, and LI Aili. Blind estimation of underdetermined mixing matrix based on improved K-means clustering[J]. Systems Engineering and Electronics, 2014, 36(11): 2143–2148. doi: 10.3969/j.issn.1001-506X.2014.11.06 COBOS M and LOPEZ J J. Maximum a posteriori binary mask estimation for underdetermined source separation using smoothed posteriors[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2012, 20(7): 2059–2064. doi: 10.1109/TASL.2012.2195654 ZIBULEVSKY M and PEARLMUTTER B A. Blind source separation by sparse decomposition in a signal dictionary[J]. Neural Computation, 2001, 13(4): 863–882. doi: 10.1162/089976601300014385 MOURAD N, REILLY J P, and KIRUBARAJAN T. Majorization-minimization for blind source separation of sparse sources[J]. Signal Processing, 2017, 131: 120–133. doi: 10.1016/j.sigpro.2016.08.015 王川川, 曾勇虎, 汪连栋. 基于压缩感知的欠定源信号恢复算法比较[J]. 强激光与粒子束, 2018, 30(5): 053202. doi: 10.11884/HPLPB201830.170354WANG Chuanchuan, ZENG Yonghu, and WANG Liandong. Comparison of source signal recovery algorithms based on compressed sensing for underdetermined blind source separation[J]. High Power Laser and Particle Beams, 2018, 30(5): 053202. doi: 10.11884/HPLPB201830.170354 于欣永, 郭英, 张坤峰, 等. 基于盲源分离的多跳频信号网台分选算法[J]. 信号处理, 2017, 33(8): 1082–1089. doi: 10.16798/j.issn.1003-0530.2017.08.008YU Xinyong, GUO Ying, ZHANG Kunfeng, et al. A network sorting algorithm based on blind source separation of multi-FH signal[J]. Journal of Signal Processing, 2017, 33(8): 1082–1089. doi: 10.16798/j.issn.1003-0530.2017.08.008 唐宁, 郭英, 张坤峰. 基于SCA的欠定跳频网台分选方法[J]. 系统工程与电子技术, 2017, 39(12): 2817–2823. doi: 10.3969/j.issn.1001-506X.2017.12.27TANG Ning, GUO Ying, and ZHANG Kunfeng. Underdetermined frequency-hopping network sorting method on the basis of SCA[J]. Systems Engineering and Electronics, 2017, 39(12): 2817–2823. doi: 10.3969/j.issn.1001-506X.2017.12.27 ZHANG Chaozhu, WANG Yu, and JING Fulong. Underdetermined blind source separation of synchronous orthogonal frequency hopping signals based on single source points detection[J]. Sensors, 2017, 17(9): 2074. doi: 10.3390/s17092074 李红光, 郭英, 张坤峰, 等. 基于自适应网格的跳频信号参数估计[J]. 系统工程与电子技术, 2019, 41(8): 1865–1872. doi: 10.3969/j.issn.1001-506X.2019.08.26LI Hongguang, GUO Ying, ZHANG Kunfeng, et al. Parameter estimation of frequency hopping signals based on adaptive mesh[J]. Systems Engineering and Electronics, 2019, 41(8): 1865–1872. doi: 10.3969/j.issn.1001-506X.2019.08.26 FIJAVŽ G and MOHAR B. Rigidity and separation indices of Paley graphs[J]. Discrete Mathematics, 2004, 289(1/3): 157–161. doi: 10.1016/j.disc.2004.09.004 付卫红, 武少豪, 刘乃安, 等. 跳频信号的欠定盲源分离[J]. 北京邮电大学学报, 2015, 38(6): 11–14. doi: 10.13190/j.jbupt.2015.06.003FU Weihong, WU Shaohao, LIU Naian, et al. Underdetermined blind source separation of frequency hopping signal[J]. Journal of Beijing University of Posts and Telecommunications, 2015, 38(6): 11–14. doi: 10.13190/j.jbupt.2015.06.003 -

下载:

下载:

下载:

下载: