DroneRFa: A Large-scale Dataset of Drone Radio Frequency Signals for Detecting Low-altitude Drones

-

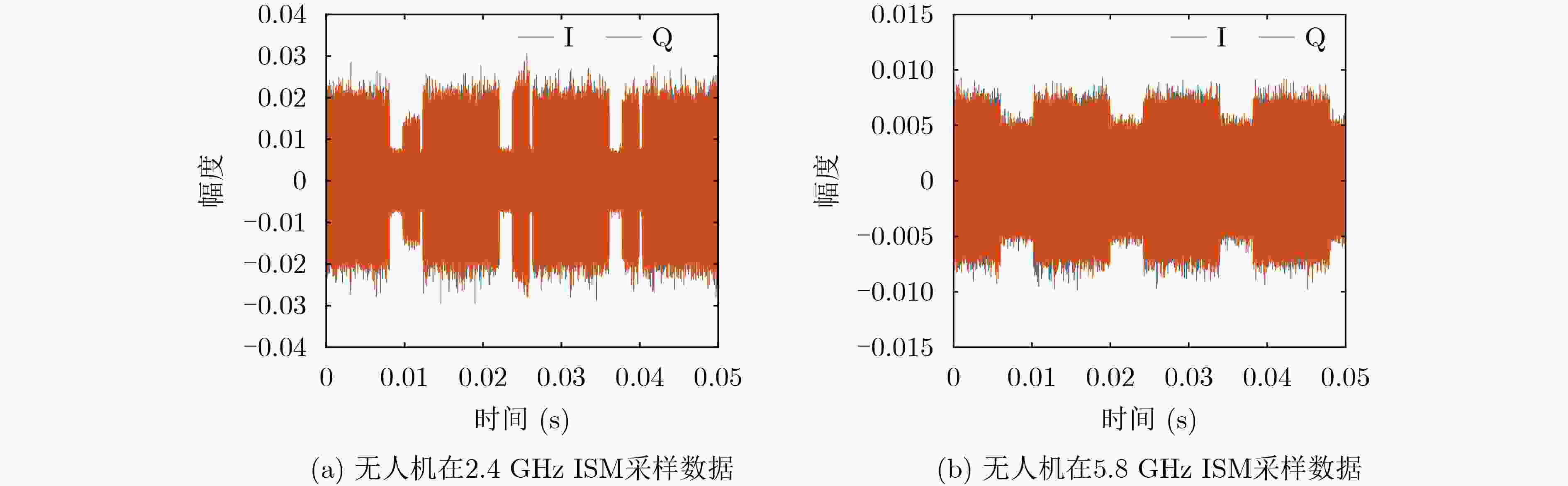

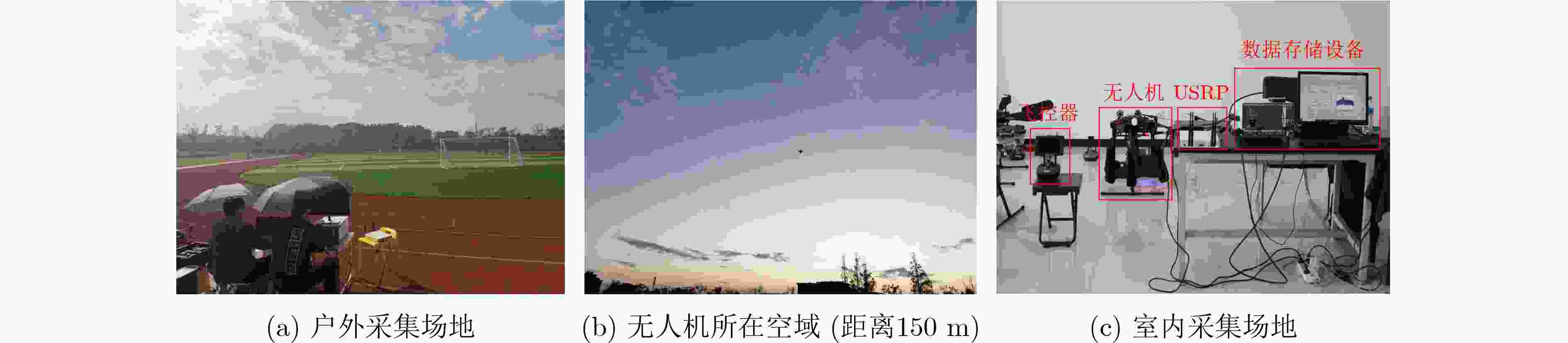

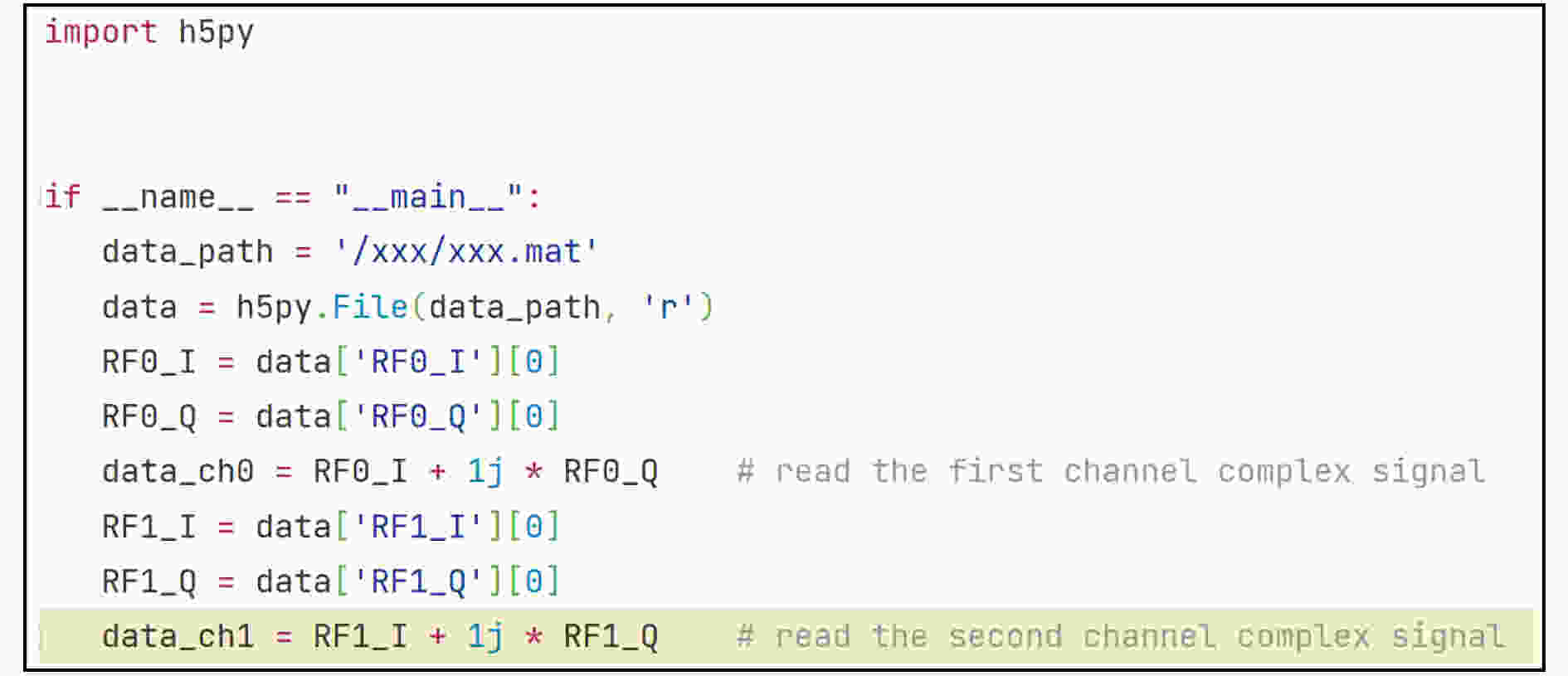

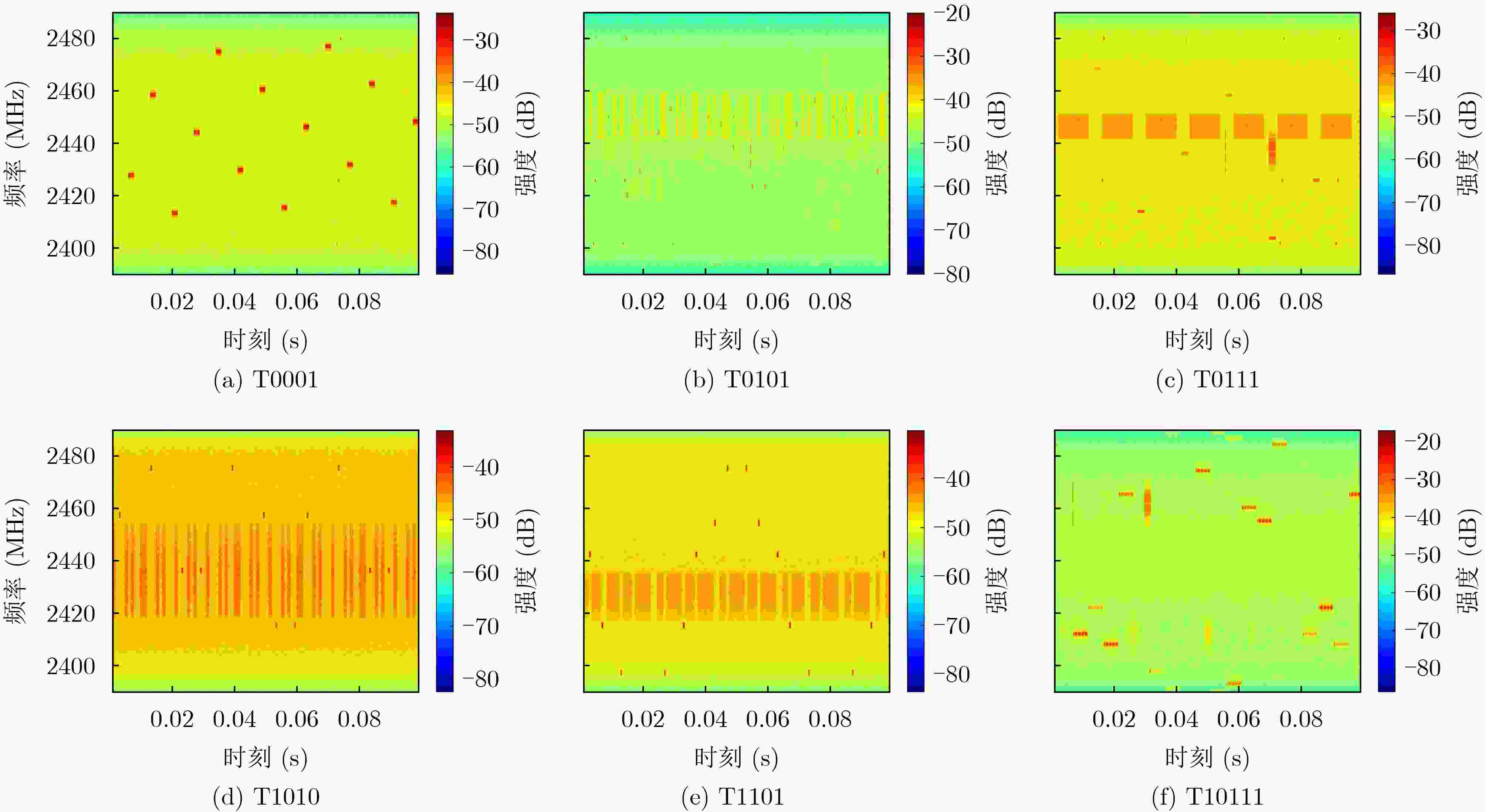

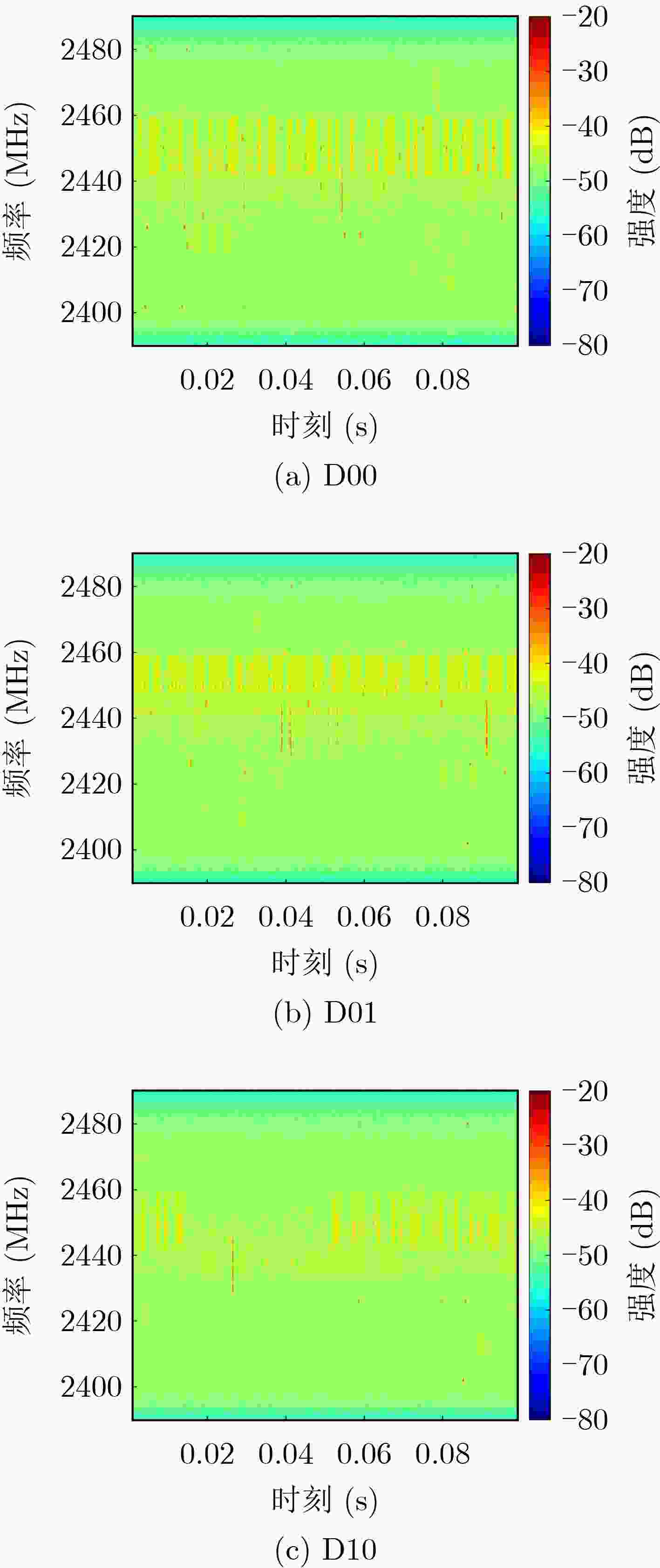

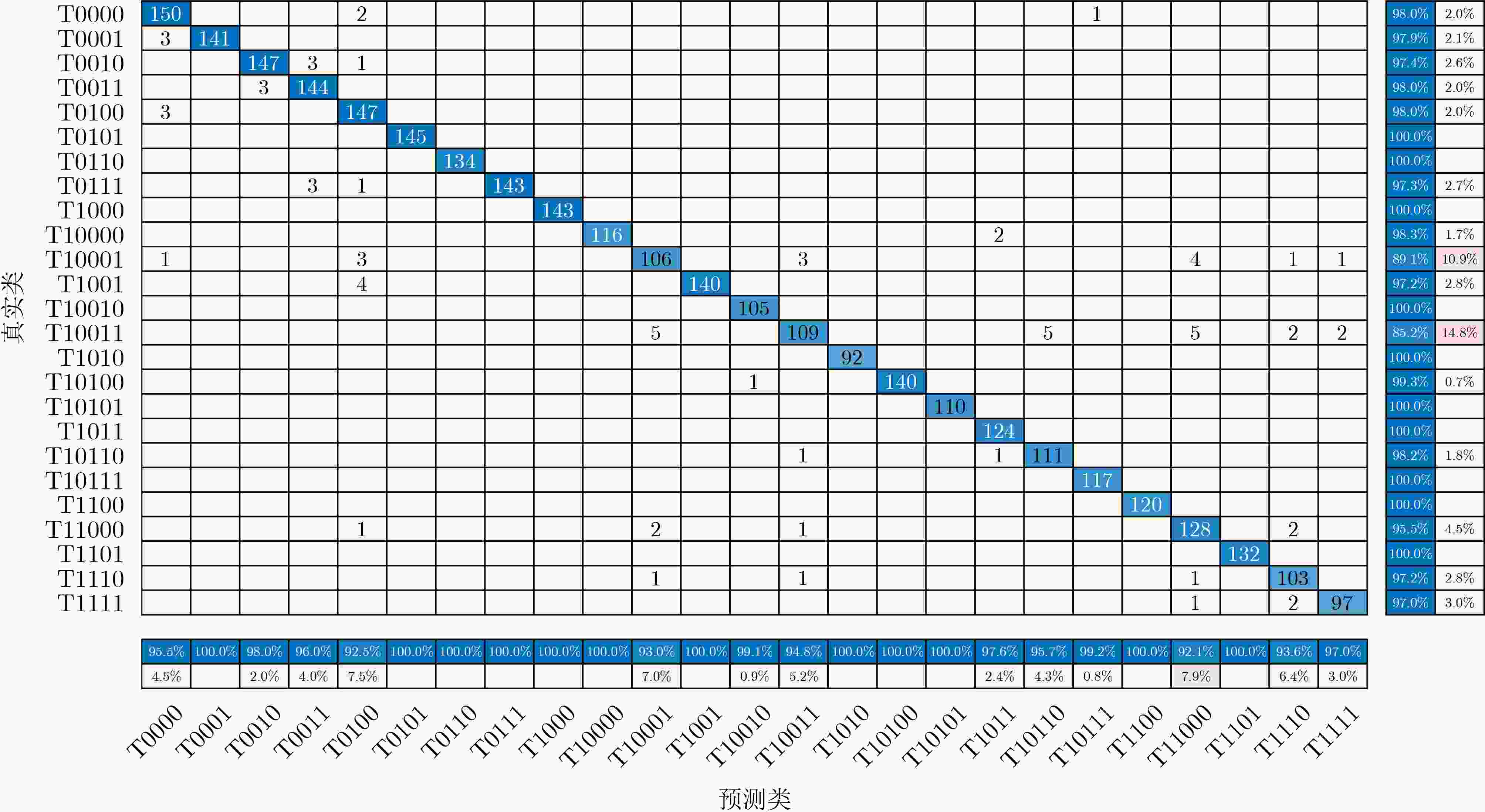

摘要: 为研究与发展反无人机检测识别技术,该文公开了一个名为DroneRFa的大规模无人机射频信号数据集。该数据集使用软件无线电设备探测无人机与遥控器相互通信的射频信号,包含城市户外场景下运动无人机信号9类、城市室内场景下信号15类以及背景参照信号1类。每类数据有不少于12个片段,每个片段包含1亿个以上的采样点。数据采集覆盖了3个ISM无线电频段,记录无人机多频通信的真实活动。该数据集具有详细的无人机户外飞行距离和工作频段标注,以前缀字符结合二进制编码的形式方便用户灵活访问所需数据。此外,该文提供了基于频谱可视统计特征和基于深度学习表征的两种无人机识别方案,以验证数据集的可靠和有效性。Abstract: A large-scale dataset of drone radio frequency signals, namely DroneRFa, is constructed to research and develop anti-drone detection and recognition technologies. This dataset uses a software-defined radio device to monitor communication signals between drones and their controllers, including 9 types of flying drone signals in an outdoor environment, 15 types of drone signals in an indoor environment, and 1 type of background signal as a reference. Each type of data has no less than 12 segments, each containing more than 100 million sampling points. The data acquisition covered three Industrial Scientific Medical (ISM) radio bands, and recorded the multifrequency communication activity of drones. The dataset has detailed flying distance and communication frequency band labeling, which are represented with prefix characters and binary codes to facilitate easy access to specific data required by users. Furthermore, this paper proposes two drone identification schemes based on spectral and visual statistical features and deep learning representation to verify the reliability and validity of the dataset.

-

表 1 近年全球无人机事件

时间 国家(地区) 行业/性质 事件 2021年10月7日 美国(加利福尼亚) 走私 一架微型大疆(DJI)无人机通过美国边境墙走私其自身重量的毒品 2022年4月19日 法国(马赛) 执法 无人机飞手因在法国总统马克龙讲话的禁区内驾驶无人机被捕 2022年4月23日 意大利(罗马) 公共安全 游客操作无人机不当导致无人机撞向罗马和比萨的意大利地标 2022年7月27日 中国(海口) 公共安全 摄影师在铁路线上擅自操作DJI Mini 2无人机被海口铁路公安逮捕并罚款 2022年9月2日 美国(加利福尼亚) 个人隐私 无人机非法入侵住宅窥探女子隐私 2022年9月28日 美国(华盛顿) 政府 无人机进入禁区造成白宫紧急疏散 2022年10月2日 中国(武汉) 个人隐私 一名妇女指控无人机多次侵犯她的隐私并拍摄她住宅信息 2023年2月21日 爱尔兰(都柏林) 机场 无人机入侵导致都柏林机场的航班暂时停止 表 2 反无人机探测基本手段优劣势比较

探测手段 探测距离 优势 劣势 视觉 适中(1~2 km) 成本适中,属于被动探测隐蔽性好,

结果直观,对环境无影响易受遮挡物影响,对光线强度变化敏感,红外传感器成本高,光电传感器无法在夜间工作 声音 近(<150 m) 成本低,属于被动探测隐蔽性好,对环境无影响 城市环境受噪声影响大 雷达 较远(3~8 km) 覆盖范围广,可测目标运动速度 受杂波干扰大,低空低速目标探测难,设备成本高,瞬时辐射强不适用于城市环境 射频(被动) 远(1~5 km) 电磁特性不易隐藏可靠性好,属于被动探测隐蔽性好,对环境无影响 受同频杂波干扰大,设备成本较高 表 3 二进制编码与标签对应关系

前缀字符 二进制编码 含义说明(T型号/D探测距离/S信号片段) T 0000 背景(含蓝牙、WiFi) T 0001 DJI Phantom 3 T 0010 DJI Phantom 4 Pro T 0011 DJI MATRICE 200 T 0100 DJI MATRICE 100 T 0101 DJI Air 2S T 0110 DJI Mini 3 Pro T 0111 DJI Inspire 2 T 1000 DJI Mavic Pro T 1001 DJI Mini 2 T 1010 DJI Mavic 3 T 1011 DJI MATRICE 300 T 1100 DJI Phantom 4 Pro RTK T 1101 DJI MATRICE 30T T 1110 DJI AVATA T 1111 DJI通信模块自组机 T 10000 DJI MATRICE 600 Pro T 10001 VBar 飞控器 T 10010 FrSky X20 飞控器 T 10011 Futaba T6IZ 飞控器 T 10100 Taranis Plus 飞控器 T 10101 RadioLink AT9S 飞控器 T 10110 Futaba T14SG 飞控器 T 10111 云卓 T12 飞控器 T 11000 云卓 T10 飞控器 D 00 20~40 m D 01 40~80 m D 10 80~150 m S 0000~0111 设置初始通信在915 MHz或2.4 GHz S 1000~1111 若设备支持则切换至2.4 GHz或5.8 GHz 表 4 无人机射频信号统计特征表

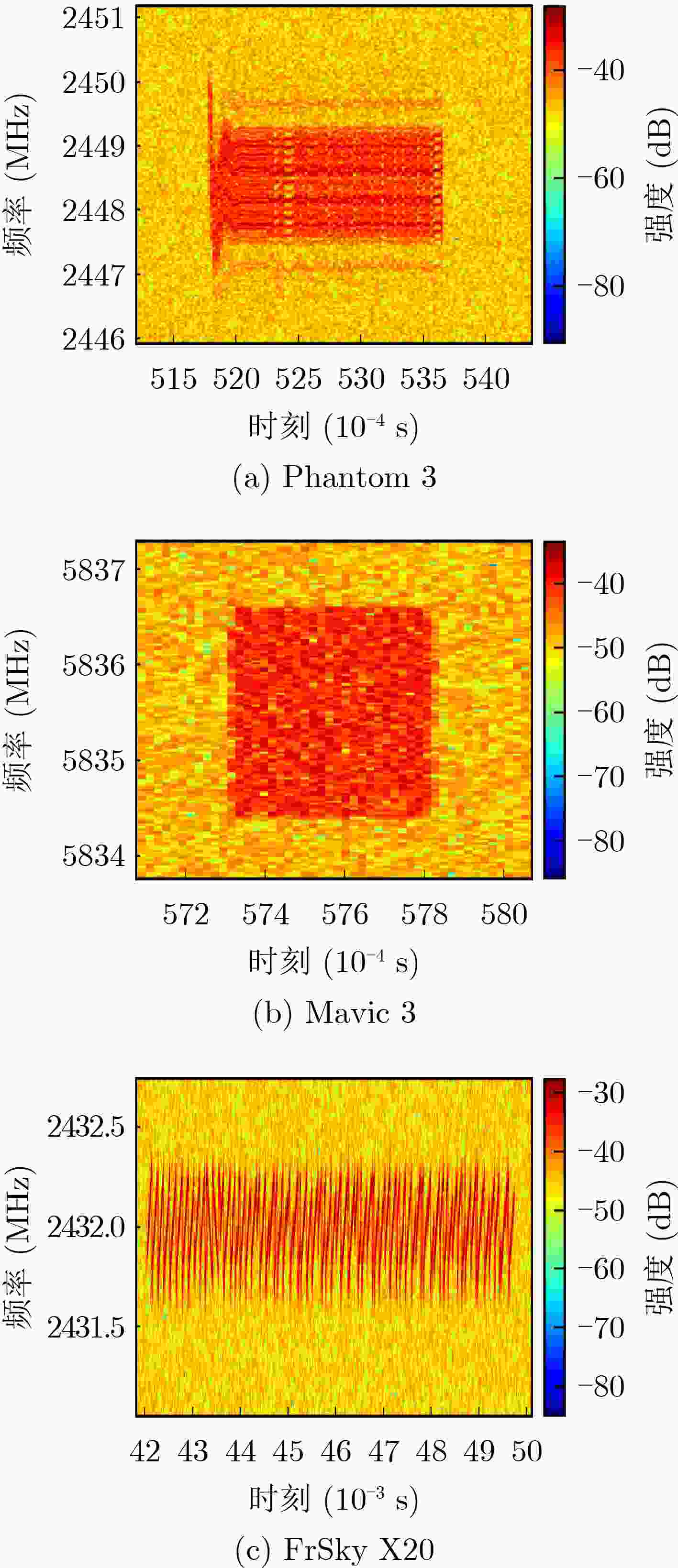

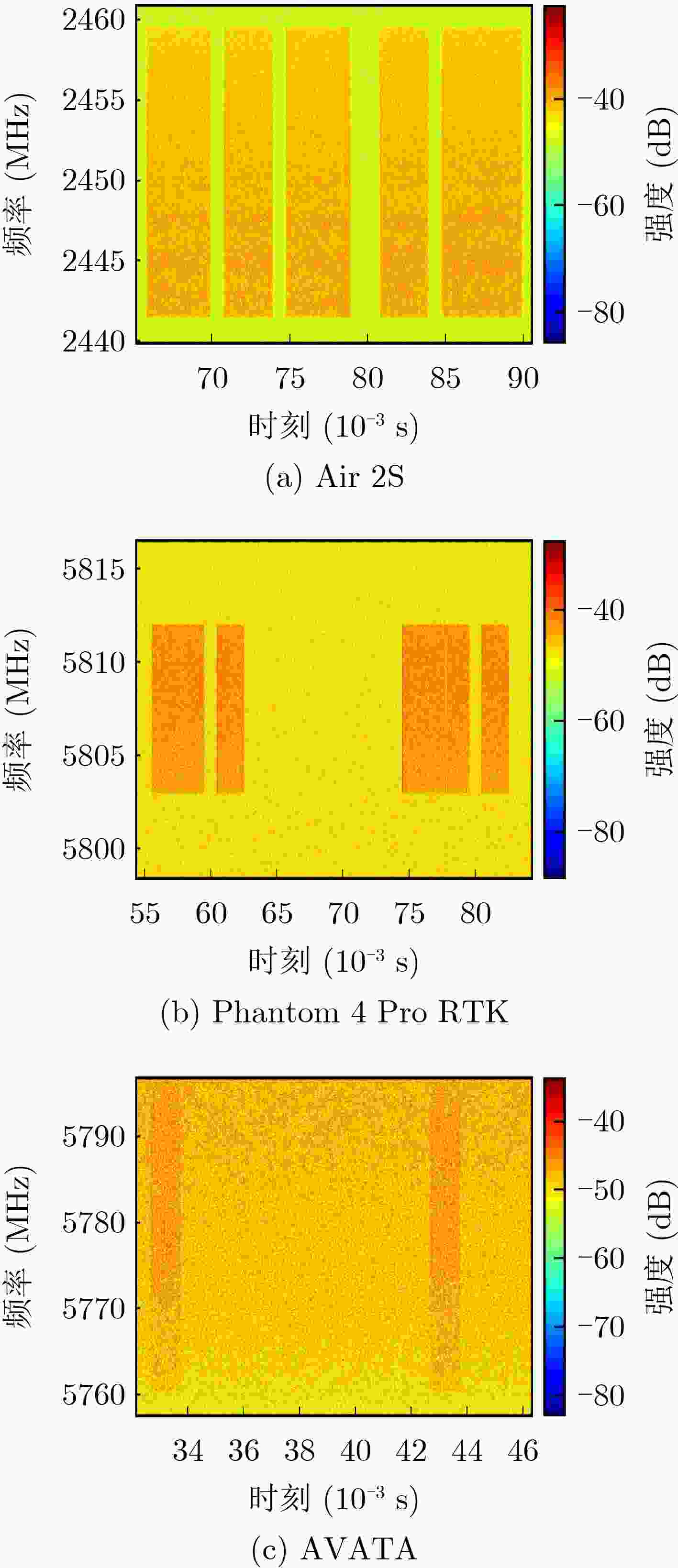

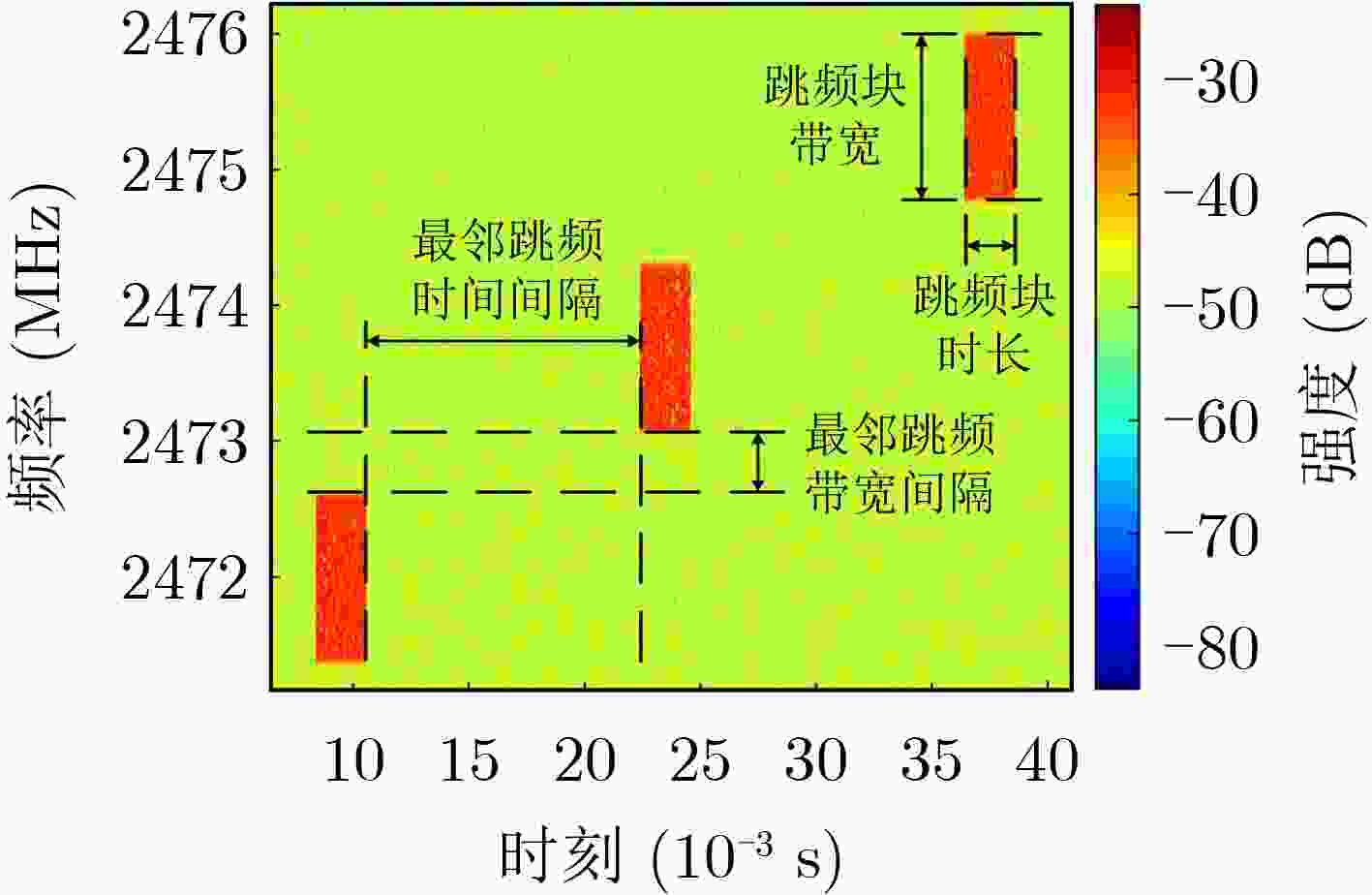

机型 跳频

信号

带宽

(MHz)跳频

信号

时长

(ms)最邻跳

频块时

间间

隔(ms)最邻跳

频块带

宽间

隔(MHz)图传

信号

周期

(ms)图传

信号

占空

比(%)Phantom 3 1.8 1.8 5.2 28 / / Phantom 4 Pro 1.2 2.2 12 0.45 14 68 MATRICE 200 1.2 2.2 12 21 14 68 MATRICE 100 1.2 2.2 12 6.8 / / Air 2S 2.2 0.52 / / / / Mini 3 Pro 2.2 0.52 / / / / Inspire 2 1.2 2.2 12 21 14 68 Mavic Pro 1.1 0.52 / / / / Mini 2 1.1 0.52 / / / / Mavic 3 2.2 0.52 / / / / MATRICE 300 2.2 0.52 / / / / Phantom 4 Pro RTK 1.1 0.52 5.5 8.2 / / MATRICE 30T 2.2 0.52 / / / / AVATA 1.1 0.52 / / 10 12 大疆通信模块自组机 1.1 0.52 / / / / MATRICE 600 Pro 1.2 2.2 12 40 14 68 VBar 飞控器 0.72 1.8 / / / / FrSky X20 飞控器 0.42 2.8 4.0 4.2 / / Futaba T6IZ 飞控器 2.0 1.4 / / / / Taranis Plus飞控器 0.75 7.9 12 1.0 / / RadioLink AT9S飞控器 5.0 2.1 / / / / Futaba T14SG 飞控器 2.0 2.0 5.0 20 / / 云卓 T12 飞控器 1.7 4.6 / / / / 云卓 T10 飞控器 1.8 0.3 / / / / 表 5 深度神经网络模型在不同输入信号下的识别性能比较

组号 信号长度($T$) 分辨率($N$) 准确率 精确率 召回率 F值 fps 1(基准) 1024 1024 0.9773 0.9776 0.9774 0.9773 53 2 768 1024 0.9577 0.9578 0.9563 0.9566 66 3 512 1024 0.9030 0.9051 0.9016 0.9016 93 4 256 1024 0.7271 0.7373 0.7278 0.7301 154 5 1024 512 0.9686 0.9704 0.9689 0.9693 92 6 1024 256 0.9145 0.9188 0.9146 0.9154 154 7 1024 128 0.8785 0.8859 0.8799 0.8810 217 -

[1] BIKOV T, MIHAYLOV G, ILIEV T, et al. Drone surveillance in the modern agriculture[C]. Proceedings of the 8th International Conference on Energy Efficiency and Agricultural Engineering, Ruse, Bulgaria, 2022: 1–4. [2] QUBAA A R, THANNOUN R G, and MOHAMMED R M. UAVs/drones for photogrammetry and remote sensing: Nineveh archaeological region as a case study[J]. World Journal of Advanced Research and Reviews, 2022, 14(3): 358–368. doi: 10.30574/wjarr.2022.14.3.0539. [3] QU Chengyi, SORBELLI F B, SINGH R, et al. Environmentally-aware and energy-efficient multi-drone coordination and networking for disaster response[J]. IEEE Transactions on Network and Service Management, 2023, 20(2): 1093–1109. doi: 10.1109/TNSM.2023.3243543. [4] Team DRONEII. com. Global drone market report 2022–2030[EB/OL]. https://droneii.com/product/drone-market-report, 2023. [5] Dedrone. Worldwide drone incidents[EB/OL]. https://www.dedrone.com/resources/incidents-new/all, 2023. [6] 宋晨, 周良将, 吴一戎, 等. 基于自相关-倒谱联合分析的无人机旋翼转动频率估计方法[J]. 电子与信息学报, 2019, 41(2): 255–261. doi: 10.11999/JEIT180399.SONG Chen, ZHOU Liangjiang, WU Yirong, et al. An estimation method of rotation frequency of unmanned aerial vehicle based on auto-correlation and cepstrum[J]. Journal of Electronics &Information Technology, 2019, 41(2): 255–261. doi: 10.11999/JEIT180399. [7] 杨勇, 王雪松, 张斌. 基于时频检测与极化匹配的雷达无人机检测方法[J]. 电子与信息学报, 2021, 43(3): 509–515. doi: 10.11999/JEIT200768.YANG Yong, WANG Xuesong, and ZHANG Bin. Radar detection of unmanned aerial vehicles based on time-frequency detection and polarization matching[J]. Journal of Electronics &Information Technology, 2021, 43(3): 509–515. doi: 10.11999/JEIT200768. [8] 张霞, 余道杰, 刘广怡, 等. 一种无人机蜂群飞行同步检测和抑制方案[J]. 电子与信息学报, 2023, 45(12): 4317–4326.ZHANG Xia, YU Daojie, LIU Guangyi, et al. Countermeasures against UAV swarm through detection and suppression of fly synchronization[J]. Journal of Electronics & Information Technology, 2023, 45(12): 4317–4326. [9] SHI Xiufang, YANG Chaoqun, XIE Weige, et al. Anti-drone system with multiple surveillance technologies: Architecture, implementation, and challenges[J]. IEEE Communications Magazine, 2018, 56(4): 68–74. doi: 10.1109/MCOM.2018.1700430. [10] SHI Zhiguo, CHANG Xianyu, YANG Chaoqun, et al. An acoustic-based surveillance system for amateur drones detection and localization[J]. IEEE Transactions on Vehicular Technology, 2020, 69(3): 2731–2739. doi: 10.1109/TVT.2020.2964110. [11] ZHANG Zongyu, SHI Zhiguo, and GU Yujie. Ziv-Zakai bound for DOAs estimation[J]. IEEE Transactions on Signal Processing, 2023, 71: 136–149. doi: 10.1109/TSP.2022.3229946. [12] GUVENC I, KOOHIFAR F, SINGH S, et al. Detection, tracking, and interdiction for amateur drones[J]. IEEE Communications Magazine, 2018, 56(4): 75–81. doi: 10.1109/MCOM.2018.1700455. [13] KHAN M A, MENOUAR H, ELDEEB A, et al. On the detection of unauthorized drones-techniques and future perspectives: A review[J]. IEEE Sensors Journal, 2022, 22(12): 11439–11455. doi: 10.1109/JSEN.2022.3171293. [14] ALLAHHAM M H D S, AL-SA'D M F, AL-ALI A, et al. DroneRF dataset: A dataset of drones for RF-based detection, classification and identification[J]. Data in Brief, 2019, 26: 104313. doi: 10.1016/j.dib.2019.104313. [15] BISIO I, GARIBOTTO C, LAVAGETTO F, et al. Blind detection: Advanced techniques for WiFi-based drone surveillance[J]. IEEE Transactions on Vehicular Technology, 2019, 68(1): 938–946. doi: 10.1109/TVT.2018.2884767. [16] XIE Yuelei, JIANG Ping, GU Yi, et al. Dual-source detection and identification system based on UAV radio frequency signal[J]. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 2006215. doi: 10.1109/TIM.2021.3103565. [17] EZUMA M, ERDEN F, ANJINAPPA C K, et al. Detection and classification of UAVs using RF fingerprints in the presence of Wi-Fi and Bluetooth interference[J]. IEEE Open Journal of the Communications Society, 2020, 1: 60–76. doi: 10.1109/OJCOMS.2019.2955889. [18] FU Hua, ABEYWICKRAMA S, ZHANG Lihao, et al. Low-complexity portable passive drone surveillance via SDR-based signal processing[J]. IEEE Communications Magazine, 2018, 56(4): 112–118. doi: 10.1109/MCOM.2018.1700424. [19] ALSOLIMAN A, RIGONI G, LEVORATO M, et al. COTS drone detection using video streaming characteristics[C]. Proceedings of the 22nd International Conference on Distributed Computing and Networking, Nara, Japan, 2021: 166–175. [20] ALIPOUR-FANID A, DABAGHCHIAN M, WANG Ning, et al. Machine learning-based delay-aware UAV detection and operation mode identification over encrypted Wi-Fi traffic[J]. IEEE Transactions on Information Forensics and Security, 2020, 15: 2346–2360. doi: 10.1109/TIFS.2019.2959899. [21] AL-SA’D M F, AL-ALI A, MOHAMED A, et al. RF-based drone detection and identification using deep learning approaches: An initiative towards a large open source drone database[J]. Future Generation Computer Systems, 2019, 100: 86–97. doi: 10.1016/j.future.2019.05.007. [22] BASAK S, RAJENDRAN S, POLLIN S, et al. Combined RF-based drone detection and classification[J]. IEEE Transactions on Cognitive Communications and Networking, 2022, 8(1): 111–120. doi: 10.1109/TCCN.2021.3099114. [23] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 770–778. -

下载:

下载:

下载:

下载: