Coarse-to-fine Inspection for Flexo First Item Based on the Electronic Sample

-

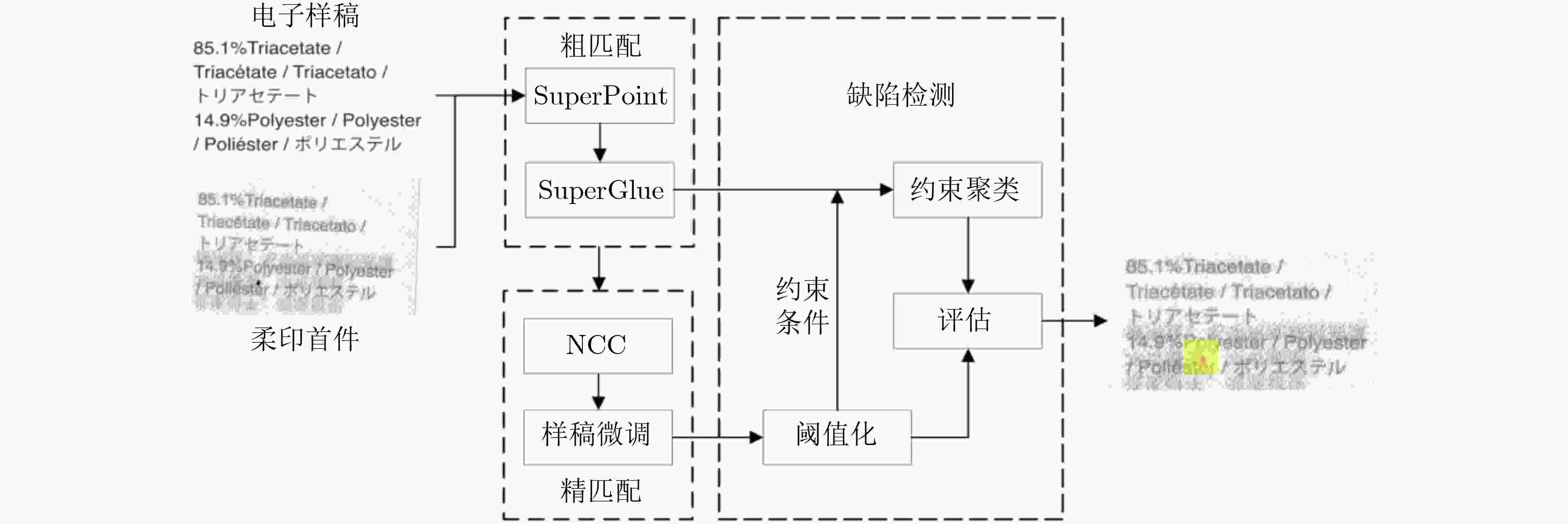

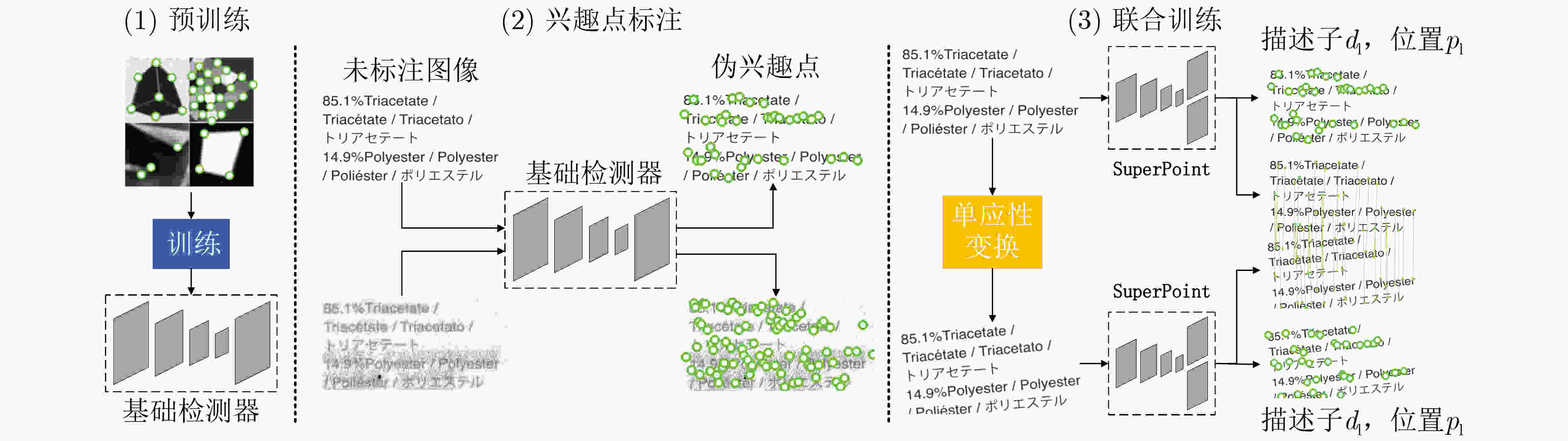

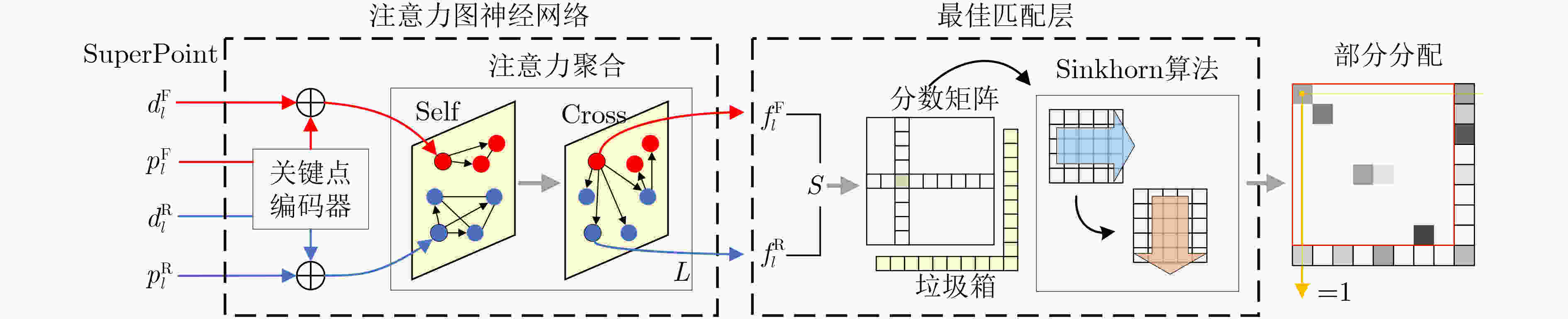

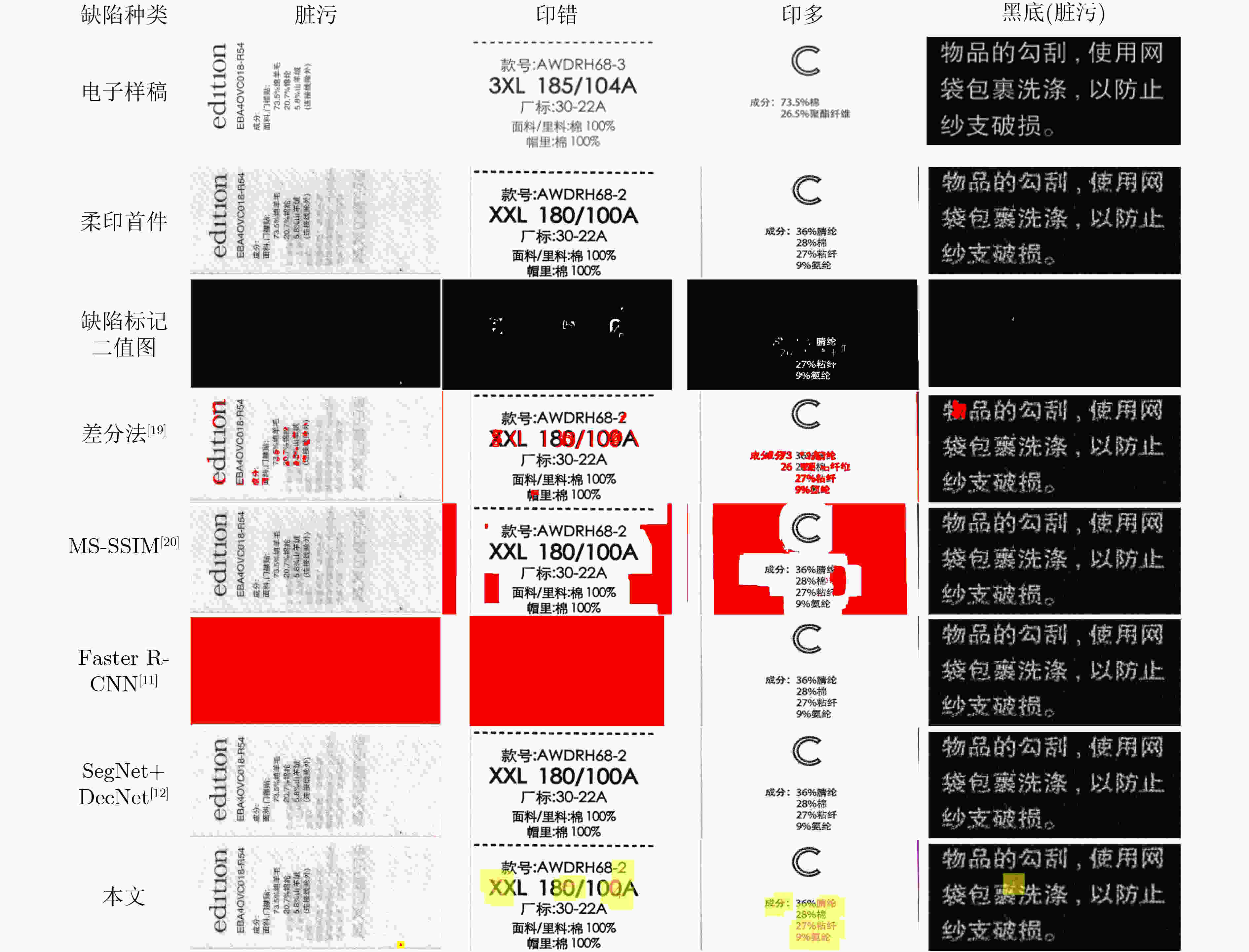

摘要: 为了解决柔印首件检验没有基准织物图像作为参照的难点,该文提出一种以电子样稿为参照物的柔印首件“粗-精”检测方法,主要分为粗匹配、精匹配和缺陷检测3个阶段。首先,针对电子样稿与印刷首件内容粗细不一、灰度特性差异大、柔印内容重复率高等问题,融合超点(SuperPoint)与强力匹配(SuperGlue)方法进行粗匹配。然后,针对柔印过程版材伸缩、弯曲引发柔印内容局部偏移的问题,采用归一化互相关(NCC)法微调样稿字符,实现精匹配。最后,提出约束聚类的方法将缺陷检测问题转化为电子样稿与柔印首件差异最小化的问题。对比实验表明,该文方法的柔印首件检测性能要优于其他织物印刷品缺陷检测方法,其漏检率为0,误检率为1.3%,平均Dice系数为0.941,且检测时间仅为2.761 s/pcs,满足实际工程的需求。Abstract: In order to solve the problem that there is no real reference of the fabric image in the flexo first item inspection, a coarse-to-fine inspection method of flexo first item is proposed based on electronic samples, which is mainly divided into three stages: coarse matching, fine matching and defect detection. First, since different thickness of the characters, large differences in gray characteristics, and high repetition of flexo content inherently exist in the electronic sample and the flexo first item, the SuperGlue with SuperPoint are employed for rough matching. Then, a Normalized Cross-Correlation(NCC)-based method is used to fine-tune the electronic sample characters for fine matching, which can deal with local offsets of flexo content are caused by plate expansion and bending in flexo printing process. Finally, a constrained clustering method is proposed to transform the defect detection problem into the problem of minimizing the difference between electronic sample and flexo first item. Comparison experiments show that the proposed method can achieve better inspection performance for flexo first item, with the missed detection rate of 0, the false detection rate of 1.3%, the average Dice coefficient of 0.941, and the inspection time of 2.761 s/pcs. This promising inspection indicates that the proposed method can be well employed in real industries.

-

表 1 搜索扩展基数δ对检测性能的影响

10 15 20 25 30 35 40 45 50 误检率(%) 1.9 0.9 0.6 0.4 1.3 0.5 0.8 0.8 1.1 漏检率(%) 2.9 1.1 2.0 2.0 0 1.0 1.8 2.0 2.4 Dice系数 0.879 0.910 0.930 0.936 0.941 0.913 0.882 0.879 0.877 处理时间(s/pcs) 2.281 2.356 2.427 2.452 2.761 2.932 3.231 3.341 3.413 表 2 评估阈值参数Td对缺陷检测结果的影响

0.5 1.0 1.5 2.0 2.5 3.0 3.5 4.0 4.5 误检率(%) 42.6 1.3 0.3 0.1 0.1 0.1 0.05 0.02 0.02 漏检率(%) 0 0 5.7 30.4 32.6 40.1 44.6 48.2 49.1 Dice系数 0.548 0.941 0.943 0.941 0.938 0.917 0.912 0.910 0.906 处理时间(s/pcs) 2.643 2.761 2.801 2.842 2.803 2785 2.792 2.853 2.942 表 3 消融实验

方法 误检率(%) 漏检率(%) Dice系数 检测时间(s/pcs) 粗匹配 63.4 28.1 0.192 2.342 +精匹配 16.8 5.5 0.328 2.743 +精匹配+约束聚类 1.3 0 0.941 2.761 -

[1] 李少波, 杨静, 王铮, 等. 缺陷检测技术的发展与应用研究综述[J]. 自动化学报, 2020, 46(11): 2319–2336. doi: 10.16383/j.aas.c180538LI Shaobo, YANG Jing, WANG Zheng, et al. Review of development and application of defect detection technology[J]. Acta Automatica Sinica, 2020, 46(11): 2319–2336. doi: 10.16383/j.aas.c180538 [2] RASHEED A, ZAFAR B, RASHEED A, et al. Fabric defect detection using computer vision techniques: A comprehensive review[J]. Mathematical Problems in Engineering, 2020, 2020: 8189403. doi: 10.1155/2020/8189403 [3] QAYUM M A and NASEER M. A fast approach for finding design repeat in textile rotary printing for fault detection[J]. The Journal of the Textile Institute, 2017, 108(1): 62–65. doi: 10.1080/00405000.2015.1135579 [4] ALAM S M J, HU Guoqing, and ROY S. Analysis of a printed complex image quality checking method of fabric cloth for development of an automated quality checking system[J]. Signal, Image and Video Processing, 2021, 15(1): 195–203. doi: 10.1007/s11760-020-01737-w [5] JING Junfeng and REN Huanhuan. Defect detection of printed fabric based on RGBAAM and image pyramid[J]. Autex Research Journal, 2021, 21(2): 135–141. doi: 10.2478/aut-2020-0007 [6] NG M K, NGAN H Y T, YUAN Xiaoming, et al. Patterned fabric inspection and visualization by the method of image decomposition[J]. IEEE Transactions on Automation Science and Engineering, 2014, 11(3): 943–947. doi: 10.1109/TASE.2014.2314240 [7] KANG Xuejuan, YANG Panpan, and JING Junfeng. Defect detection on printed fabrics via Gabor filter and regular band[J]. Journal of Fiber Bioengineering & Informatics, 2015, 8(1): 195–206. doi: 10.3993/jfbi03201519 [8] 李敏, 崔树芹, 谢治平. 高斯混合模型在印花织物疵点检测中的应用[J]. 纺织学报, 2015, 36(8): 94–98. doi: 10.13475/j.fzxb.20140504105LI Min, CUI Shuqin, and XIE Zhiping. Application of Gaussian mixture model on defect detection of print fabric[J]. Journal of Textile Research, 2015, 36(8): 94–98. doi: 10.13475/j.fzxb.20140504105 [9] HU Xudong, FU Mingyue, ZHU Zhijuan, et al. Unsupervised defect detection algorithm for printed fabrics using content-based image retrieval techniques[J]. Textile Research Journal, 2021, 91(21/22): 2551–2566. doi: 10.1177/00405175211008614 [10] CHAKRABORTY S, MOORE M, and PARRILLO-CHAPMAN L. Automatic defect detection of print fabric using convolutional neural network[J]. arXiv preprint arXiv: 2101.00703, 2021. [11] ZHAO Zhiyong, GUI Kang, and WANG Peimao. Fabric defect detection based on cascade faster R-CNN[C]. The 4th International Conference on Computer Science and Application Engineering, Sanya, China, 2020: 98. [12] HUANG Yanqing, JING Junfeng, and WANG Zhen. Fabric defect segmentation method based on deep learning[J]. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 5005715. doi: 10.1109/TIM.2020.3047190 [13] DETONE D, MALISIEWICZ T, and RABINOVICH A. SuperPoint: Self-supervised interest point detection and description[C]. The IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, Salt Lake City, USA, 2018: 224–236. [14] SARLIN P E, DETONE D, MALISIEWICZ T, et al. SuperGlue: Learning feature matching with graph neural networks[C]. The IEEE/CVF Conference on Computer Vision and Pattern Recognition, Seattle, USA, 2020: 4937–4946. [15] SATOH S. Simple low-dimensional features approximating NCC-based image matching[J]. Pattern Recognition Letters, 2011, 32(14): 1902–1911. doi: 10.1016/j.patrec.2011.07.027 [16] BALNTAS V, LENC K, VEDALDI A, et al. HPatches: A benchmark and evaluation of handcrafted and learned local descriptors[C]. The IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 3852–3861. [17] SIMONYAN K and ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[C]. 3rd International Conference on Learning Representations, San Diego, USA, 2015. [18] LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: Common objects in context[C]. 13th European Conference on Computer Vision, Zurich, Switzerland, 2014: 740–755. [19] CUTURI M. Sinkhorn distances: Lightspeed computation of optimal transport[C]. The 26th International Conference on Neural Information Processing Systems, Lake Tahoe, USA, 2013: 2292–2300. [20] 王勇臻, 陈燕, 于莹莹. 求解多旅行商问题的改进分组遗传算法[J]. 电子与信息学报, 2017, 39(1): 198–205. doi: 10.11999/JEIT160211WANG Yongzhen, CHEN Yan, and YU Yingying. Improved grouping genetic algorithm for solving multiple traveling salesman problem[J]. Journal of Electronics &Information Technology, 2017, 39(1): 198–205. doi: 10.11999/JEIT160211 [21] WANG Yangping, XU Shaowei, ZHU Zhengping, et al. Real-time defect detection method for printed images based on grayscale and gradient differences[J]. Journal of Engineering Science and Technology Review, 2018, 11(1): 180–188. doi: 10.25103/jestr.111.22 [22] TOLBA A S and RAAFAT H M. Multiscale image quality measures for defect detection in thin films[J]. The International Journal of Advanced Manufacturing Technology, 2015,, 79(1/4): 113–122. doi: 10.1007/s00170-014-6758-7 -

下载:

下载:

下载:

下载: