Personalized Commodity Recommendation Method Based on Behavioral Delay Sharing Network

-

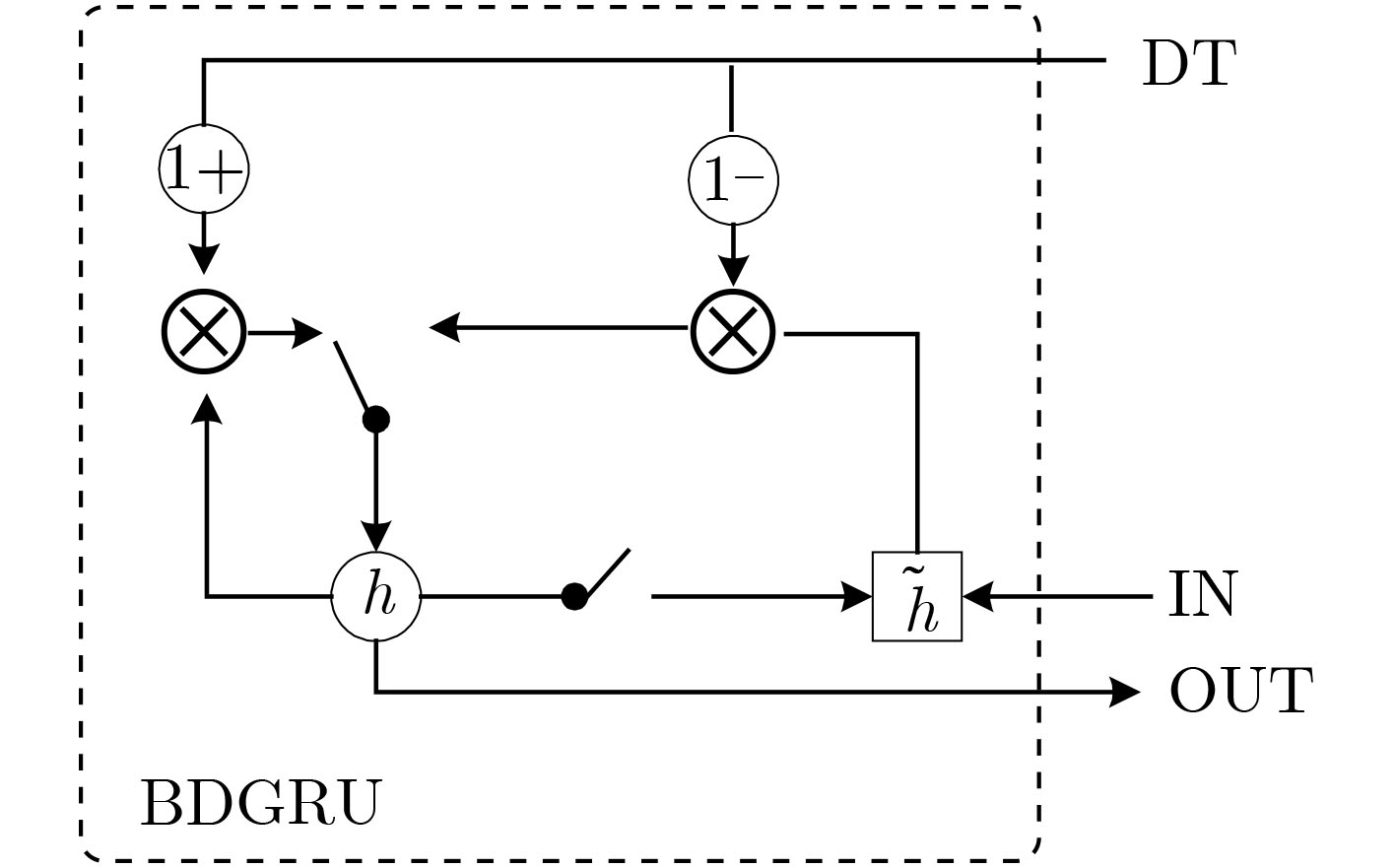

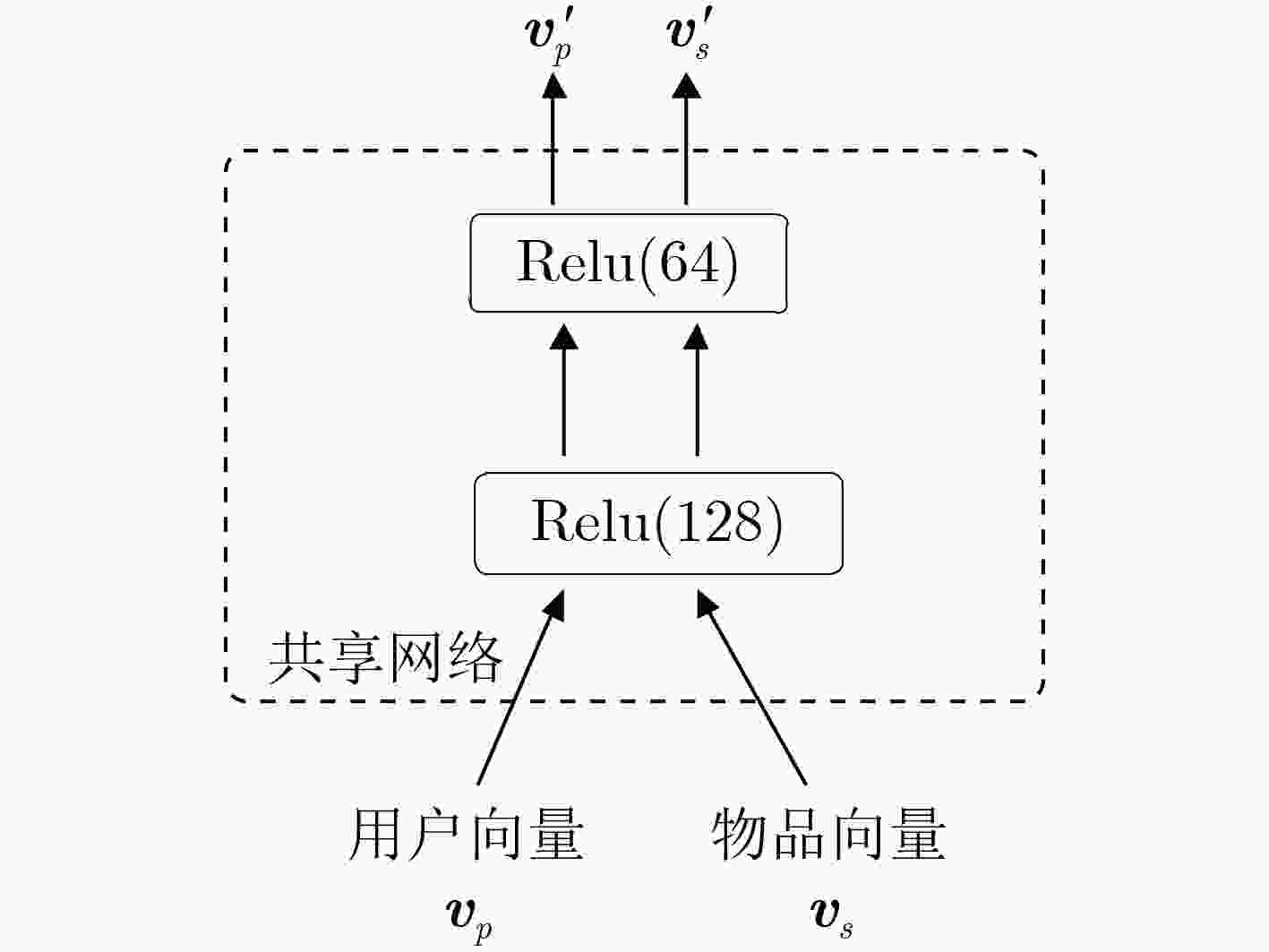

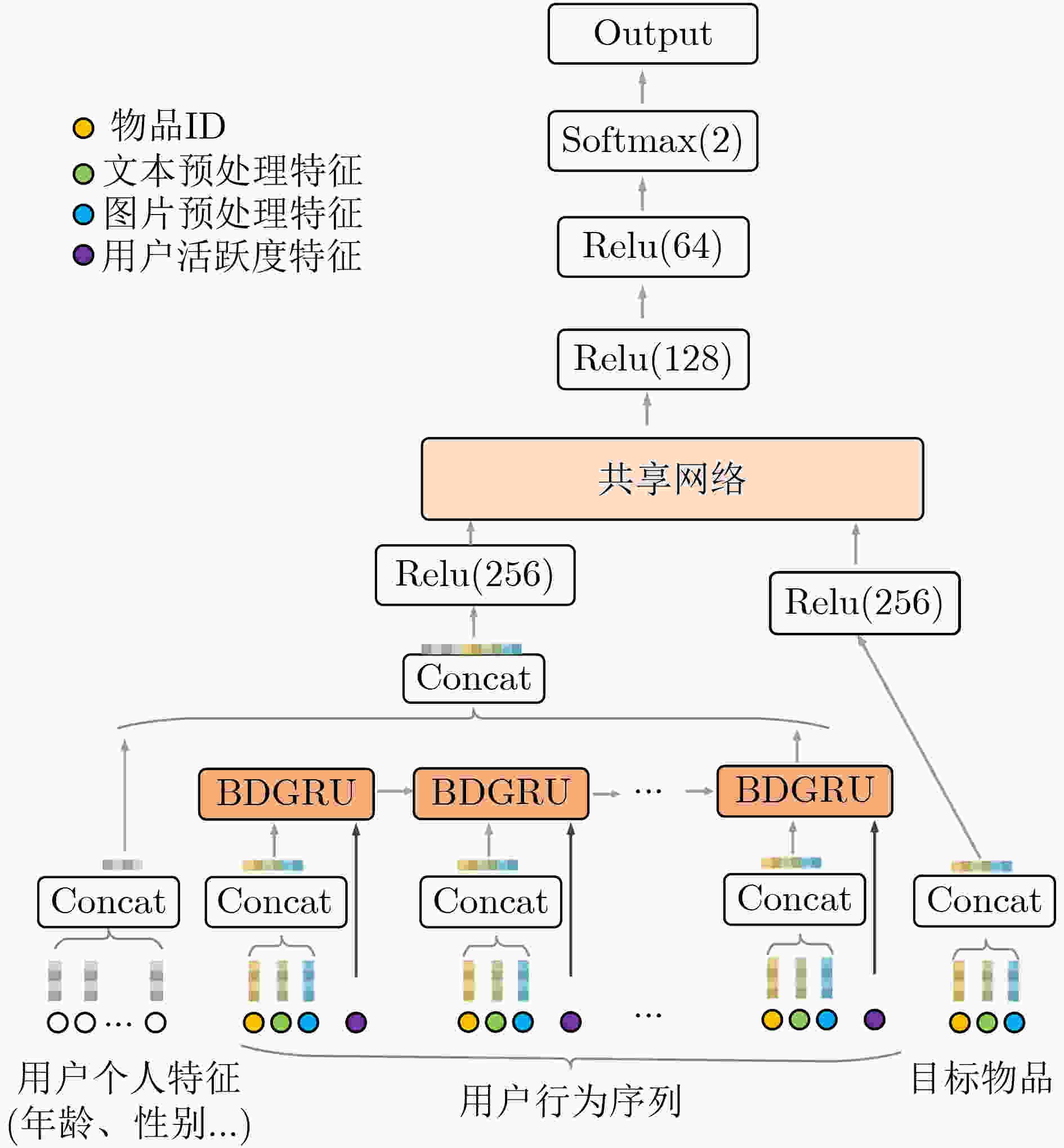

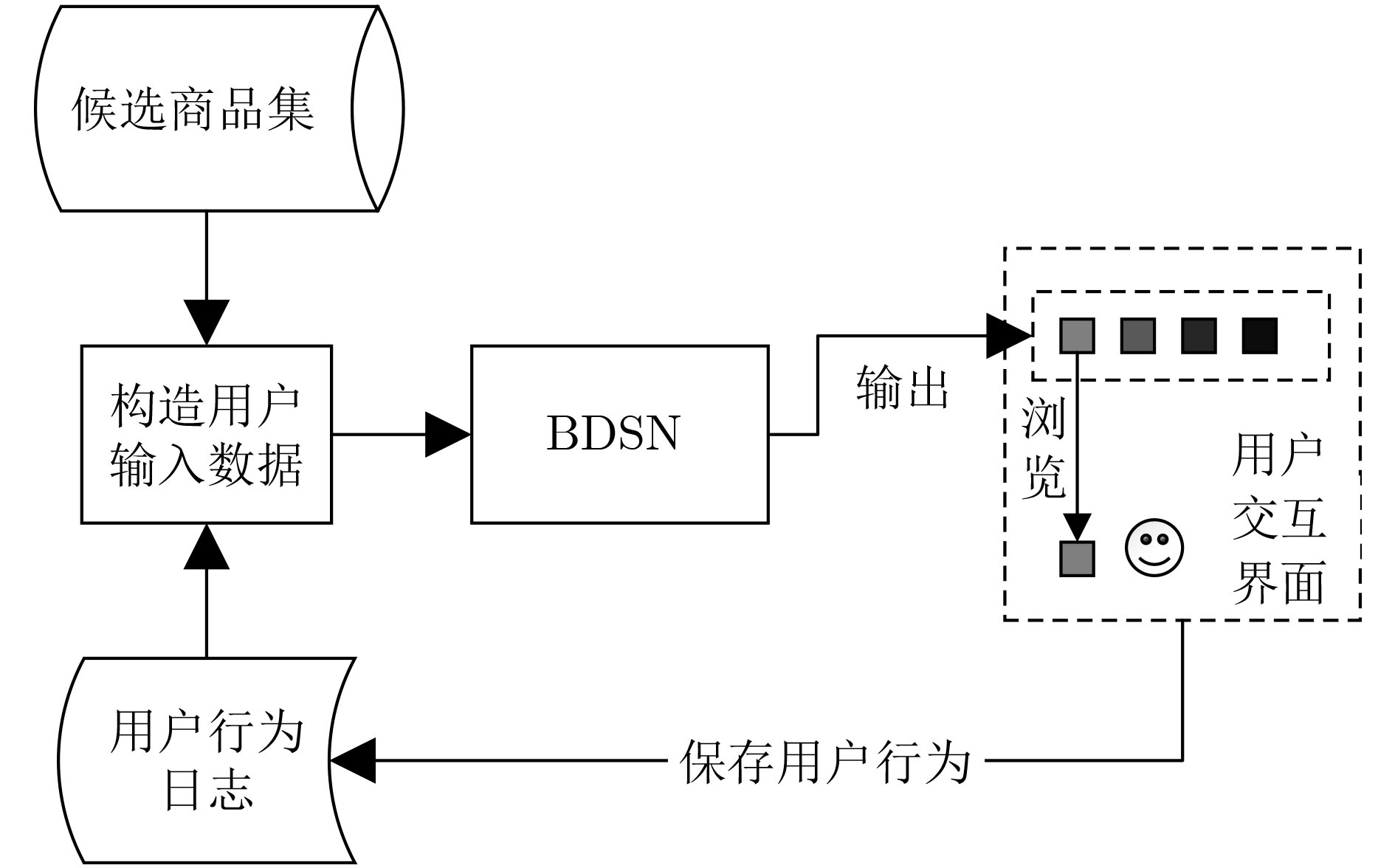

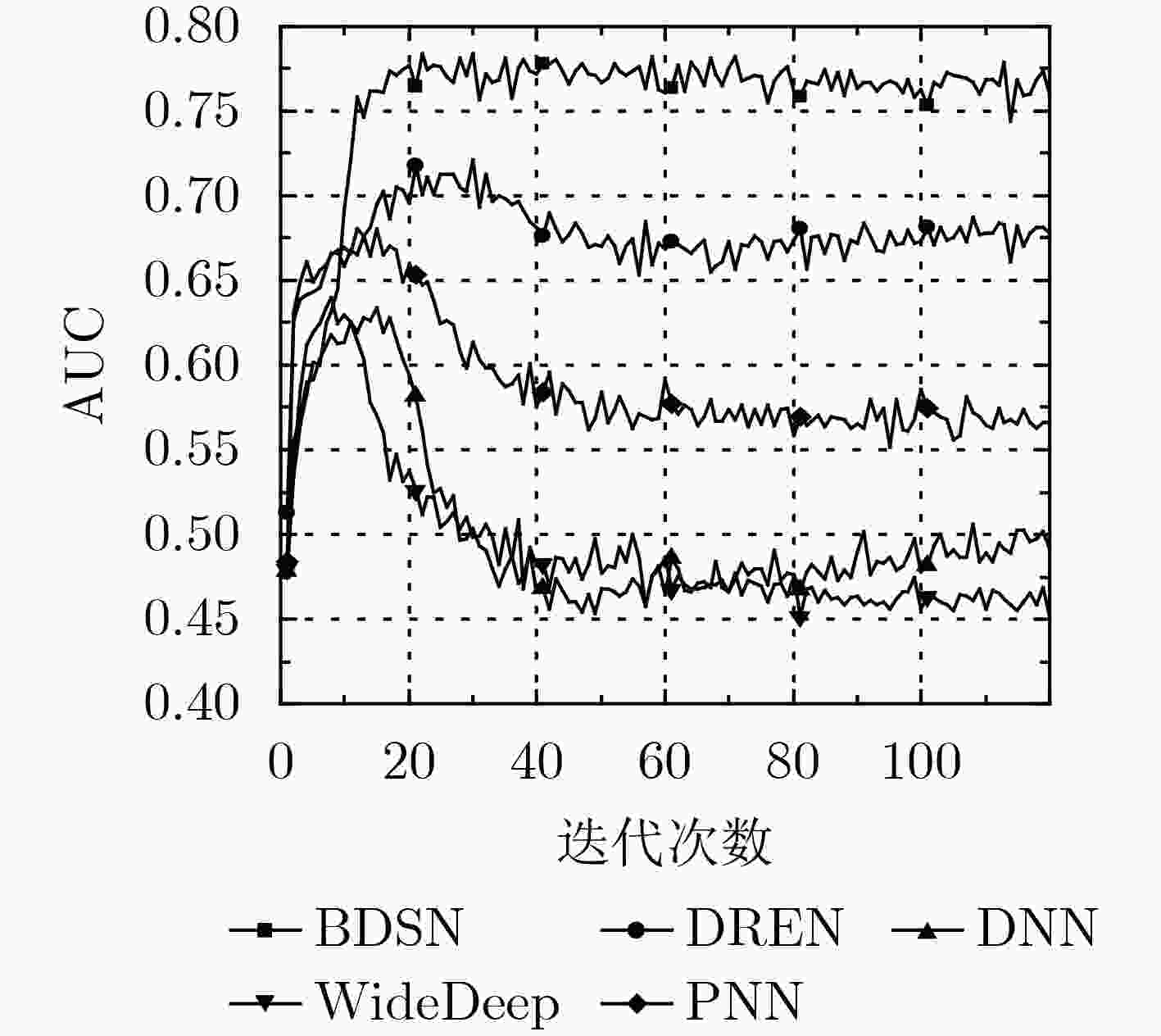

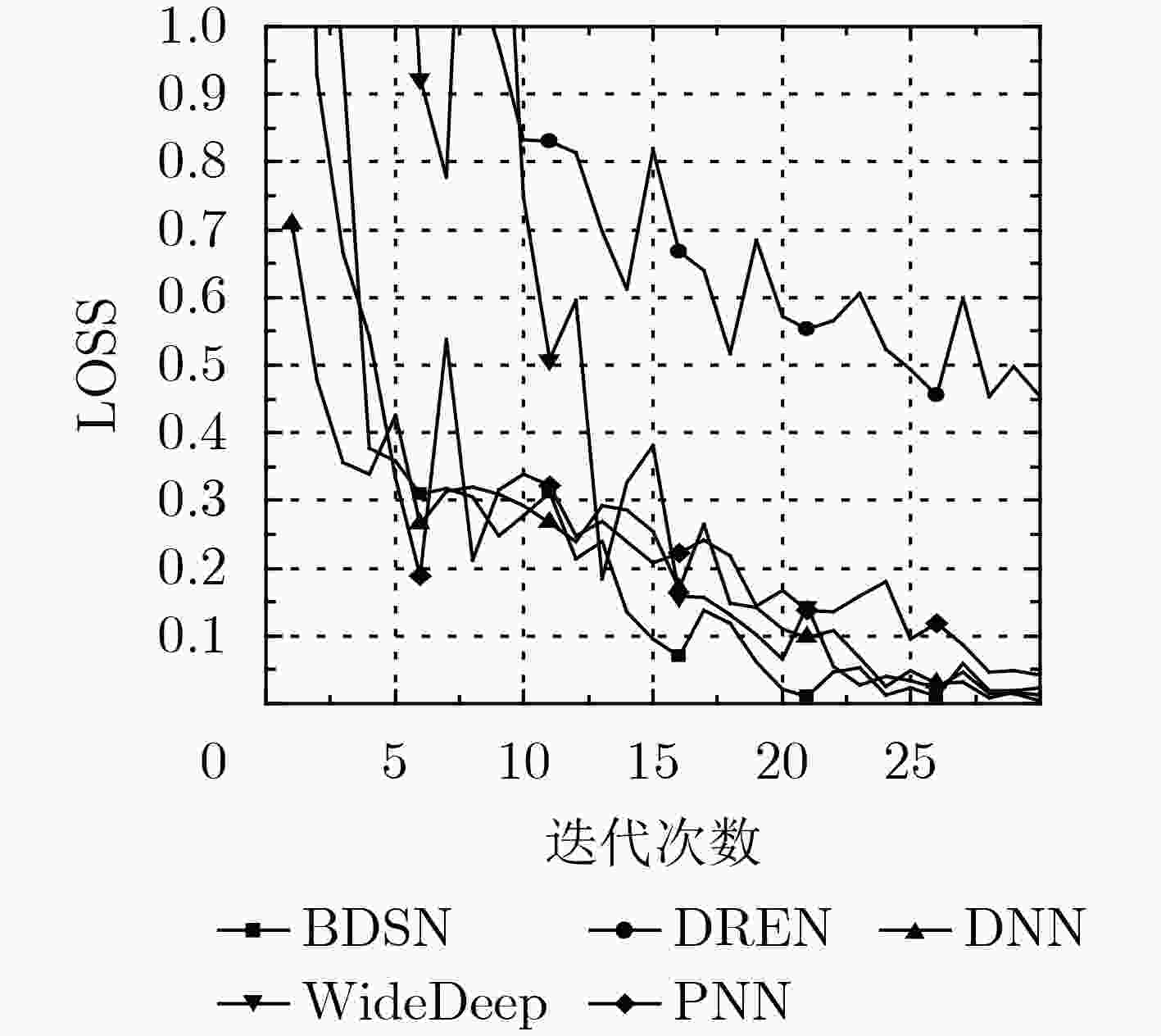

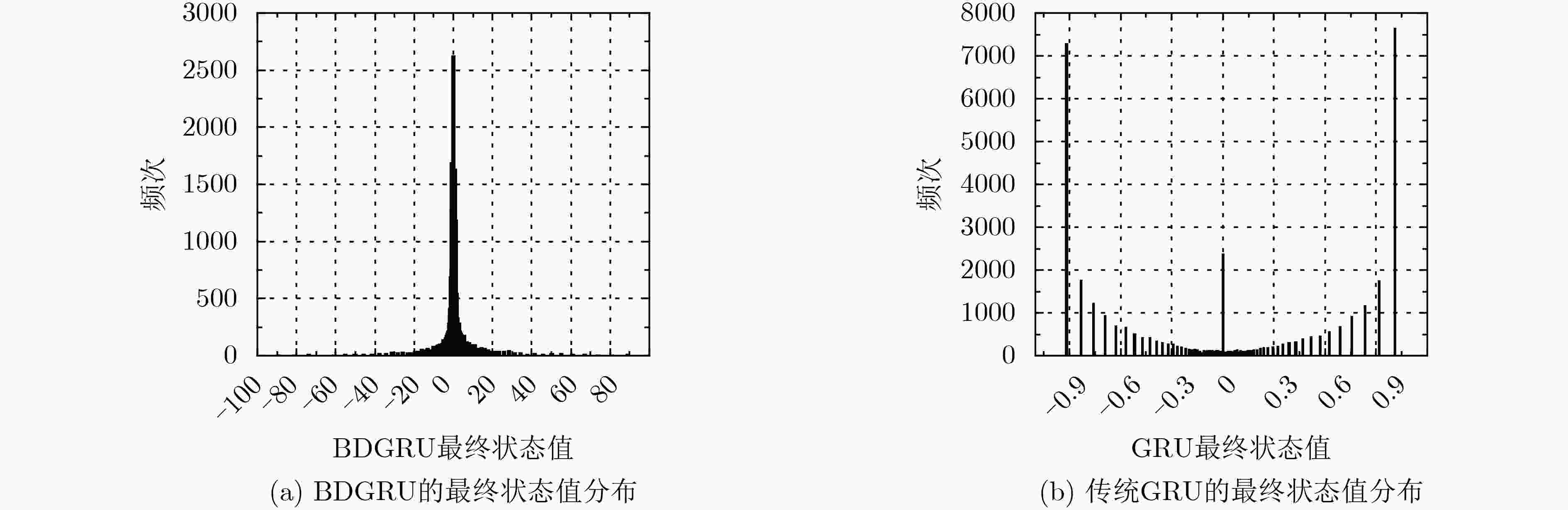

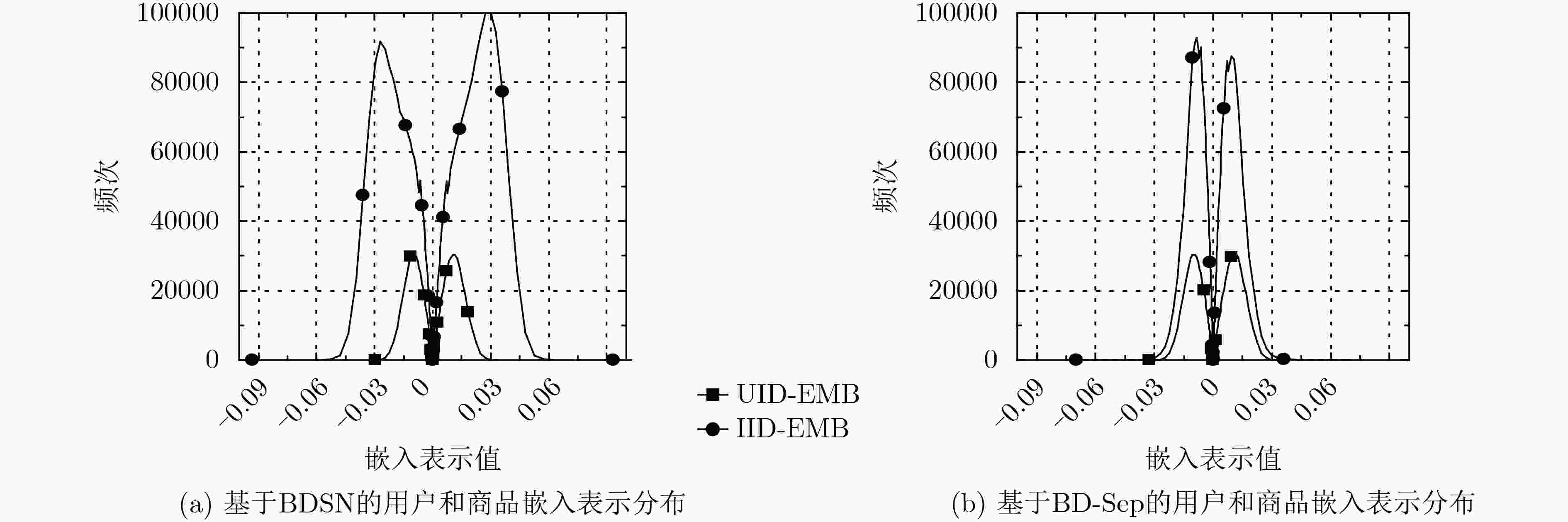

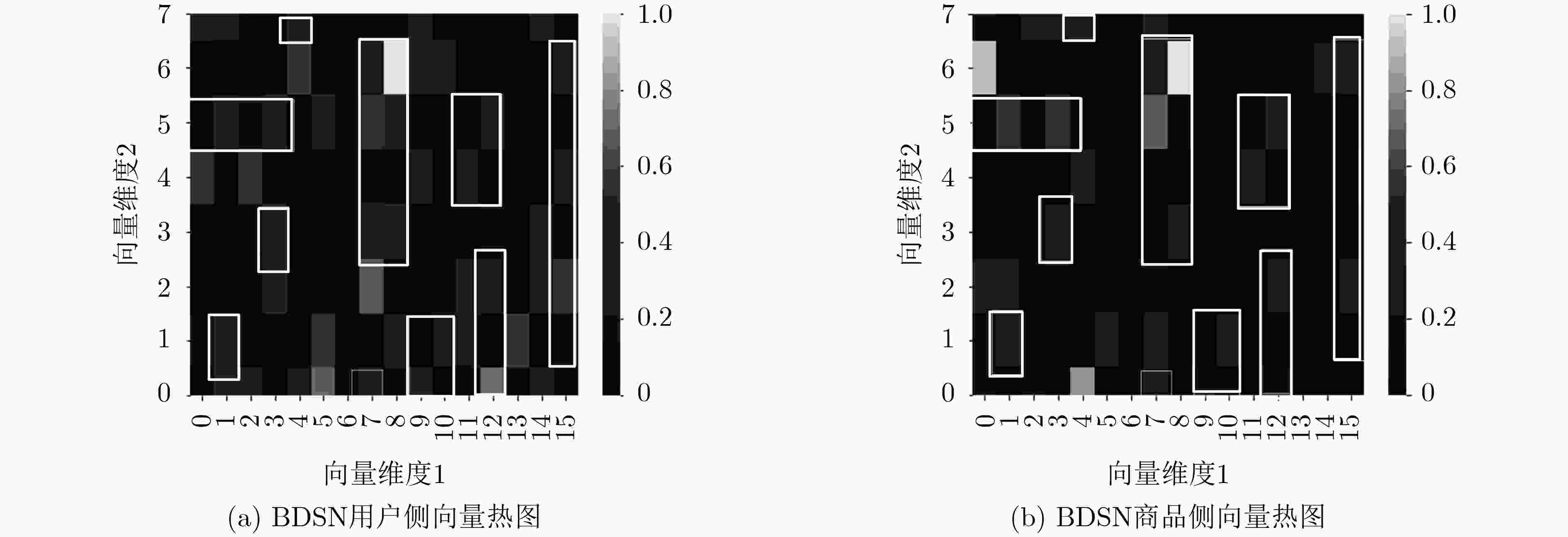

摘要: 针对电商平台难以利用历史浏览行为进行个性化商品推荐的问题,该文提出了一种行为延迟共享网络模型(BDSN),充分结合历史浏览信息,对用户进行精准浏览推荐。该模型提出行为延迟门控循环神经单元(BDGRU),将历史浏览时间间隔作为用户活跃度因子,对神经元状态进行更新,用于计算用户的兴趣表示。为了提高向量表示的一致性,该模型提出共享参数网络,将用户侧和商品侧的表示向量收敛到统一空间,解决个性化商品推荐点击率预估问题。并在真实数据集上进行实验,结果表明,BDSN模型在验证集上的AUC指标和损失函数均处于最优,在测试集上的AUC指标相较基本模型提高37%,能够有效提升商品推荐的准确性。Abstract: This paper proposes a Behavior Delayed Sharing Network (BDSN) model to solve the personalized product recommendation problem based on personal historical browsing behaviors. First, a Behavior Delay Gated Recurrent Neural Unit (BDGRU) is presented, which uses the historical browsing time interval as a user activity factor, and updates the neuron state to calculate the user's interest expression. Then, a shared parameter network is proposed to converge the representation vectors on the user side and the goods side into a unified space. Experiments show that the AUC index and loss function of BDSN model on the validation set are both optimal, and the AUC index on the test set increases by 37% compared with the basic model.

-

表 1 实验数据集统计信息

数据集 用户数量 商品数量 样本数 训练集 6789 108916 2435690 验证集 1664 13280 22450 测试集 1664 15670 21216 表 2 不同方法模型在测试集上的AUC值

模型 AUC RelaImpr(%) BDSN 0.8738 37 DREN 0.8454 27 DNN(BaseModel) 0.7712 0 WideDeep 0.8382 24 PNN 0.8404 25 GRUSN 0.8258 20 BD-Sep 0.8064 12 -

[1] 岳金果. 考虑消费者感知与网络效应的平台推送决策研究[D]. [硕士论文], 西南财经大学, 2019. doi: 10.27412/d.cnki.gxncu.2019.001880.YUE Jinguo. Research on platform recommendation under consumer perception and network effect[D]. [Master dissertation], Southwestern University of Finance and Economics, 2019. doi: 10.27412/d.cnki.gxncu.2019.001880. [2] JANNACH D and JUGOVAC M. Measuring the business value of recommender systems[J]. ACM Transactions on Management Information Systems (TMIS) , 2019, 10(4): 16. doi: 10.1145/3370082 [3] 吕刚, 张伟. 基于深度学习的推荐系统应用综述[J]. 软件工程, 2020, 23(2): 5–8. doi: 10.19644/j.cnki.issn2096-1472.2020.02.002LV Gang and ZHANG Wei. Survey of deep learning applied in recommendation system[J]. Software Engineering, 2020, 23(2): 5–8. doi: 10.19644/j.cnki.issn2096-1472.2020.02.002 [4] NABIZADEH A H, LEAL J P, RAFSANJANI H N, et al. Learning path personalization and recommendation methods: A survey of the state-of-the-art[J]. Expert Systems with Applications, 2020, 159: 113596. doi: 10.1016/j.eswa.2020.113596 [5] HYUN D, PARK C, CHO J, et al. Learning to utilize auxiliary reviews for recommendation[J]. Information Sciences, 2021, 545: 595–607. doi: 10.1016/j.ins.2020.09.025 [6] CHENG H T, KOC L, HARMSEN J, et al. Wide & deep learning for recommender systems[C]. The 1st Workshop on Deep Learning for Recommender Systems, Boston, USA, 2016: 7–10. doi: 10.1145/2988450.2988454. [7] COVINGTON P, ADAMS J, and SARGIN E. Deep neural networks for YouTube recommendations[C]. The 10th ACM Conference on Recommender Systems, Boston, USA, 2016: 191–198. doi: 10.1145/2959100.2959190. [8] ZHANG Jiang, WANG Yufeng, YUAN Zhiyuan, et al. Personalized real-time movie recommendation system: Practical prototype and evaluation[J]. Tsinghua Science and Technology, 2020, 25(2): 180–191. doi: 10.26599/TST.2018.9010118 [9] QU Yanru, FANG Bohui, ZHANG Weinan, et al. Product-based neural networks for user response prediction over multi-field categorical data[J]. ACM Transactions on Information Systems (TOIS) , 2019, 37(1): 5. doi: 10.1145/3233770 [10] 王娜, 何晓明, 刘志强, 等. 一种基于用户播放行为序列的个性化视频推荐策略[J]. 计算机学报, 2020, 43(1): 123–135. doi: 10.11897/SP.J.1016.2020.00123WANG Na, HE Xiaoming, LIU Zhiqiang, et al. Personalized video recommendation strategy based on user's playback behavior sequence[J]. Chinese Journal of Computers, 2020, 43(1): 123–135. doi: 10.11897/SP.J.1016.2020.00123 [11] 夏永生, 王晓蕊, 白鹏, 等. 基于时序和距离的门控循环单元兴趣点推荐算法[J]. 计算机工程, 2020, 46(1): 52–59. doi: 10.19678/j.issn.1000-3428.0053659XIA Yongsheng, WANG Xiaorui, BAI Peng, et al. Point of interest recommendation algorithm of gated recurrent unit based on time series and distance[J]. Computer Engineering, 2020, 46(1): 52–59. doi: 10.19678/j.issn.1000-3428.0053659 [12] 李宇琦, 陈维政, 闫宏飞, 等. 基于网络表示学习的个性化商品推荐[J]. 计算机学报, 2019, 42(8): 1767–1778. doi: 10.11897/SP.J.1016.2019.01767LI Yuqi, CHEN Weizheng, YAN Hongfei, et al. Learning graph-based embedding for personalized product recommendation[J]. Chinese Journal of Computers, 2019, 42(8): 1767–1778. doi: 10.11897/SP.J.1016.2019.01767 [13] DHELIM S, AUNG N, and NING Huansheng. Mining user interest based on personality-aware hybrid filtering in social networks[J]. Knowledge-Based Systems, 2020, 206: 106227. doi: 10.1016/j.knosys.2020.106227 [14] ZHOU Guorui, ZHU Xiaoqiang, SONG Chenru, et al. Deep interest network for click-through rate prediction[C]. The 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining, London, UK, 2018: 1059–1068. doi: 10.1145/3219819.3219823. [15] ZHOU Guorui, MOU Na, FAN Ying, et al. Deep interest evolution network for click-through rate prediction[C]. The AAAI Conference on Artificial Intelligence, Honolulu, USA, 2019: 5941–5948. doi: 10.1609/aaai.v33i01.33015941. [16] ZHENG Guanjie, ZHANG Fuzheng, ZHENG Zihan, et al. DRN: A deep reinforcement learning framework for news recommendation[C]. Proceedings of the 2018 World Wide Web Conference, Lyon, France, 2018. doi: 10.1145/3178876.3185994. [17] 曲朝阳, 宋晨晨, 任有学, 等. 结合用户活跃度的协同过滤推荐算法[J]. 东北电力大学学报, 2017, 37(5): 74–79. doi: 10.19718/j.issn.1005-2992.2017.05.015QU Zhaoyang, SONG Chenchen, REN Youxue, et al. Recommendations based on collaborative filtering by user activity[J]. Journal of Northeast Electric Power University, 2017, 37(5): 74–79. doi: 10.19718/j.issn.1005-2992.2017.05.015 [18] 王锦坤, 姜元春, 孙见山, 等. 考虑用户活跃度和项目流行度的基于项目最近邻的协同过滤算法[J]. 计算机科学, 2016, 43(12): 158–162. doi: 10.11896/j.issn.1002-137X.2016.12.028WANG Jinkun, JIANG Yuanchun, SUN Jianshan, et al. A collaborative filtering algorithm based on item nearest neighbors considering user activity and item popularity[J]. Computer Science, 2016, 43(12): 158–162. doi: 10.11896/j.issn.1002-137X.2016.12.028 [19] 司亚利, 张付志, 刘文远. 基于签到活跃度和时空概率模型的自适应兴趣点推荐方法[J]. 电子与信息学报, 2020, 42(3): 678–686. doi: 10.11999/JEIT190287SI Yali, ZHANG Fuzhi, and LIU Wenyuan. An adaptive point-of-interest recommendation method based on check-in activity and temporal-spatial probabilistic models[J]. Journal of Electronics &Information Technology, 2020, 42(3): 678–686. doi: 10.11999/JEIT190287 [20] 于帅, 林宣雄, 邱媛媛. 大规模隐式反馈的词向量音乐推荐模型[J]. 计算机系统应用, 2017, 26(11): 28–35. doi: 10.15888/j.cnki.csa.006049YU Shuai, LIN Xuanxiong, and QIU Yuanyuan. Implicit music recommender based on large scale word-embedding[J]. Computer Systems &Applications, 2017, 26(11): 28–35. doi: 10.15888/j.cnki.csa.006049 [21] 赵晨阳, 王俊岭. 基于隐含上下文支持向量机的服务推荐方法[J]. 通信学报, 2019, 40(9): 61–73. doi: 10.11959/j.issn.1000-436x.2019190ZHAO Chenyang and WANG Junling. Service recommendation method based on context-embedded support vector machine[J]. Journal on Communications, 2019, 40(9): 61–73. doi: 10.11959/j.issn.1000-436x.2019190 [22] 潘建林, 汪彬, 董晓晨. 基于SICAS消费者行为模型的社交电商模式及比较研究[J]. 企业经济, 2020, 39(10): 37–43. doi: 10.13529/j.cnki.enterprise.economy.2020.10.005PAN Jianlin, WANG Bin, and DONG Xiaochen. Social e-commerce model and comparative research based on SICAS consumer behavior model[J]. Enterprise Economy, 2020, 39(10): 37–43. doi: 10.13529/j.cnki.enterprise.economy.2020.10.005 [23] 余以胜, 韦锐, 刘鑫艳. 可解释的实时图书信息推荐模型研究[J]. 情报学报, 2019, 38(2): 209–216. doi: 10.3772/j.issn.1000-0135.2019.02.010YU Yisheng, WEI Rui, and LIU Xinyan. Explainable real-time book information recommendation model[J]. Journal of the China Society for Scientific and Technical Information, 2019, 38(2): 209–216. doi: 10.3772/j.issn.1000-0135.2019.02.010 [24] TIANCHI. Inc. KDD Cup 2020 challenges for modern E-commerce platform: Debiasing[EB/OL]. https://tianchi.aliyun.com/specials/promotion/kdd2020-cn, 2020. -

下载:

下载:

下载:

下载: