Object Tracking Based on Cost Sensitive Structured SVM

-

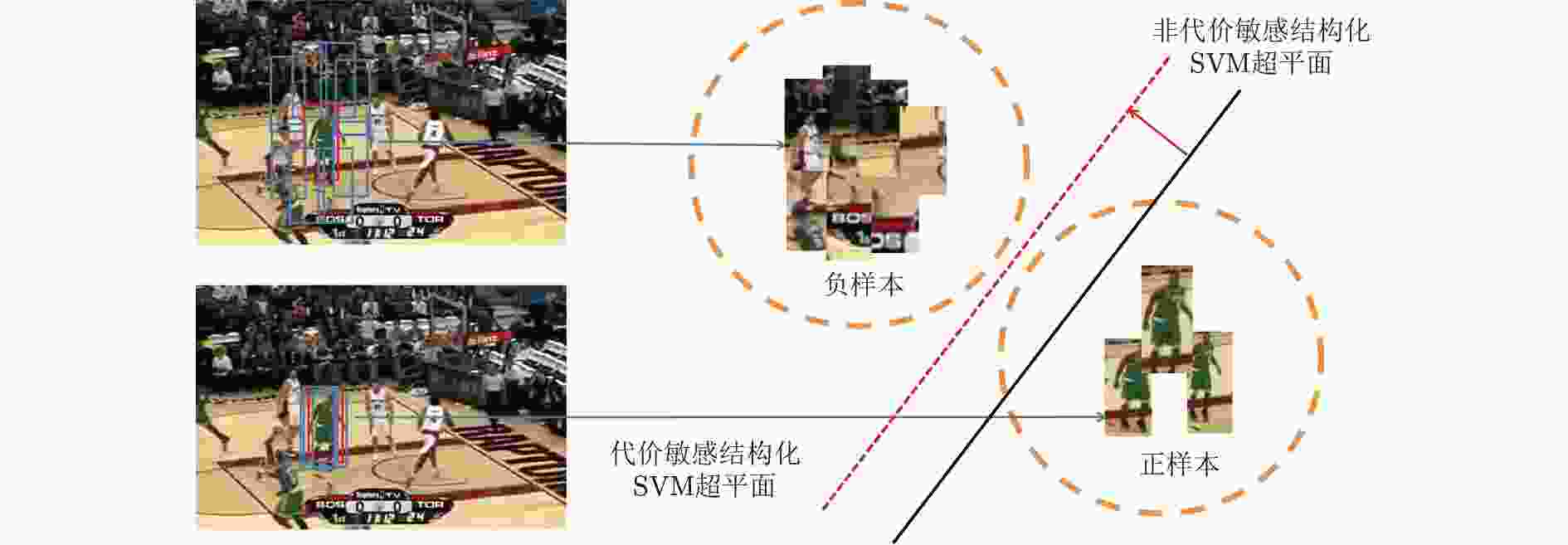

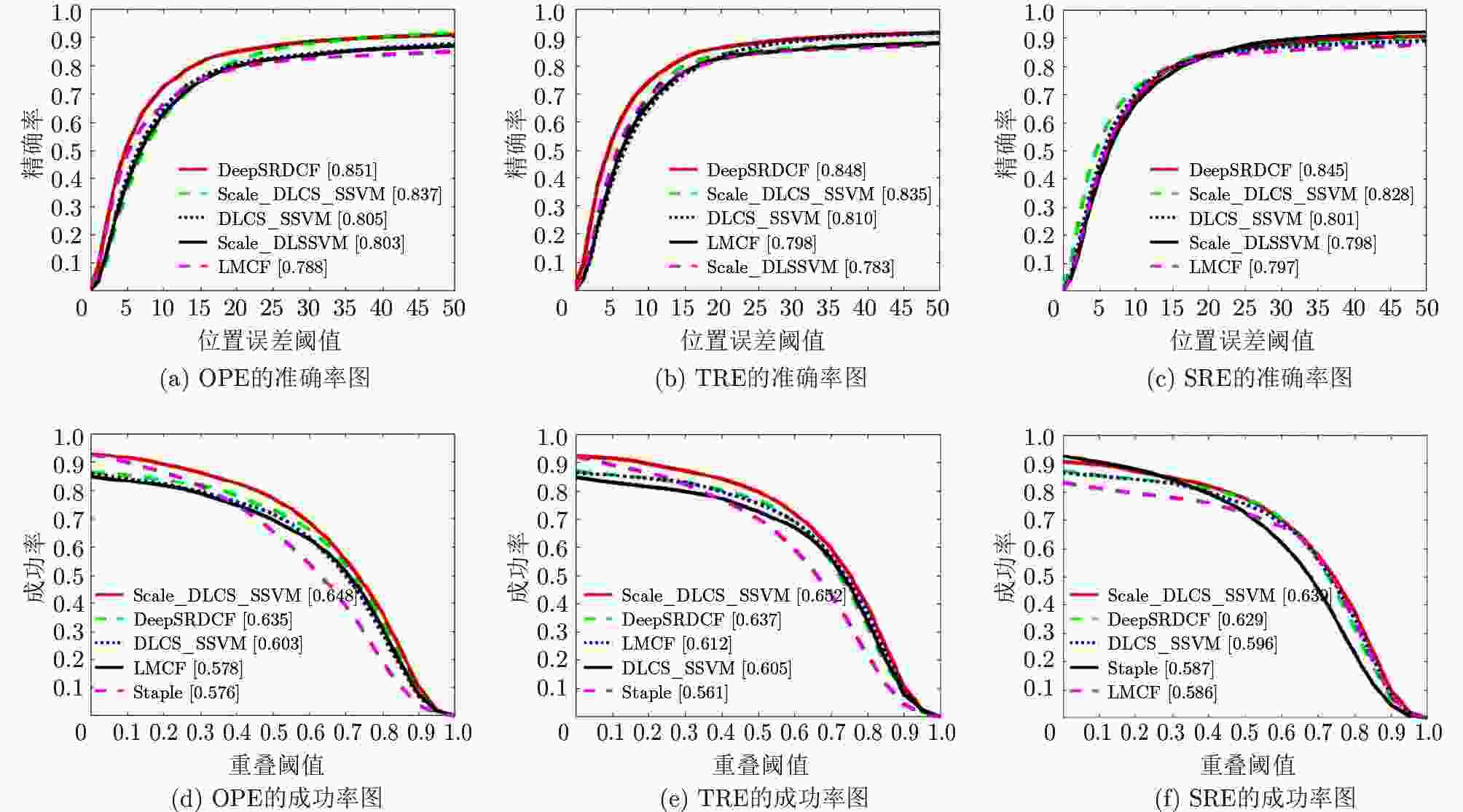

摘要: 基于结构化SVM的目标跟踪由于其优异的性能而受到了广泛关注,但是现有方法存在正样本和负样本不平衡问题。针对此问题,该文首先提出一种用于目标跟踪的代价敏感结构化SVM模型,其次基于对偶坐标下降原理设计了该模型的求解算法,最后利用提出的代价敏感结构化SVM实现了一种多尺度目标跟踪方法。在OTB100数据集和VOT2019数据集上进行了实验验证,实验结果表明:该文方法相比相关滤波目标跟踪方法,跟踪精度较高,相比深度目标跟踪方法,具有速度优势。Abstract: Object tracking based on structured SVM attracts much attention due to its excellent performance. However, the existing methods have the problem of imbalance between positive and negative samples. To solve the problem, a cost sensitive structured SVM model is proposed for object tracking. Secondly, an algorithm for the proposed model is designed via dual coordinate descent principle. Finally, a multi-scale object tracking method is implemented using the proposed cost sensitive structured SVM. The experimental results on OTB100 datasets and VOT2019 datasets show that compared with the correlation filtering trackers, the proposed method has higher tracking accuracy, and has the advantage of speed compared with the deep object trackers.

-

Key words:

- Object tracking /

- Unbalanced problem /

- Cost sensitive /

- Structured SVM

-

表 1 6种基于结构化SVM的跟踪器在OTB100数据集上的OPE性能与速度指标

表 2 5种跟踪方法在OTB100数据集上的速度指标(fps)

-

[1] HARE S, SAFFARI A, and TORR P H S. Struck: Structured output tracking with kernels[C]. 2011 International Conference on Computer Vision, Barcelona, Spain, 2011: 263−270. [2] HARE S, GOLODETZ S, SAFFARI A, et al. Struck: Structured output tracking with kernels[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(10): 2096–2109. doi: 10.1109/TPAMI.2015.2509974 [3] YAO Rui, SHI Qinfeng, SHEN Chunhua, et al. Robust tracking with weighted online structured learning[C]. The 12th European Conference on Computer Vision, Florence, Italy, 2012: 158–172. [4] YAO Rui, SHI Qinfeng, SHEN Chunhua, et al. Part-based visual tracking with online latent structural learning[C]. 2013 IEEE Conference on Computer Vision and Pattern Recognition, Portland, USA, 2013: 2363–2370. [5] BAI Yancheng and TANG Ming. Robust tracking via weakly supervised ranking SVM[C]. 2012 IEEE Conference on Computer Vision and Pattern Recognition, Providence, USA, 2012: 1854–1861. [6] ZHANG Jianming, MA Shugao, and SCLAROFF S. MEEM: Robust tracking via multiple experts using entropy minimization[C]. The 13th European Conference on Computer Vision, Zurich, Swiss, 2014: 188–203. [7] HONG S, YOU T, KWAK S, et al. Online tracking by learning discriminative saliency map with convolutional neural network[C]. The 32nd International Conference on International Conference on Machine Learnin, Lille, France, 2015: 597–606. [8] NING Jifeng, YANG Jimei, JIANG Shaojie, et al. Object tracking via dual linear structured SVM and explicit feature map[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 4266–4274. [9] WANG Mengmeng, LIU Yong, and HUANG Zeyi. Large margin object tracking with circulant feature maps[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 4800–4808. [10] JI Zhangjian, FENG Kai, and QIAN Yuhua. Part-based visual tracking via structural support correlation filter[J]. Journal of Visual Communication and Image Representation, 2019, 64: 102602. doi: 10.1016/j.jvcir.2019.102602 [11] ZUO Wangmeng, WU Xiaohe, LIN Liang, et al. Learning support correlation filters for visual tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(5): 1158–1172. doi: 10.1109/TPAMI.2018.2829180 [12] ZABIH R and WOODFILL J. Non-parametric local transforms for computing visual correspondence[C]. The Third European Conference on Computer Vision, Stockholm, Sweden, 1994: 151–158. [13] WU Yi, LIM J, and YANG M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834–1848. doi: 10.1109/TPAMI.2014.2388226 [14] KRISTAN M, BERG J, LEONARDIS A, et al. The seventh visual object tracking VOT2019 challenge results[C]. 2019 IEEE/CVF International Conference on Computer Vision Workshop, Seoul, South Korea, 2019: 2206–2241. [15] IRANMEHR A, MASNADI-SHIRAZI H, and VASCONCELOS N. Cost-sensitive support vector machines[J]. Neurocomputing, 2019, 343: 50–64. doi: 10.1016/j.neucom.2018.11.099 [16] RAMANAN D. Dual coordinate solvers for large-scale structural SVMs[J]. arXiv: 1312.1743v2, 2014. [17] DANELLJAN M, HÄGER G, KHAN F S, et al. Convolutional features for correlation filter based visual tracking[C]. 2015 IEEE International Conference on Computer Vision Workshop, Santiago, Chile, 2015: 621–629. [18] WANG Qiang, ZHANG Li, BERTINETTO L, et al. Fast online object tracking and segmentation: A unifying approach[C]. 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach, USA, 2019: 1328–1338. [19] LI Peixia, CHEN Boyu, OUYANG Wanli, et al. GradNet: Gradient-guided network for visual object tracking[C]. 2019 IEEE/CVF International Conference on Computer Vision, Seoul, South Korea, 2019: 6161–6170. [20] LI Xin, MA Chao, WU Baoyuan, et al. Target-aware deep tracking[C]. 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach, USA, 2019: 1369–1378. [21] BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple: Complementary learners for real-time tracking[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 1401–1409. -

下载:

下载:

下载:

下载: