Universal Localization Algorithm Based on Beetle Antennae Search in Indoor Environment

-

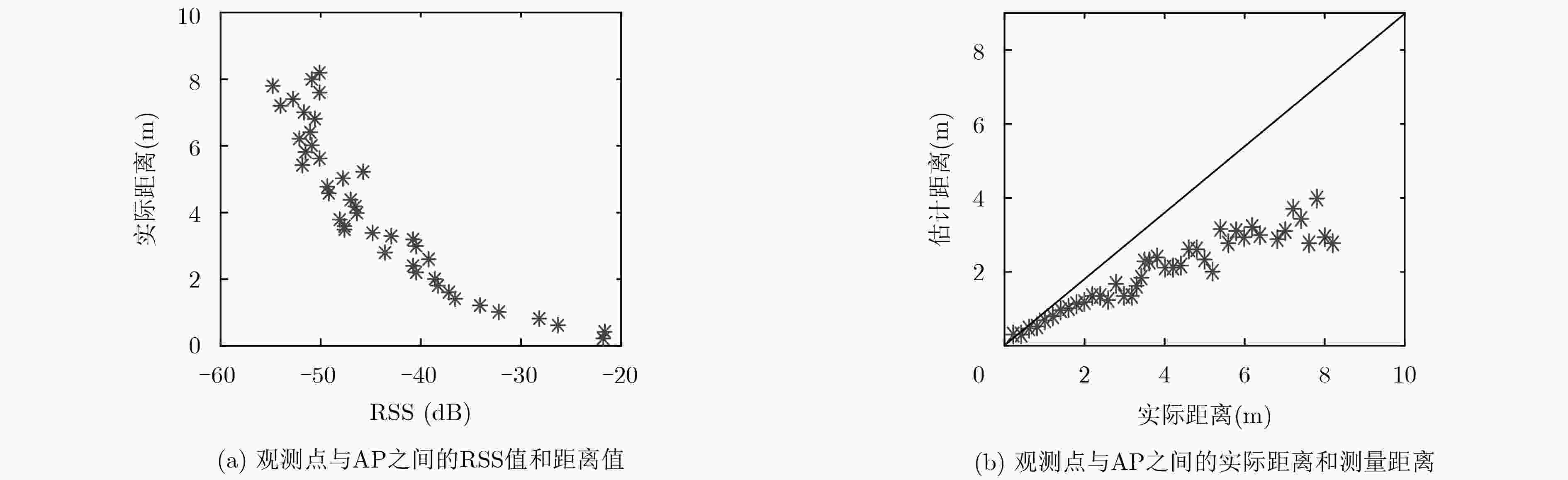

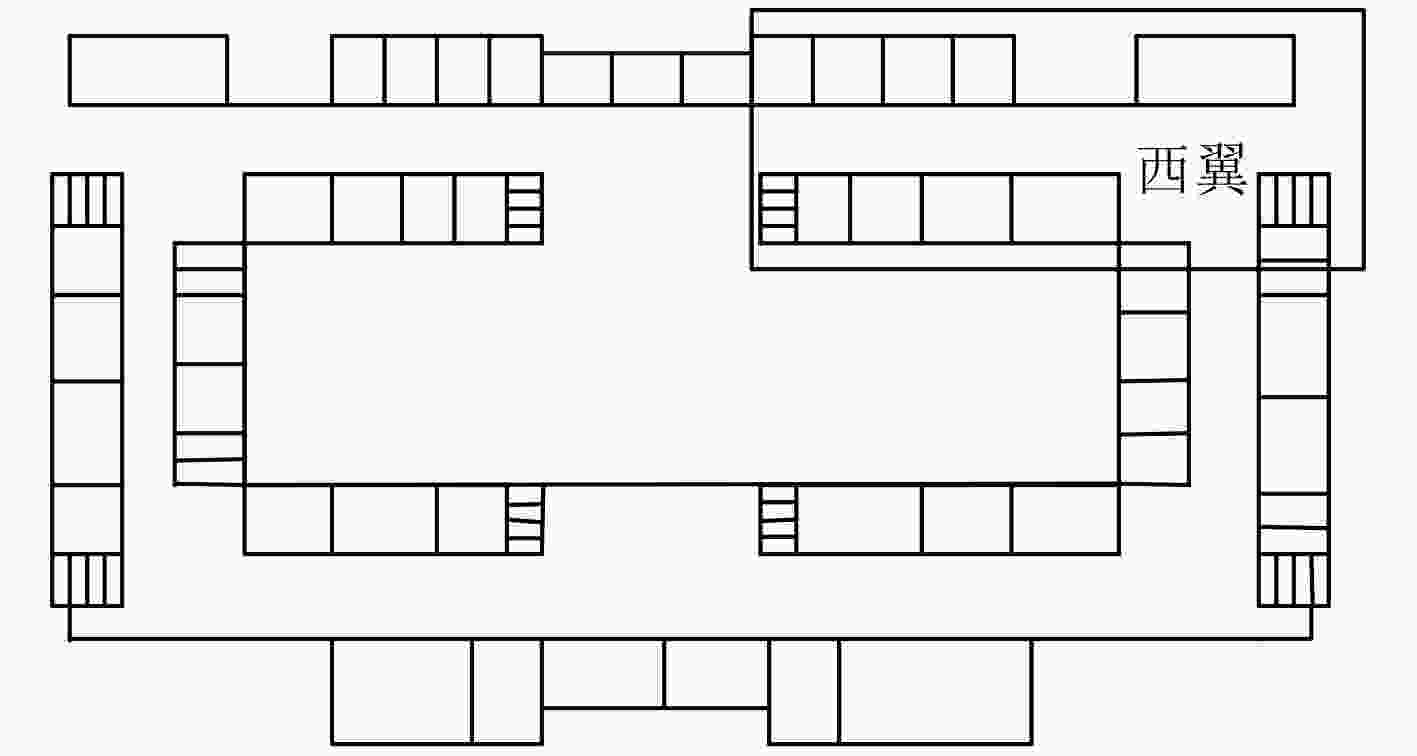

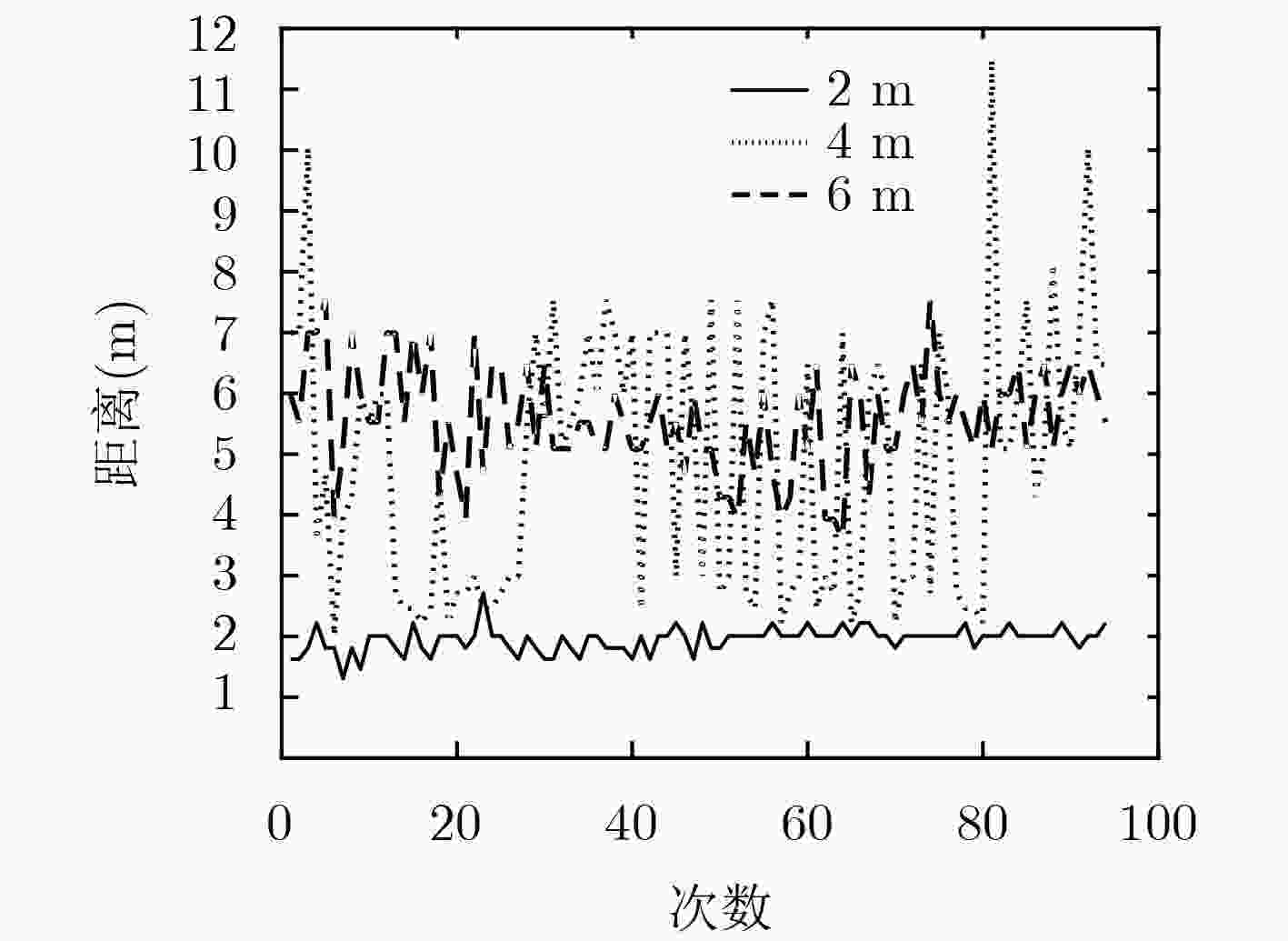

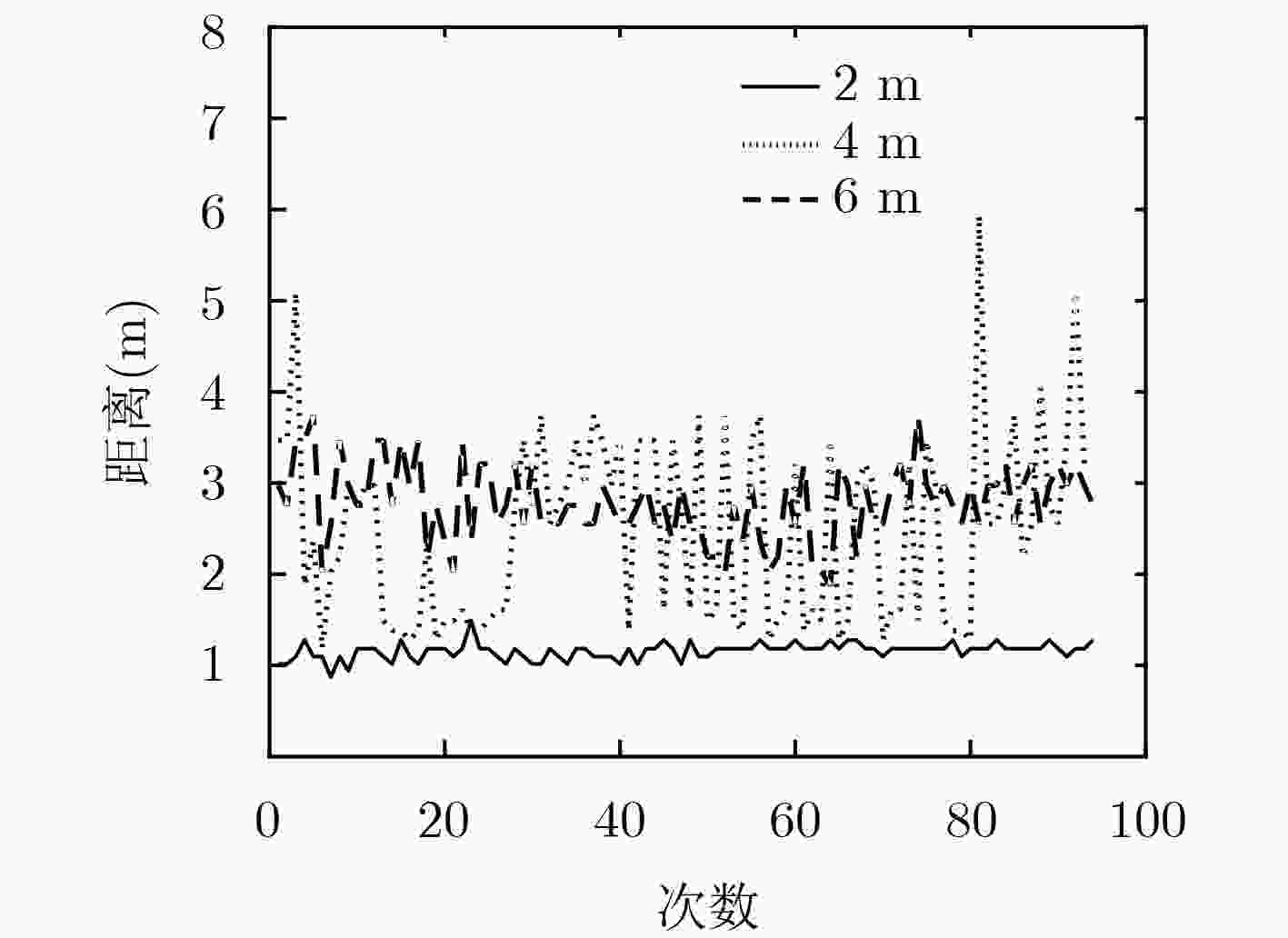

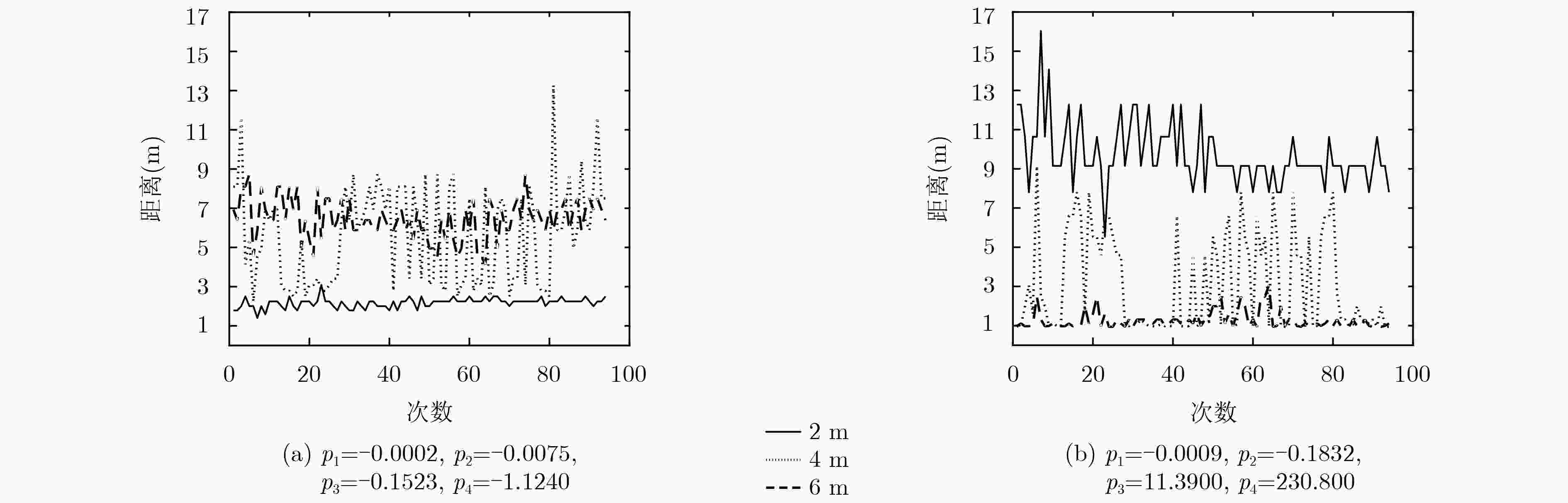

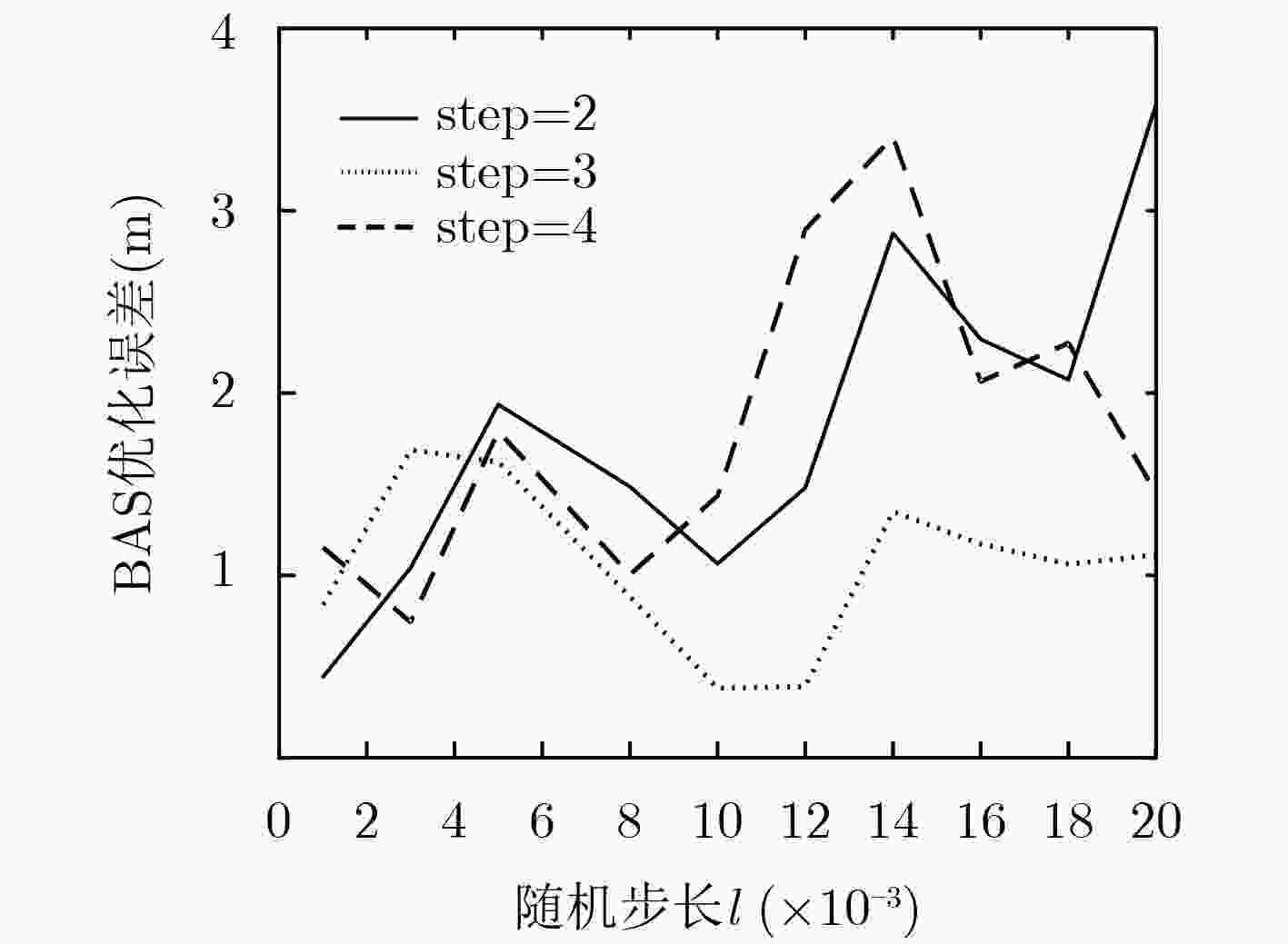

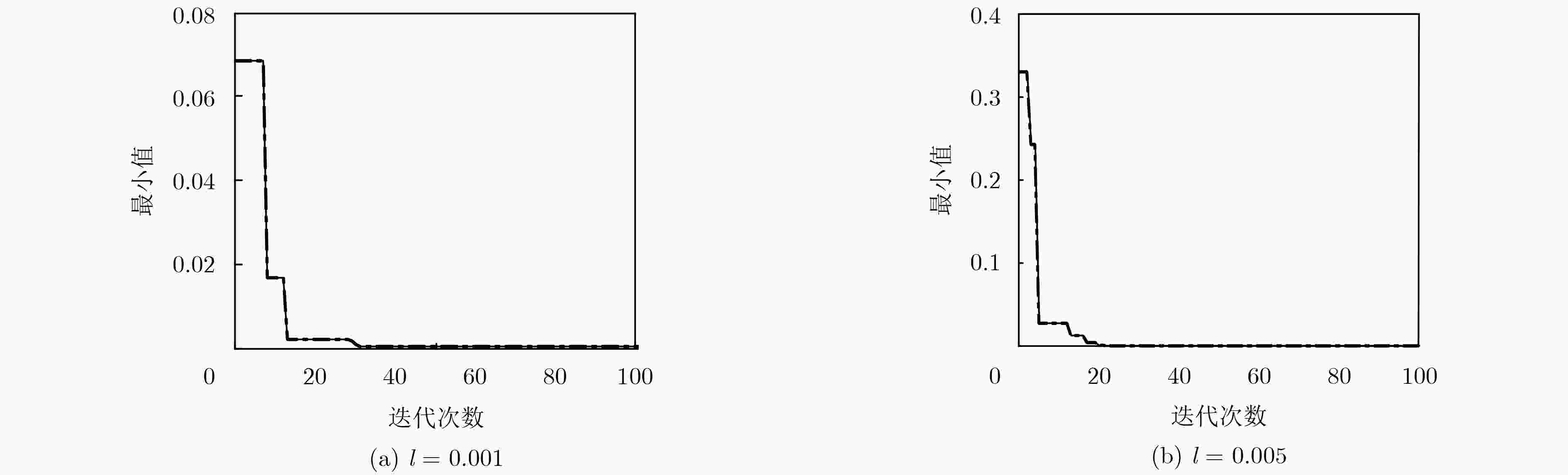

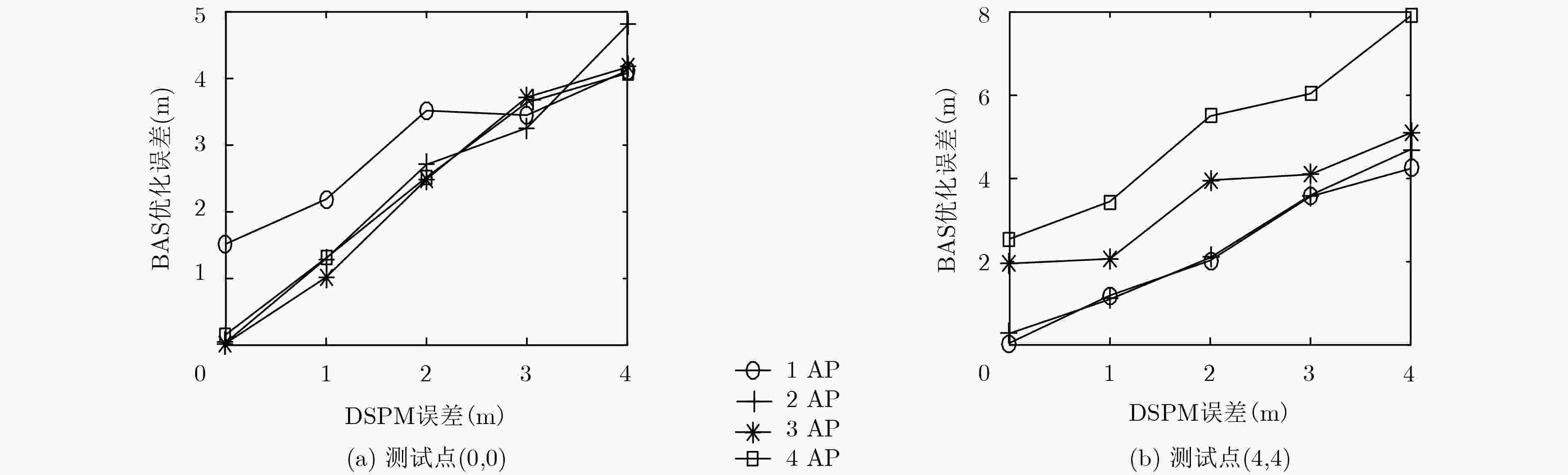

摘要: 在复杂的室内环境中,测得的接收信号强度(RSS)值会出现不同程度的波动,导致无法准确地刻画出无线信号传播模型。为了解决这个问题,在基于Wi-Fi测距定位模型下,该文提出一种普适的粗粒度定位方法。该方法通过对测量到的RSS值进行拟合,以此获取信号的传播模型;在此基础上计算出未知节点与接入点(AP)的距离,再利用天牛须算法实现未知节点定位,通过仿真验证此传播模型的性能以及该优化算法的有效性。Abstract: In complex indoor environment, the measured Received Signal Strength (RSS) values will fluctuate in different degrees, which lead to inaccurate characterization of wireless signal propagation model. To solve this problem, a universal coarse grained localization method is proposed based on the Wi-Fi ranging location model. This method gets the signal propagation model by fitting the measured RSS value. On this basis, the distance between the unknown node and the Access Point (AP) is calculated, then the location of the unknown node is realized by the beetle antennae search algorithm. The performance of the propagation model and the effectiveness of the optimization algorithm are verified by simulation.

-

表 1 本文算法与经典算法对比

真实位置 测量位置 误差(m) 收敛速度 BAS-DSPM (0, 0) (0.7123, 1.4437) 1.6098 迭代27次趋于平稳 PSO-DSPM (0, 0) (1.3654, –1.8031) 2.2617 迭代108次趋于平稳 PSO-经典测距模型 (0, 0) (–2.0462, 3.4623) 4.0217 迭代98次趋于平稳 -

MA Lin and XU Yubin. Received signal strength recovery in green WLAN indoor positioning system using singular value thresholding[J]. Sensors, 2015, 15(1): 1292–1311. doi: 10.3390/s150101292 SEN S, LEE J, KIM K H, et al. Avoiding multipath to revive inbuilding WiFi localization[C]. Proceedings of ACM 11th Annual International Conference on Mobile Systems, Applications, and Services, Taipei, China, 2013: 249–262. doi: 10.1145/2462456.2464463. 陈冰, 杨小玲. 一种基于概率密度的WLAN接入点定位的算法[J]. 电子与信息学报, 2015, 37(4): 855–862. doi: 10.11999/JEIT140661CHEN Bing and YANG Xiaoling. A WLAN access point localization algorithm based on probability density[J]. Journal of Electronics &Information Technology, 2015, 37(4): 855–862. doi: 10.11999/JEIT140661 钱志鸿, 孙大洋, LEUNG V. 无线网络定位综述[J]. 计算机学报, 2016, 39(6): 1237–1256. doi: 10.11897/SP.J.1016.2016.01237QIAN Zhihong, SUN Dayang, and LEUNG V. A survey on localization model in wireless networks[J]. Chinese Journal of Computers, 2016, 39(6): 1237–1256. doi: 10.11897/SP.J.1016.2016.01237 BAHL P and PADMANABHAN V N. RADAR: An in-building RF-based user location and tracking system[C]. Proceedings IEEE INFOCOM 2000. Conference on Computer Communications. Tel Aviv, Israel, 2000: 775–784. doi: 10.1109/INFCOM.2000.832252. 陈岭, 许晓龙, 杨清, 等. 基于三次样条插值的无线信号强度衰减模型[J]. 浙江大学学报: 工学版, 2011, 45(9): 1521–1527, 1538. doi: 10.3785/j.issn.1008-973X.2011.09.003CHEN Ling, XU Xiaolong, YANG Qing, et al. Wireless signal strength propagation model base on cubic spline interpolation[J]. Journal of Zhejiang University:Engineering Science, 2011, 45(9): 1521–1527, 1538. doi: 10.3785/j.issn.1008-973X.2011.09.003 LIM H, KUNG L C, HOU J C, et al. Zero-Configuration indoor localization over IEEE 802.11 wireless infrastructure[J]. Wireless Networks, 2010, 16(2): 405–420. doi: 10.1007/s11276-008-0140-3 JI Yiming, BIAZ S, PANDEY S, et al. ARIADNE: A dynamic indoor signal map construction and localization system[C]. Proceedings of the 4th ACM International Conference on Mobile Systems, Applications and Services, Uppsala, Sweden, 2006: 151–164. doi: 10.1145/1134680.1134697. JUN J, HE Liang, GU Yu, et al. Low-overhead WiFi fingerprinting[J]. IEEE Transactions on Mobile Computing, 2018, 17(3): 590–603. doi: 10.1109/TMC.2017.2737426 ZOU Han, JIN Ming, JIANG Hao, et al. WinIPS: WiFi-based non-Intrusive indoor positioning system with online radio map construction and adaptation[J]. IEEE Transactions on Wireless Communications, 2017, 16(12): 8118–8130. doi: 10.1109/TWC.2017.2757472 WU Chenshu, YANG Zheng, and XIAO Chaowei. Automatic radio map adaptation for indoor localization using smartphones[J]. IEEE Transactions on Mobile Computing, 2018, 17(3): 517–528. doi: 10.1109/TMC.2017.2737004 AHN J and HAN D. Crowd-assisted radio map construction for Wi-Fi positioning systems[C]. Proceedings of 2017 International Conference on Indoor Positioning and Indoor Navigation, Sapporo, Japan, 2017: 1–8. doi: 10.1109/IPIN.2017.8115872. LI Qiyue, LI Wei, SUN Wei, et al. Fingerprint and assistant nodes based Wi-Fi localization in complex indoor environment[J]. IEEE Access, 2016, 4: 2993–3004. doi: 10.1109/ACCESS.2016.2579879 ZHANG Wei, HUA Xianghong, YU Kegen, et al. Domain clustering based WiFi indoor positioning algorithm[C]. Proceedings of 2016 International Conference on Indoor Positioning and Indoor Navigation, Alcala de Henares, Spain, 2016: 1–5. doi: 10.1109/IPIN.2016.7743641. 王硕朋, 杨鹏, 孙昊. 基于声音位置指纹的室内声源定位方法[J]. 北京工业大学学报, 2017, 43(2): 224–229.WANG Shuopeng, YANG Peng, and SUN Hao. Indoor sound-position fingerprint method based on scenario analysis[J]. Journal of Beijing University of Technology, 2017, 43(2): 224–229. 刘影, 贾迪, 王和章. 复杂环境下基于CFSFDP的自适应室内定位方法[J]. 信号处理, 2018, 34(4): 465–475.LIU Ying, JIA Di, and WANG Hezhang. Adaptive indoor localization algorithm of based on CFSFDP in complex environment[J]. Journal of Signal Processing, 2018, 34(4): 465–475. JIANG Xiangyuan and LI Shuai. BAS: Beetle antennae search algorithm for optimization problems[J]. arXiv: 1710.10724, 2017. -

下载:

下载:

下载:

下载: