Research and Development on Applications of Convolutional Neural Networks of Radar Automatic Target Recognition

-

摘要:

自动目标识别(ATR)是雷达信息处理领域的重要研究方向。由于卷积神经网络(CNN)无需进行特征工程,图像分类性能优越,因此在雷达自动目标识别领域研究中受到越来越多的关注。该文综合论述了CNN在雷达图像处理中的应用进展。首先介绍了雷达自动目标识别相关知识,包括雷达图像的特性,并指出了传统的雷达自动目标识别方法局限性。给出了CNN卷积神经网络原理、组成和在计算机视觉领域的发展历程。然后着重介绍了CNN在雷达自动目标识别中的研究现状,其中详细介绍了合成孔径雷达(SAR)图像目标的检测与识别方法。接下来对雷达自动目标识别面临的挑战进行了深入分析。最后对CNN新理论、新模型,以及雷达新成像技术和未来复杂环境下的应用进行了展望。

Abstract:Automatic Target Recognition(ATR) is an important research area in the field of radar information processing. Because the deep Convolution Neural Network(CNN) does not need to carry out feature engineering and the performance of image classification is superior, it attracts more and more attention in the field of radar automatic target recognition. The application of CNN to radar image processing is reviewed in this paper. Firstly, the related knowledges including the characteristics of the radar image is introduced, and the limitations of traditional radar automatic target recognition methods are pointed out. The principle, composition, development of CNN and the field of computer vision are introduced. Then, the research status of CNN in radar automatic target recognition is provided. The detection and recognition method of SAR image are presented in detail. The challenge of radar automatic target recognition is analyzed. Finally, the new theory and model of convolution neural network, the new imaging technology of radar and the application to complex environments in the future are prospected.

-

表 1 光学图像和雷达图像的差异

特性 光学图像 雷达图像 波段 可见光,红外 微波段 信号形式 多波段灰度信息 单波段复信号 成像原理 能量聚焦积累 相位相干积累 尺度特性 和成像距离有关 目标尺寸不随成像距离变化 成像方向 俯仰角-方位角 距离向-方位角 表 2 部分典型网络的参数总结

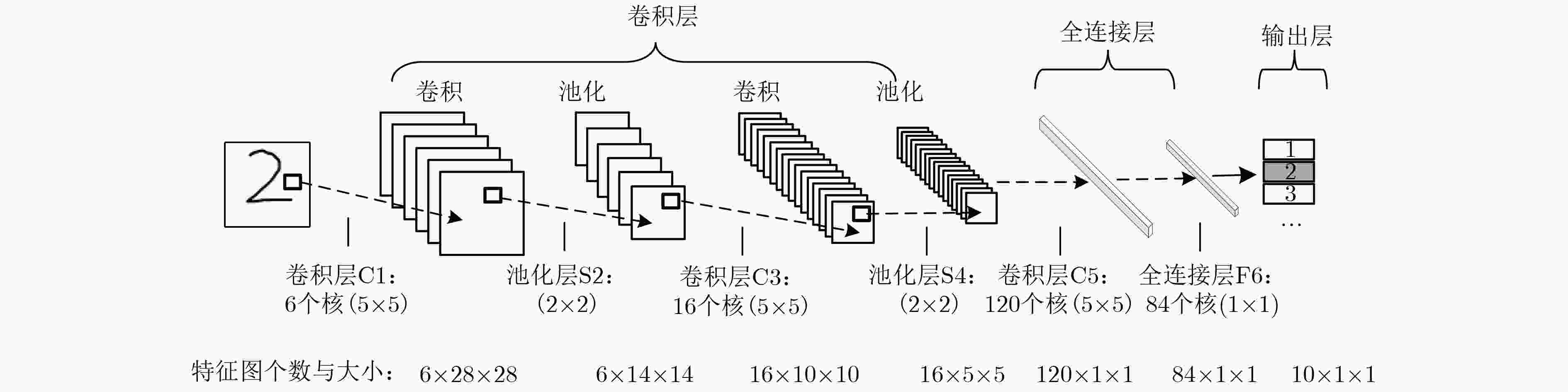

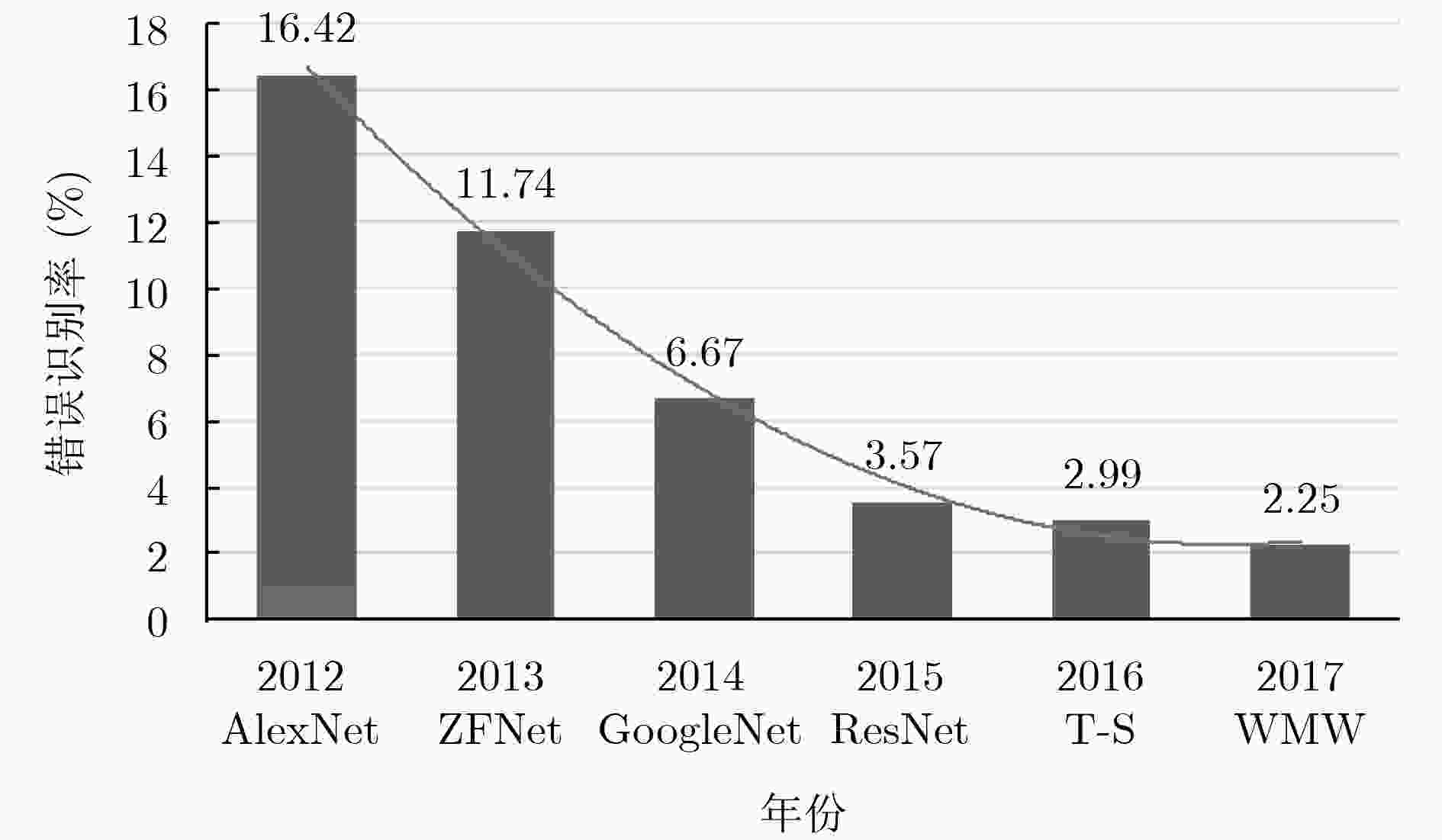

LeNet5 AlexNet Overfeatfast VGG16 GoogleNetV1 ResNet50 输入图像尺寸 28×28 227×227 231×231 224×224 224×224 224×224 卷积层数量 2 5 5 13 57 53 全连接层数量 2 3 3 3 1 1 卷积核大小 5 3,5,11 3,5,11 3 1,3,5,7 1,3,7 步长 1 1,4 1,4 1 1,2 1,2 权值参数数量 60 k 61 M 146 M 138 M 7 M 25.5 M 乘积运算数量 341 k 724 M 2.8 G 15.5 G 1.43 G 3.9 G Top-5误差 – 16.4 14.2 7.4 6.7 5.25 表 3 MSTAR数据集的目标类型和样本数量

数据集 2S1 BMP2 BRD M2 BTR 60 BTR 70 D7 T62 T72 ZIL 131 ZSU 234 训练集 299 233 298 256 233 299 299 298 299 299 测试集 274 587 274 195 196 274 196 274 274 274 表 4 常见数据增强技术

名称 主要方法 旋转变换 将图像旋转一定角度 翻转变换 沿水平或垂直方向翻转图像 缩放变换 放大或缩小图像 平移变换 在图像平面上对图像进行平移 尺度变换 对图像按照置顶的尺度因子进行缩放,改变图像内容的大小或模糊程度 反射变换 对称变换,包括轴反射变换和镜面反射变换 噪声扰动 在图像内增加噪声,如指数噪声,高斯噪声,瑞利噪声,椒盐噪声等 表 5 基于CNN的目标检测方法对比

方法 提出场合 核心思想 MAP(%) 主要特点 候选窗方法 RCNN ECCV 2014 选择搜索方法生成候选窗 66.0 训练分多个阶段,每个候选窗都需要用CNN处理,占用磁盘空间大,处理效率低 Fast RCNN ICCV2015 加入了SPPnet 70.0 选择搜索方法生成候选窗,耗时长,无法满足实时应用 Faster RCNN NIPS2015 提出了RPN网络,融合区域生成与CNN 73.2 性能与速度较好的折中,但区域生成方式计算量依然很大,不能实时处理 R-FCN NIPS2016 RPN+位置敏感的预测层+ROI polling+投票决策层 76.6 速度比Faster RCNN快,且精度相当 回归方法 YOLO CVPR2016 将检测问题变为回归问题 57.9 没有区域生成步骤,网格回归的定位性能较弱,检测精度不高。 SSD ECCV2016 YOLO+Proposal+多尺度 73.9 速度非常快,性能也不错 表 6 CNN在雷达图像识别应用进展的思想与方法概要

提升类型 主要思想 引用文献和方法概要说明 快速算法 快速寻优预训练 文献[47]:带动量小批量随机梯度下降,快速寻找全局最优点 文献[45]:预训练较浅卷积网络,实现无监督快速检测。 文献[53]:用大样本数据对卷积网络进行预训练 用其他结构取代全连接层 文献[40,47]:低自由度稀疏连通卷积结构 文献[39]:SVM代替FC 文献[53]:用超限学习机替换FC 抽取特征再训练 文献[54]:先抽取特征再训练的两步快速训练方法 提升算法 提高网络的泛化能力 文献[47]:Dropout和早期停止 文献[52]:将卷积层与2维PCA方法结合 代价函数改进 文献[46]:代价函数中引入类别可分性度量提高类别区分能力 含噪样本训练 文献[49]:基于概率转移模型增强含噪标记下分类模型鲁棒性。 扩展算法 迁移学习 文献[26,53,55]:大样本预训练,迁移学习加快训练速度 CAD模型仿真 文献[56]: 采用CAD模型目标仿真解决SAR真实数据有限问题 文献[57]: CAD模型生成不同方位和俯仰角度的HRRP图像 预处理提升信息的利用率 文献[41]:形态学成分分析预处理提升性能 文献[58]:采用去噪自编码器预训练 小样本深度训练网络 文献[42,44]:卷积高速公路单元在小样本条件下训练深度网络 文献[59]:无监督和有监督训练结合,应对标签数据有限情况 -

KRIZHEVSKY A, SUTSKEVER I, and HINTON G E. Imagenet classification with deep convolutional neural networks[C]. The 25th International Conference on Neural Information Processing Systems, Lake Tahoe, USA, 2012: 1097–1105. CHENG Gong, HAN Junwei, and LU Xiaoqiang. Remote sensing image scene classification: benchmark and state of the art[J]. Proceedings of the IEEE, 2017, 105(10): 1865–1883. doi: 10.1109/JPROC.2017.2675998 陈小龙, 关键, 何友, 等. 高分辨稀疏表示及其在雷达动目标检测中的应用[J]. 雷达学报, 2017, 6(3): 239–251. doi: 10.12000/JR16110CHEN Xiaolong, GUAN Jian, HE You, et al. High-resolution sparse representation and its applications in radar moving target detection[J]. Journal of Radars, 2017, 6(3): 239–251. doi: 10.12000/JR16110 BALL J E, ANDERSON D T, and CHAN C S. Comprehensive survey of deep learning in remote sensing: theories, tools, and challenges for the community[J]. Journal of Applied Remote Sensing, 2017, 11(4): 042609. doi: 10.1117/1.JRS.11.042609 PEI Jifang, HUANG Yulin, HUO Weibo, et al. SAR automatic target recognition based on multiview deep learning framework[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(4): 2196–2210. doi: 10.1109/tgrs.2017.2776357 GOODFELLOW I, BENGIO Y, and COURVILLE A. Deep Learning[M]. Cambridge, Massachusetts: MIT Press, 2016. LECUN Yann, BOTTOU Léon, BENGIO Yoshua, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278–2324. doi: 10.1109/5.726791 RUSSAKOVSKY O, DENG Jia, SU Hao, et al. Imagenet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211–252. doi: 10.1007/s11263-015-0816-y ZEILER M D and FERGUS R. Visualizing and understanding convolutional networks[C]. The 13th European Conference on Computer Vision, Zurich, Switzerland, 2014: 818–833. SZEGEDY C, LIU Wei, JIA Yangqing, et al. Going deeper with convolutions[C]. The IEEE Conference on Computer Vision and Pattern Recognition, Boston, USA, 2015: 1–9. SIMONYAN K and ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. http://arxiv.org/abs/1409.1556, 2014. HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]. The IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 770–778. doi: 10.1109/CVPR.2016.90. HU Jie, SHEN Li, ALBANIE S, et al. Squeeze-and-excitation networks[EB/OL]. https://arxiv.org/abs/1709.01507, 2017. 许强, 李伟, LOUMBI P. 深度卷积神经网络在SAR自动目标识别领域的应用综述[J]. 电讯技术, 2018, 58(1): 106–112. doi: 10.3969/j.issn.1001-893x.2018.01.019XU Qiang, LI Wei, and LOUMBI P. Applications of Deep convolutional neural network in SAR automatic target recognition: a summarization[J]. Telecommunication Engineering, 2018, 58(1): 106–112. doi: 10.3969/j.issn.1001-893x.2018.01.019 苏宁远, 陈小龙, 关键, 等. 基于卷积神经网络的海上微动目标检测与分类方法[J]. 雷达学报, 2018, 7(5): 565–574. doi: 10.12000/JR18077SU Ningyuan, CHEN Xiaolong, GUAN Jian, et al. Detection and classification of maritime target with micro-motion based on CNNs[J]. Journal of Radars, 2018, 7(5): 565–574. doi: 10.12000/JR18077 杜兰, 刘彬, 王燕, 等. 基于卷积神经网络的SAR图像目标检测算法[J]. 电子与信息学报, 2016, 38(12): 3018–3025. doi: 10.11999/JEIT161032DU Lan, LIU Bin, WANG Yan, et al. Target detection method based on convolutional neural network for SAR image[J]. Journal of Electronics &Information Technology, 2016, 38(12): 3018–3025. doi: 10.11999/JEIT161032 GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]. The IEEE Conference on Computer Vision and Pattern Recognition, Columbus, USA, 2014: 580–587. HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[C]. The 13th European Conference on Computer Vision, Zurich, Switzerland, 2014: 346–361. GIRSHICK R. Fast R-CNN[C]. The IEEE international Conference on Computer Vision, Santiago, Chile, 2015: 1440–1448. REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[C]. The 28th International Conference on Neural Information Processing Systems, Montreal, Canada, 2015: 91–99. DAI Jifeng, LI Yi, HE Kaiming, et al. R-FCN: Object detection via region-based fully convolutional networks[C]. The 30th International Conference on Neural Information Processing Systems, Barcelona, Spain, 2016: 379–387. KONG Tao, YAO Anbang, CHEN Yurong, et al. Hypernet: Towards accurate region proposal generation and joint object detection[C]. The IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 845–853. LIN T Y, DOLLÁR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]. The IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 936–944. HE Kaiming, GKIOXARI G, DOLLÁR P, et al. Mask R-CNN[C]. The 2017 IEEE International Conference on Computer Vision, Venice, Italy, 2017: 2980–2988. WANG Sifei, CUI Zongyong, and CAO Zongjie. Target recognition in large scene SAR images based on region proposal regression[C]. The 2017 IEEE International Geoscience and Remote Sensing Symposium, Fort Worth, USA, 2017: 3297–3300. LI Jianwei, QU Changwen, and SHAO Jiaqi. Ship detection in SAR images based on an improved faster R-CNN[C]. The 2017 SAR in Big Data Era: Models, Methods and Applications, Beijing, China, 2017: 1–6. KANG Miao, LENG Xiangguang, LIN Zhao, et al. A modified faster R-CNN based on CFAR algorithm for SAR ship detection[C]. The 2017 International Workshop on Remote Sensing with Intelligent Processing, Shanghai, China, 2017: 1–4. KANG Miao, JI Kefeng, LENG Xiangguang, et al. Contextual region-based convolutional neural network with multilayer fusion for SAR ship detection[J]. Remote Sensing, 2017, 9(8): 860. doi: 10.3390/rs9080860 JIAO Jiao, ZHANG Yue, SUN Hao, et al. A densely connected end-to-end neural network for multiscale and multiscene SAR ship detection[J]. IEEE Access, 2018, 6: 20881–20896. doi: 10.1109/ACCESS.2018.2825376 ZHONG Yanfei, HAN Xiaobing, and ZHANG Liangpei. Multi-class geospatial object detection based on a position-sensitive balancing framework for high spatial resolution remote sensing imagery[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 138: 281–294. doi: 10.1016/j.isprsjprs.2018.02.014 REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]. The 2016 IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 779–788. LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: Single shot multibox detector[C]. The 14th European Conference on Computer Vision, Amsterdam, The Netherlands, 2016: 21–37. WANG Yuanyuan, WANG Chao, ZHANG Hong, et al. Combing single shot multibox detector with transfer learning for ship detection using Chinese Gaofen-3 images[C]. The 2017 Progress in Electromagnetics Research Symposium - Fall, Singapore, 2018: 712–716. WANG Yuanyuan, WANG Chao, and ZHANG Hong. Combining a single shot multibox detector with transfer learning for ship detection using sentinel-1 SAR images[J]. Remote Sensing Letters, 2018, 9(8): 780–788. doi: 10.1080/2150704X.2018.1475770 KONG Tao, SUN Fuchun, YAO Anbang, et al. Ron: Reverse connection with objectness prior networks for object detection[C]. The 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 5244–5252. CUI Zongyong, DANG Sihang, CAO Zongjie, et al. SAR target recognition in large scene images via region-based convolutional neural networks[J]. Remote Sensing, 2018, 10(5): 776. doi: 10.3390/rs10050776 NI Jiacheng and XU Yuelei. SAR automatic target recognition based on a visual cortical system[C]. The 6th International Congress on Image and Signal Processing, Hangzhou, China, 2013: 778–782. CHEN Sizhe and WANG Haipeng. SAR target recognition based on deep learning[C]. The 2014 International Conference on Data Science and Advanced Analytics, Shanghai, China, 2014: 541–547. WAGNER S. Combination of convolutional feature extraction and support vector machines for radar ATR[C]. The 17th International Conference on Information Fusion, Salamanca, Spain, 2014: 1–6. WANG Haipeng, CHEN Sizhe, XU Feng, et al. Application of deep-learning algorithms to MSTAR data[C]. The 2015 IEEE International Geoscience and Remote Sensing Symposium, Milan, Italy, 2015: 3743–3745. WAGNER S. Morphological component analysis in SAR images to improve the generalization of ATR systems[C]. The 3rd International Workshop on Compressed Sensing Theory and its Applications to Radar, Sonar and Remote Sensing, Pisa, Italy, 2015: 46–50. SCHWEGMANN C P, KLEYNHANS W, SALMON B P, et al. Very deep learning for ship discrimination in Synthetic Aperture Radar imagery[C]. The 2016 IEEE International Geoscience and Remote Sensing Symposium, Beijing, China, 2016: 104–107. CHO J H and PARK C G. Additional feature CNN based automatic target recognition in SAR image[C]. The 40th Asian Conference on Defence Technology, Tokyo, Japan, 2017: 1–4. LIN Zhao, JI Kefeng, KANG Miao, et al. Deep convolutional highway unit network for SAR target classification with limited labeled training data[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(7): 1091–1095. doi: 10.1109/lgrs.2017.2698213 HE Hao, WANG Shicheng, YANG Dongfang, et al. SAR target recognition and unsupervised detection based on convolutional neural network[C]. The 2017 Chinese Automation Congress, Jinan, China, 2017: 435–438. 田壮壮, 占荣辉, 胡杰民, 等. 基于卷积神经网络的SAR图像目标识别研究[J]. 雷达学报, 2016, 5(3): 320–325. doi: 10.12000/JR16037TIAN Zhuangzhuang, ZHAN Ronghui, HU Jiemin, et al. SAR ATR based on convolutional neural network[J]. Journal of Radars, 2016, 5(3): 320–325. doi: 10.12000/JR16037 CHEN Sizhe, WANG Haipeng, XU Feng, et al. Target classification using the deep convolutional networks for SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(8): 4806–4817. doi: 10.1109/tgrs.2016.2551720 WILMANSKI M, KREUCHER C, and LAUER J. Modern approaches in deep learning for SAR ATR[J]. SPIE, 2016, 9843: 98430N. doi: 10.1117/12.2220290 赵娟萍, 郭炜炜, 柳彬, 等. 基于概率转移卷积神经网络的含噪标记SAR图像分类[J]. 雷达学报, 2017, 6(5): 514–523. doi: 10.12000/JR16140ZHAO Juanping, GUO Weiwei, LIU Bin, et al. Convolutional neural network-based SAR image classification with noisy labels[J]. Journal of Radars, 2017, 6(5): 514–523. doi: 10.12000/JR16140 AMRANI M and JIANG Feng. Deep feature extraction and combination for synthetic aperture radar target classification[J]. Journal of Applied Remote Sensing, 2017, 11(4): 042616. doi: 10.1117/1.Jrs.11.042616 WANG Ning, WANG Yinghua, LIU Hongwei, et al. Feature-fused SAR target discrimination using multiple convolutional neural networks[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(10): 1695–1699. doi: 10.1109/lgrs.2017.2729159 ZHENG Ce, JIANG Xue, and LIU Xingzhao. Generalized synthetic aperture radar automatic target recognition by convolutional neural network with joint use of two-dimensional principal component analysis and support vector machine[J]. Journal of Applied Remote Sensing, 2017, 11(4): 046007. doi: 10.1117/1.Jrs.11.046007 刘晨, 曲长文, 周强, 等. 基于卷积神经网络迁移学习的SAR图像目标分类[J]. 现代雷达, 2018, 40(3): 38–42. doi: 10.16592/j.cnki.1004-7859.2018.03.009LIU Chen, QU Changwen, ZHOU Qiang, et al. SAR image target classification based on convolutional neural network transfer learning[J]. Modern Radar, 2018, 40(3): 38–42. doi: 10.16592/j.cnki.1004-7859.2018.03.009 LI Xuan, LI Chunsheng, WANG Pengbo, et al. SAR ATR based on dividing CNN into CAE and SNN[C]. The 5th IEEE Asia-Pacific Conference on Synthetic Aperture Radar, Singapore, 2015: 676–679. 李松, 魏中浩, 张冰尘, 等. 深度卷积神经网络在迁移学习模式下的SAR目标识别[J]. 中国科学院大学学报, 2018, 35(1): 75–83. doi: 10.7523/j.issn.2095-6134.2018.01.010LI Song, WEI Zhonghao, ZHANG Bingchen, et al. Target recognition using the transfer learning-based deep convolutional neural networks for SAR images[J]. Journal of University of Chinese Academy of Sciences, 2018, 35(1): 75–83. doi: 10.7523/j.issn.2095-6134.2018.01.010 ØDEGAARD N, KNAPSKOG A O, COCHIN C, et al. Classification of ships using real and simulated data in a convolutional neural network[C]. The 2016 IEEE Radar Conference, Philadelphia, USA, 2016: 1–6. KARABAYIR O, YUCEDAG O M, KARTAL M Z, et al. Convolutional neural networks-based ship target recognition using high resolution range profiles[C]. The 18th International Radar Symposium, Prague, Czech Republic, 2017. BENTES C, VELOTTO D, and LEHNER S. Target classification in oceanographic SAR images with deep neural networks: Architecture and initial results[C]. The 2015 IEEE International Geoscience and Remote Sensing Symposium, Milan, Italy, 2015: 3703–3706. WANG Zhaocheng, DU Lan, WANG Fei, et al. Multi-scale target detection in SAR image based on visual attention model[C]. The 5th IEEE Asia-Pacific Conference on Synthetic Aperture Radar, Singapore, 2015: 704–709. YUAN Lele. A time-frequency feature fusion algorithm based on neural network for HRRP[J]. Progress in Electromagnetics Research, 2017, 55: 63–71. doi: 10.2528/PIERM16123002 BENGIO Y, MESNARD T, FISCHER A, et al. STDP-compatible approximation of backpropagation in an energy-based model[J]. Neural Computation, 2017, 29(3): 555–577. doi: 10.1162/NECO_a_00934 LECUN Y, BENGIO Y, and HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436–444. doi: 10.1038/nature14539 HOWARD A G, ZHU Menglong, CHEN Bo, et al. Mobilenets: Efficient convolutional neural networks for mobile vision applications[EB/OL]. http://arxiv.org/abs/1704.04861, 2017. HUANG Gao, LIU Zhuang, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]. The IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 2261–2269. GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]. The 27th International Conference on Neural Information Processing Systems, Montreal, Canada, 2014: 2672–2680. -

下载:

下载:

下载:

下载: