Virtual Network Function Dynamic Deployment Algorithm Based on Prediction for 5G Network Slicing

-

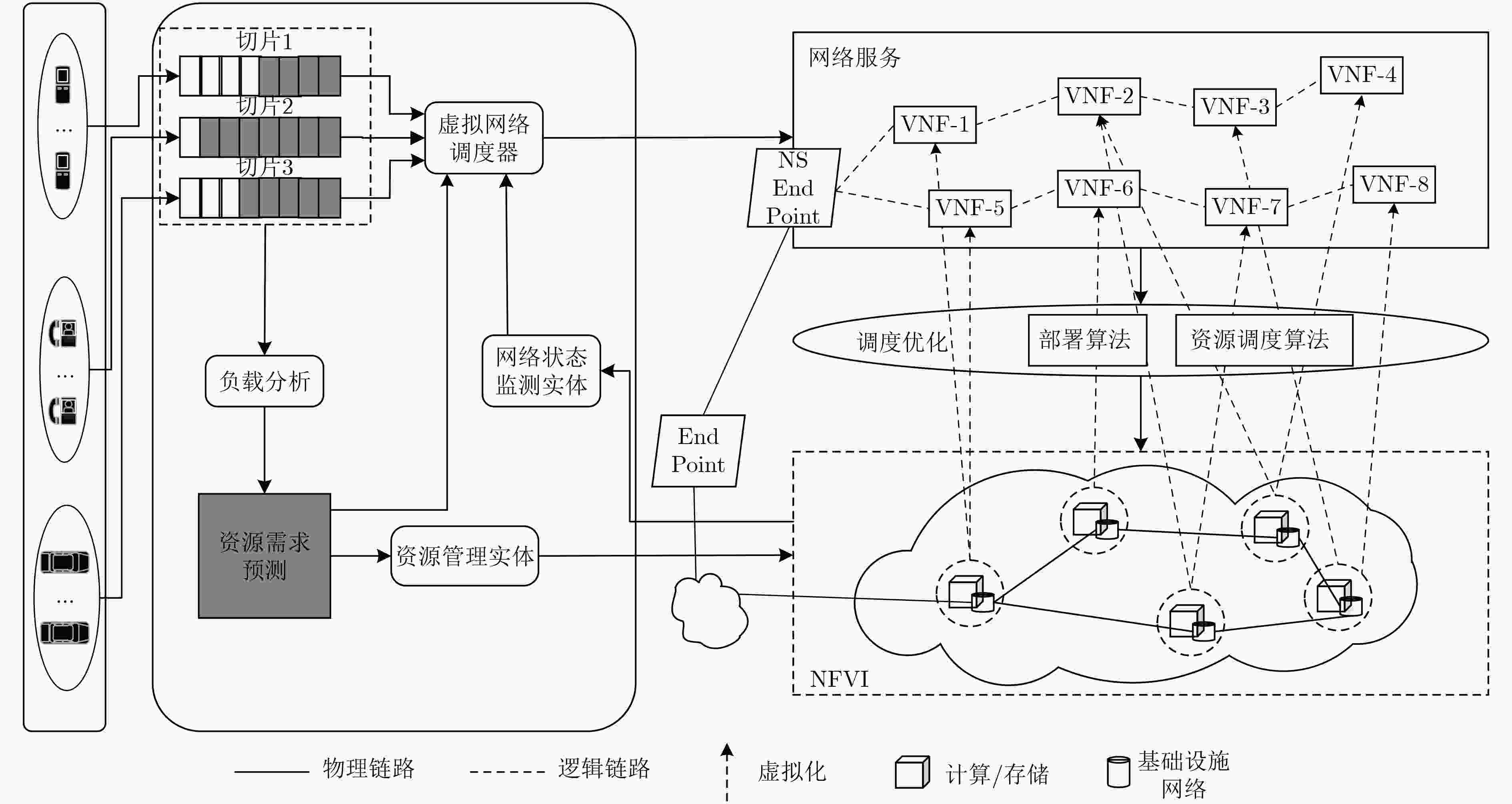

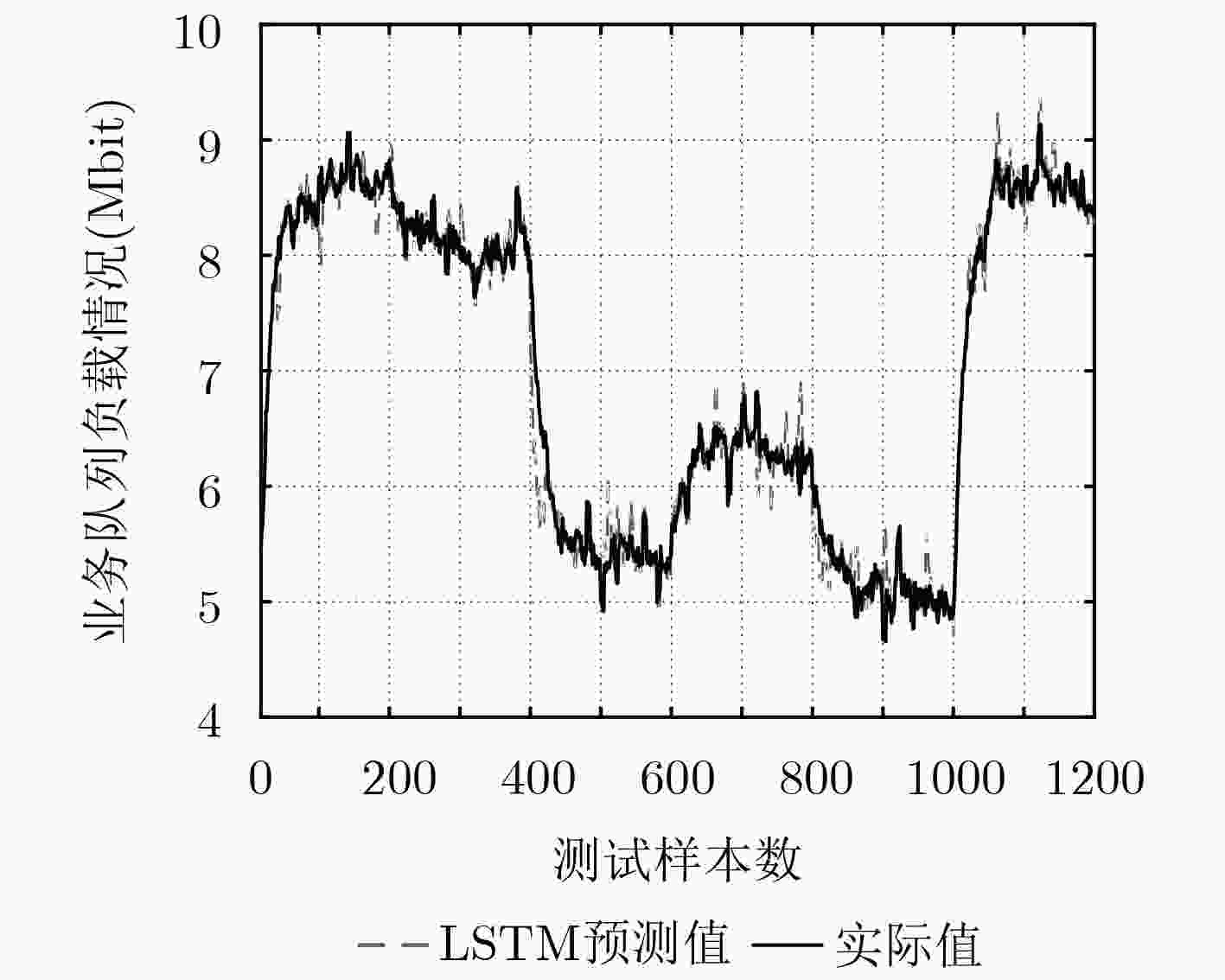

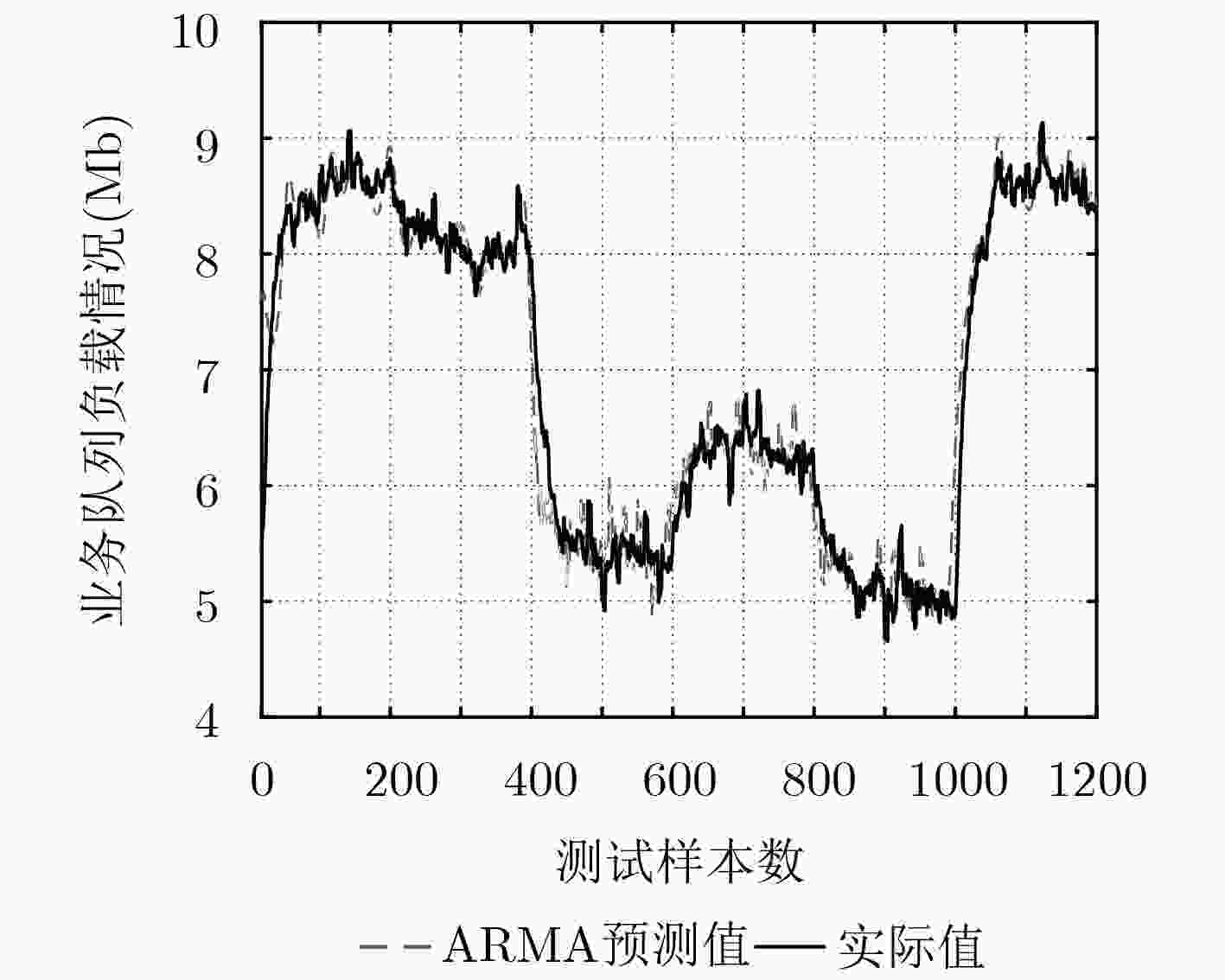

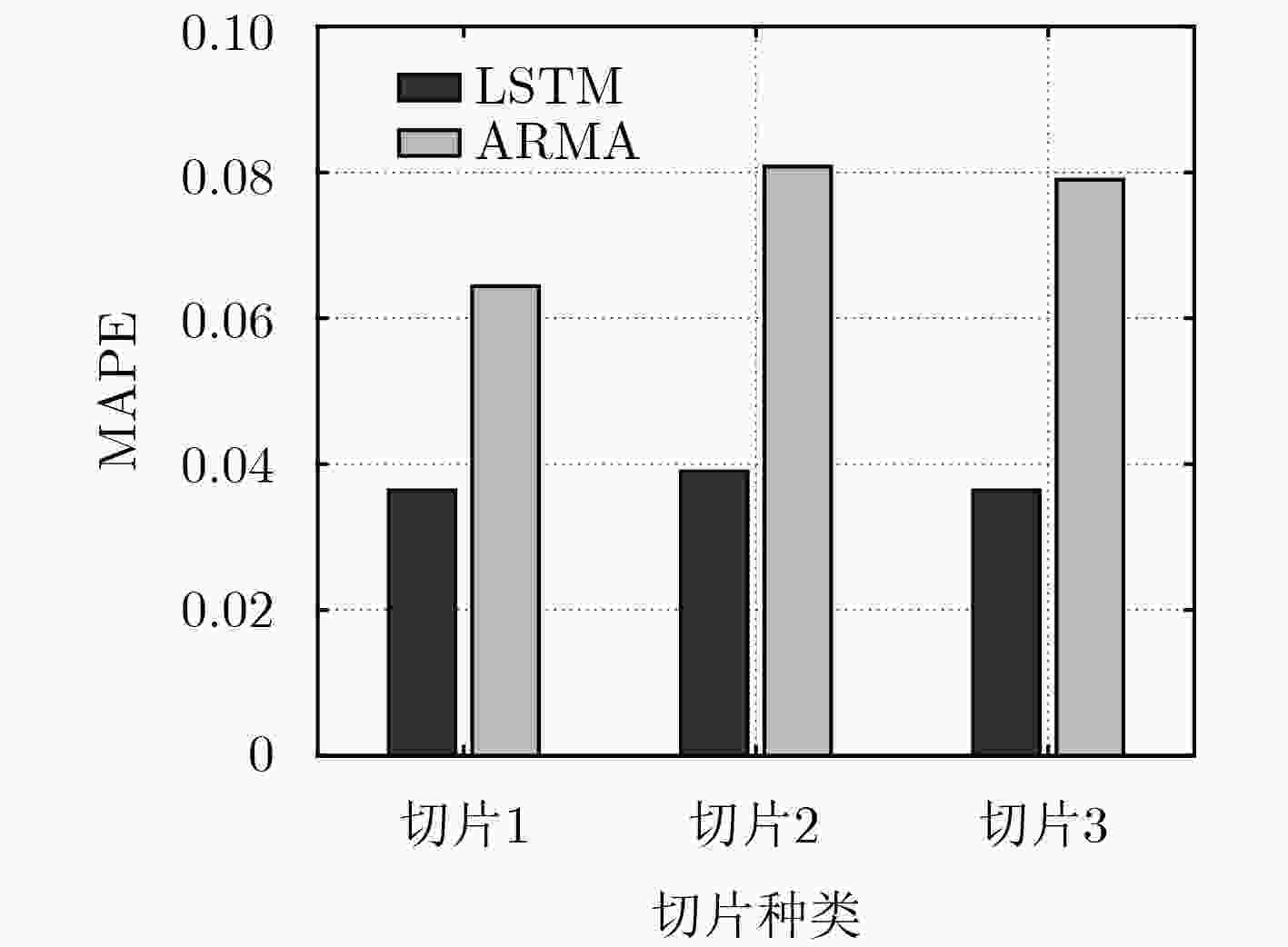

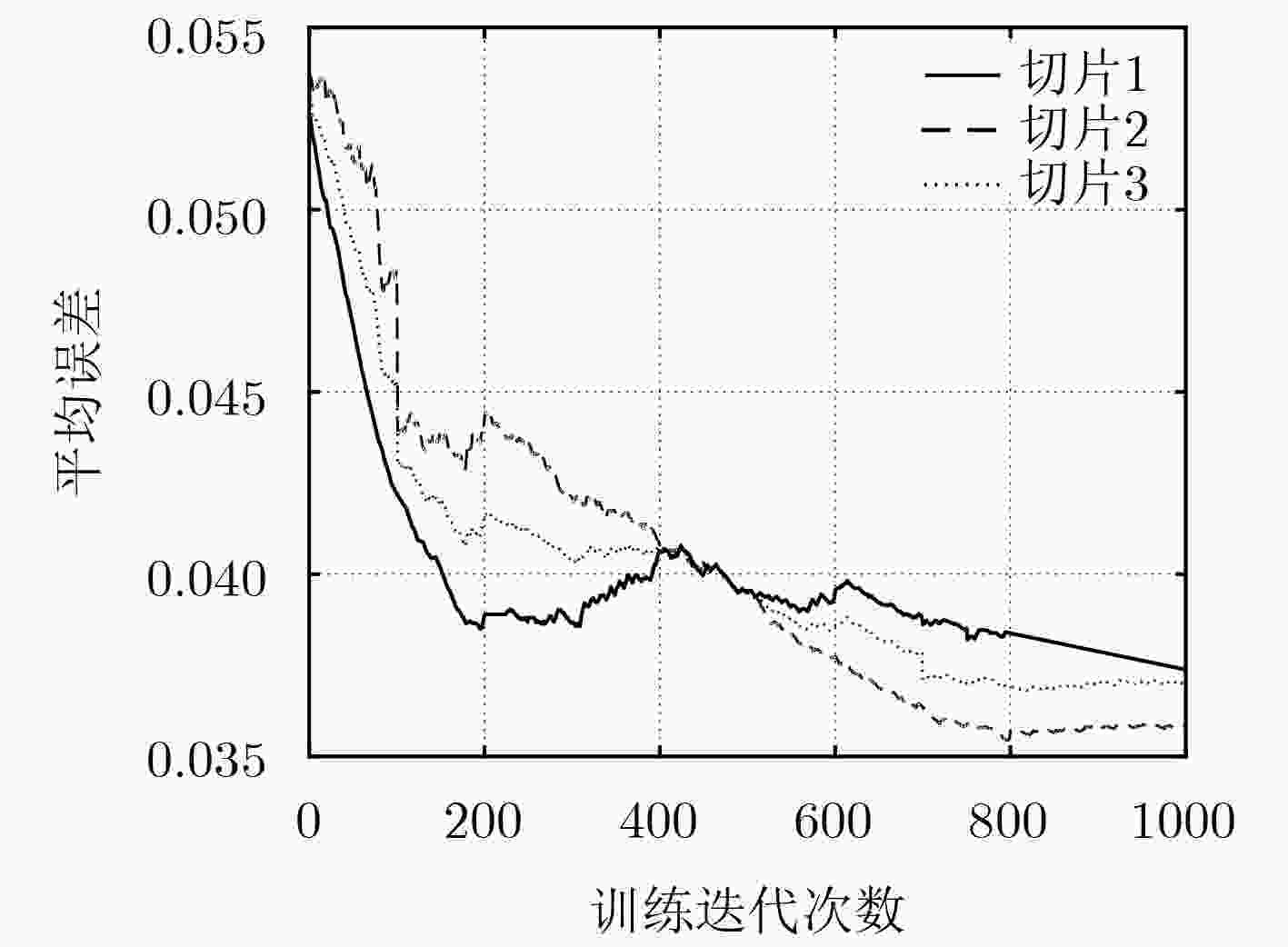

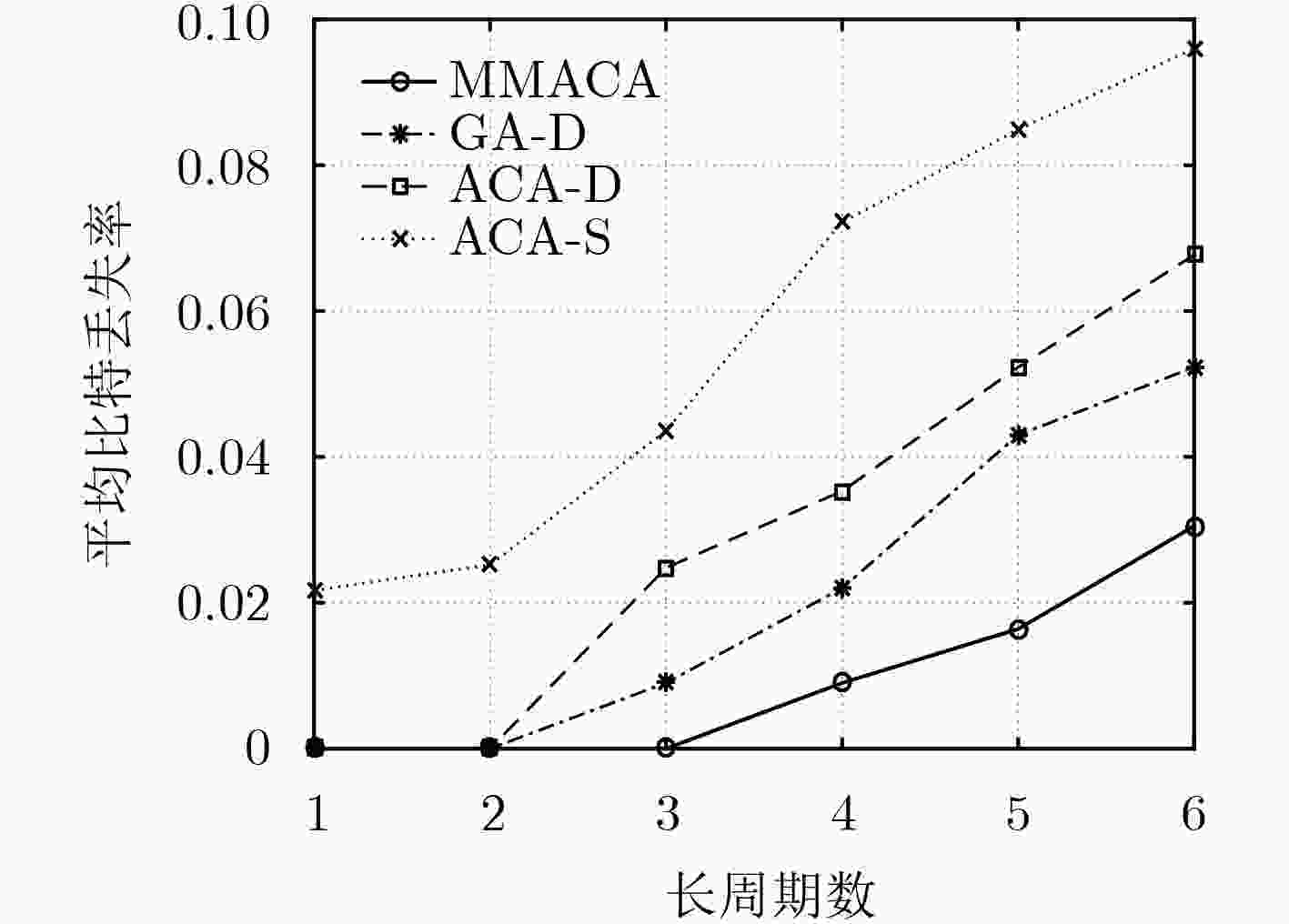

摘要: 针对无线虚拟化网络在时间域上业务请求的动态变化和信息反馈时延导致虚拟资源分配的不合理,该文提出一种基于长短时记忆(LSTM)网络的流量感知算法,该算法通过服务功能链(SFC)的历史队列信息来预测未来负载状态。基于预测的结果,联合考虑虚拟网络功能(VNF)的调度问题和相应的计算资源分配问题,提出一种基于最大最小蚁群算法(MMACA)的虚拟网络功能动态部署方法,在满足未来队列不溢出的最低资源需求的前提下,采用按需分配的方式最大化计算资源利用率。仿真结果表明,该文提出的基于LSTM神经网络预测模型能够获得很好的预测效果,实现了网络的在线监测;基于MMACA的VNF部署方法有效降低了比特丢失率的同时也降低了整体VNF调度产生的平均端到端时延。Abstract: In order to solve the unreasonable virtual resource allocation caused by the dynamic change of service request and delay of information feedback in wireless virtualized network, a traffic-aware algorithm which exploits historical Service Function Chaining (SFC) queue information to predict future load state based on Long Short-Term Memory (LSTM) network is proposed. With the prediction results, the Virtual Network Function (VNF) deployment and the corresponding computing resource allocation problems are studied, and a VNFs’ deployment method based on Maximum and Minimum Ant Colony Algorithm (MMACA) is developed. On the premise of satisfying the minimum resource demand for future queue non-overflow, the on-demand allocation method is used to maximize the computing resource utilization. Simulation results show that the prediction model based on LSTM neural network in this paper obtains good prediction results and realizes online monitoring of the network. The Maximum and Minimum Ant Colony Algorithm based VNF deployment method reduces effectively the bit loss rate and the average end-to-end delay caused by overall VNFs’ scheduling at the same time.

-

表 1 基于LSTM的VNF资源需求预测模型

1 初始化:W,迭代次数$ \kappa = 0$,状态$ h\left( \kappa \right) = 0$ 2 \*网络状态的监测*\ 3 监测不同时刻用户请求业务的数据包到达率 4 利用SFC部署算法更新队列状态并记录当前队列大小 5 \*状态计算*\ 6 while $ \left( {\kappa < T} \right)$ do 7 通过式(10)—式(12)计算$ h\left( {\kappa + 1} \right)$ 8 $\kappa = \kappa + 1$ 9 end while 10 \*输出计算*\ 11 计算不同切片业务负载的预测值 12 计算输出各个VNF资源需求预测值$ C_{f_{ij}}$ 表 2 学习与训练权重

1 迭代$ \kappa = 0$时,采用Xavier[14]初始化权重,即令权重的概率分布

函数服从$W \sim U\left[ { - \dfrac{{\sqrt 6 }}{{\sqrt {{\chi _p} + {\chi _{p + 1}}} }},\dfrac{{\sqrt 6 }}{{\sqrt {{\chi _p} + {\chi _{p + 1}}} }}} \right]$的均匀分布,其

中$ \chi$为网络层数,p为神经元个数2 while(未达到训练要求标准)do 3 使用表1中算法计算状态$ h\left( \kappa \right)$和输出$ o\left( \kappa \right)$等参数 4 利用反向传播算法(BPTT),使用惩罚函数式(13)计算惩罚

函数的梯度5 通过式(14)更新权重W 6 $ \kappa = \kappa + 1$ 7 end while 表 3 基于最大最小蚁群算法的多条服务功能链部署算法

1 初始化:蚂蚁规模antNum、信息素因子$ \partial $、启发函数重要程度

因子$ \beta $等参数2 for $ {\rm itCount=1:iteratorNum}$ do 3 for $ {\rm antCount=1:antNum}$ do 4 \*VNFs的调度*\ 5 for $ i=1:I$ do 6 for $ j=1:J$ do 7 根据式(18)计算转移概率$ P\left( k \right)$并采用轮盘赌法选择下

一个VNF部署的节点$ m$8 更新路径矩阵pathMatrix和节点剩余资源向量$ {\text{C}_{ {\rm{re} } } }\left( m \right)$ 9 end 10 end 11 end 12 \*虚拟节点计算资源的分配*\ 13 //对每个虚拟节点上的VNF按需求比例进行资源的分配 14 for $ m=1:M$ do

15 ${C_{\rm max}}({f_{ij}}) = {C_{\rm total}}(m)\cdot {C_{\rm pr}}({f_{ij}})\Bigr/\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {{C_{\rm pr}}({f_{ij}})\cdot x_{{f_{ij}}}^m} } $16 end 17 //计算每条服务功能链提供最大服务速率时实际分配

VNF的计算资源18 for $ i=1:I$ do 19 ${C_{{f_{ij}}}} = \mathop {\min }\limits_{j \in J} \left\{ {{C_{\max }}({f_{ij}})/{\eta _{{f_{ij}}}}} \right\} \cdot {\eta _{{f_{ij}}}}$ 20 end 21 根据式(19)更新信息素矩阵;根据式(15)—式(17),式(22)对

$ \rho $, $ \partial $, $ \beta $, $\zeta $进行更新22 end 23 多次迭代后得到近似最优的SFC部署方案${\rm De}{{\rm p}_{{\rm SF}{{\rm C}_i}}}$ 24 \*计算服务功能链VNF平均调度时延*\ 25 for $ i=1:I$ do 26 根据式(6)计算平均端到端时延$ {\tau _i}$ 27 end 表 4 仿真参数

仿真参数 仿真值 网络切片业务数量 3 短周期时长 10 s 长周期时长 4 h 数据包到达过程 泊松分布 数据包到达速率 [50, 100]个/s 数据包大小 指数分布 队列缓存大小 10 MB 数据训练窗口 8 神经元个数 10 仿真时间 24 h 学习率 0.01 -

MAHMOOD N H, LAURIDSEN M, BERARDINELLI G, et al. Radio resource management techniques for eMBB and mMTC services in 5G dense small cell scenarios[C]. IEEE 84th Vehicular Technology Conference, Montreal, Canada, 2016: 1–5. VASSILARAS S, GKATZIKIS L, LIAKOPOULOS N, et al. The algorithmic aspects of network slicing[J]. IEEE Communications Magazine, 2017, 55(8): 112–119. doi: 10.1109/MCOM.2017.1600939 HERRERA J G and BOTERO J F. Resource allocation in NFV: A comprehensive survey[J]. IEEE Transactions on Network & Service Management, 2016, 13(3): 518–532. doi: 10.1109/TNSM.2016.2598420 SALLENT O, PEREZ-ROMERO J, FERRUS R, et al. On radio access network slicing from a radio resource management perspective[J]. IEEE Wireless Communications, 2017, 24(5): 166–174. doi: 10.1109/MWC.2017.1600220WC LONG Q, ASSI C, and SHABAN K. Delay-aware scheduling and resource optimization with network function virtualization[J]. IEEE Transactions on Communications, 2016, 64(9): 3746–3758. doi: 10.1109/TCOMM.2016.2580150 HUANG Huang, GUO Song, WU Jinsong, et al. Service chaining for hybrid network function[J]. IEEE Transactions on Cloud Computing, 2017. doi: 10.1109/TCC.2017.2721401 ZHU Qixuan and ZHANG Xi. Game-theory based buffer-space and transmission-rate allocations for optimal energy-efficiency over wireless virtual networks[C]. IEEE Global Communications Conference, San Diego, USA, 2015: 1–6. FENG Qiu, ZHANG Bin, and GUO Jun. A deep learning approach for VM workload prediction in the cloud[C]. 201617th IEEE/ACIS International Conference on Software Engineering, Artificial Intelligence, Networking and Parallel/Distributed Computing (SNPD), Shanghai, China, 2016: 319–324. MIJUMBI R, HASIJA S, DAVY S, et al. Topology-aware prediction of virtual network function resource requirements[J]. IEEE Transactions on Network & Service Management, 2017, 14(1): 106–120. doi: 10.1109/TNSM.2017.2666781 AGARWAL S, MALANDRINO F, CHIASSERINI C, et al. Joint VNF placement and CPU allocation in 5G[C]. IEEE INFOCOM 2018 - IEEE Conference on Computer Communications, Honolulu, USA, 2018: 1943–1951. ZHANG Haijun, LIU Na, CHU Xiaoli, et al. Network slicing based 5G and future mobile networks: mobility, resource management, and challenges[J]. IEEE Communications Magazine, 2017, 55(8): 138–145. doi: 10.1109/MCOM.2017.1600940 YANG Jian, ZHANG Shuben, WU Xiaomin, et al. Online learning-based server provisioning for electricity cost reduction in data center[J]. IEEE Transactions on Control Systems Technology, 2017, 25(3): 1044–1051. doi: 10.1109/TCST.2016.2575801 CHENG Aolin, LI Jian, YU Yuling, et al. Delay-sensitive user scheduling and power control in heterogeneous networks[J]. IET Networks, 2015, 4(3): 175–184. doi: 10.1049/iet-net.2014.0026 GLOROT X and BENGIO Y. Understanding the difficulty of training deep feedforward neural networks[J]. Journal of Machine Learning Research, 2010, 9: 249–256. 唐伦, 杨希希, 施颖洁, 等. 无线虚拟网络中基于自回归滑动平均预测的在线自适应虚拟资源分配算法[J]. 电子与信息学报, 2019, 41(1): 16–23. doi: 10.11999/JEIT180048TANG Lun, YANG Xixi, SHI Yingjie, et al. ARMA-prediction based online adaptive dynamic resource allocation in wireless virtualized networks[J]. Journal of Electronics &Information Technology, 2019, 41(1): 16–23. doi: 10.11999/JEIT180048 -

下载:

下载:

下载:

下载: