Image Quality Assessment Algorithm Based on Non-local Gradient

-

摘要:

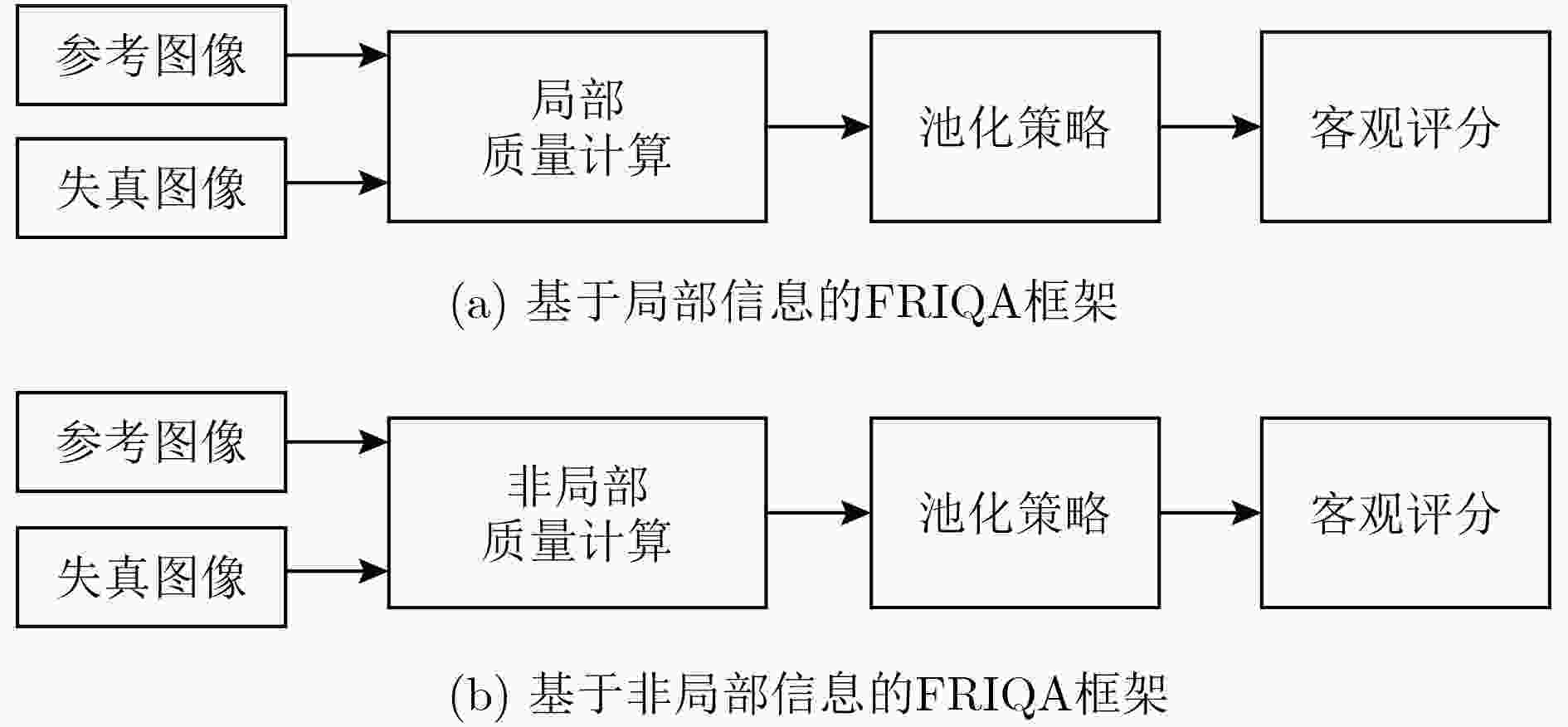

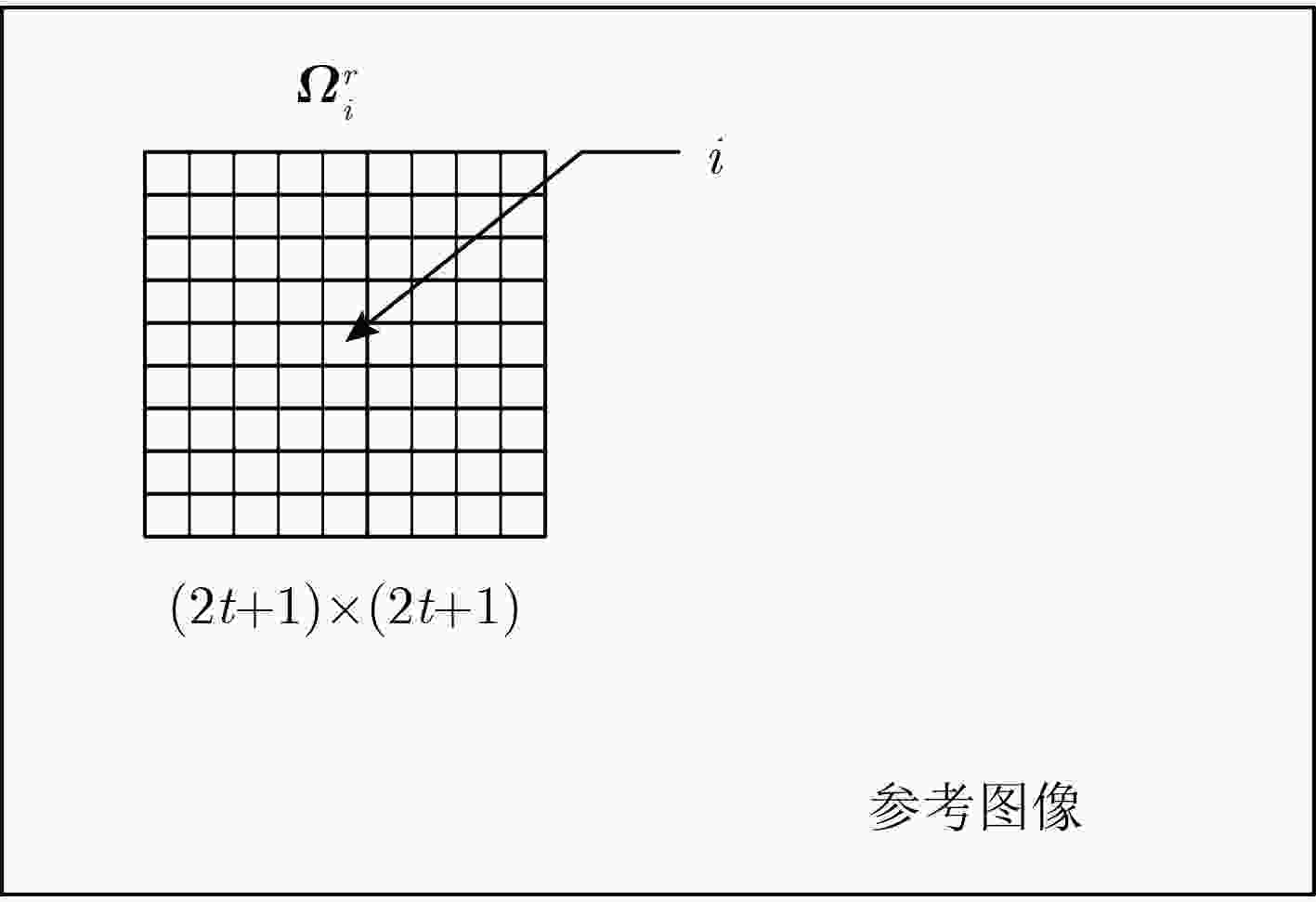

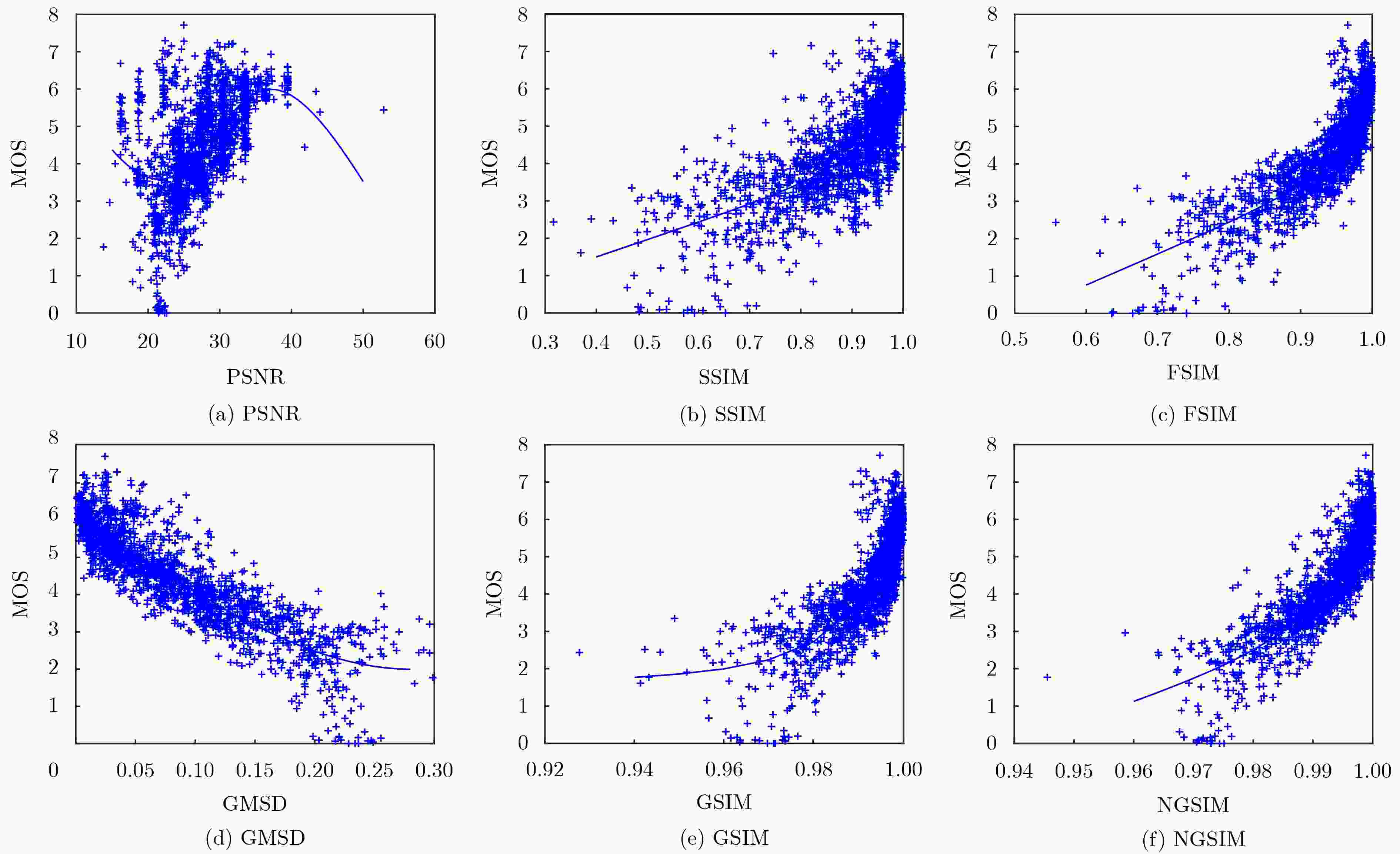

图像质量评价研究的目标在于模拟人类视觉系统对图像质量的感知过程,构建与主观评价结果尽可能一致的客观评价算法。现有的很多算法都是基于局部结构相似设计的,但人对图像的主观感知是高级的、语义的过程,而语义信息本质上是非局部的,因此图像质量评价应该考虑图像的非局部信息。该文突破了经典的基于局部信息的算法框架,提出一种基于非局部信息的框架,并在此框架内构建了一种基于非局部梯度的图像质量评价算法,该算法通过度量参考图像与失真图像的非局部梯度之间的相似性来预测图像质量。在公开测试数据库TID2008, LIVE, CSIQ上的数值实验结果表明,该算法能获得较好的评价效果。

Abstract:The goal of Image Quality Assessment (IQA) research is to simulate the Human Visual System’s (HVS) perception process of assessing image quality and construct an objective evaluation algorithm that is as consistent as the subjective evaluation result. Many existing algorithms are designed based on local structural similarity, but human subjective perception of images is a high-level, semantic process, and semantic information is essentially non-local, so image quality assessment should take the non-local information of the image into consideration. This paper breaks through the classical framework based on local information, and proposes a framework based on non-local information. Under the proposed framework, an image quality assessment algorithm based on non-local gradient is also presented. This algorithm predicts image quality by measuring the similarity between the non-local gradients of reference image and the distorted image. The experimental results on the public test database TID2008, LIVE, and CSIQ show that the proposed algorithm can obtain better evaluation results.

-

表 1 10种不同IQA算法在TID2008, CSIQ, LIVE数据库的实验结果比较

数据库 性能指标 PSNR VSNR SSIM MS-SSIM IW-SSIM FSIM ESSIM GMSD GSIM NGSIM TID2008 SROCC 0.524 0.704 0.774 0.852 0.855 0.880 0.884 0.891 0.855 0.892 KROCC 0.369 0.534 0.576 0.654 0.663 0.694 0.704 0.708 0.665 0.713 PLCC 0.530 0.682 0.773 0.842 0.857 0.873 0.885 0.879 0.846 0.886 RMSE 1.137 0.981 0.851 0.729 0.689 0.652 0.624 0.640 0.715 0.622 CSIQ SROCC 0.805 0.810 0.875 0.913 0.921 0.924 0.932 0.957 0.912 0.962 KROCC 0.608 0.624 0.690 0.739 0.752 0.756 0.768 0.813 0.740 0.825 PLCC 0.800 0.800 0.861 0.899 0.914 0.912 0.922 0.954 0.897 0.961 RMSE 0.157 0.157 0.133 0.114 0.106 0.100 0.101 0.079 0.115 0.073 LIVE SROCC 0.875 0.927 0.947 0.944 0.956 0.963 0.962 0.960 0.955 0.950 KROCC 0.686 0.761 0.796 0.792 0.817 0.833 0.839 0.823 0.813 0.815 PLCC 0.872 0.923 0.944 0.943 0.952 0.959 0.953 0.960 0.943 0.946 RMSE 13.36 10.50 8.944 9.095 8.347 7.678 7.003 7.62 9.037 7.455 表 2 10种不同IQA算法在TID2008,CSIQ, LIVE数据库单一失真性能(SROCC)的比较

数据库 失真类型 PSNR VSNR SSIM MS-SSIM IW-SSIM FSIM ESSIM GMSD GSIM NGSIM TID2008 AWN 0.907 0.772 0.811 0.809 0.786 0.857 0.885 0.918 0.857 0.902 ANMC 0.899 0.779 0.803 0.805 0.792 0.851 0.813 0.898 0.809 0.873 SCN 0.917 0.766 0.815 0.819 0.771 0.848 0.913 0.913 0.890 0.929 JPEG 0.872 0.917 0.925 0.934 0.918 0.928 0.943 0.952 0.939 0.956 JP2K 0.813 0.951 0.962 0.973 0.973 0.977 0.975 0.980 0.975 0.958 J2TE 0.831 0.790 0.858 0.852 0.820 0.854 0.879 0.883 0.892 0.926 CSIQ AWGN 0.936 0.924 0.897 0.947 0.938 0.926 0.949 0.968 0.944 0.966 JPEG 0.888 0.903 0.954 0.963 0.966 0.965 0.964 0.965 0.963 0.966 JP2K 0.936 0.948 0.960 0.968 0.968 0.968 0.967 0.972 0.964 0.974 FNIOSE 0.933 0.908 0.892 0.933 0.905 0.923 0.943 0.950 0.938 0.962 BLUR 0.929 0.944 0.960 0.971 0.978 0.972 0.962 0.971 0.958 0.967 CONTRST 0.862 0.870 0.792 0.952 0.953 0.942 0.939 0.904 0.950 0.946 LIVE JPEG2 0.895 0.955 0.961 0.962 0.964 0.971 0.980 0.971 0.958 0.972 JPEG 0.880 0.965 0.976 0.981 0.980 0.983 0.981 0.978 0.909 0.960 AWGN 0.985 0.978 0.969 0.973 0.966 0.965 0.976 0.974 0.977 0.993 BLUR 0.782 0.941 0.951 0.954 0.972 0.970 0.991 0.957 0.951 0.939 FASTFA 0.890 0.902 0.955 0.947 0.944 0.949 0.947 0.942 0.939 0.956 -

BAE S H and KIM M. A novel image quality assessment with globally and locally consilient visual quality perception[J]. IEEE Transactions on Image Processing, 2016, 25(5): 2392–2406. doi: 10.1109/TIP.2016.2545863 WANG Hanli, FU Jie, LIN Weisi, et al. Image quality assessment based on local linear information and distortion-specific compensation[J]. IEEE Transactions on Image Processing, 2017, 26(2): 915–926. doi: 10.1109/TIP.2016.2639451 DI E C and JACOVITTI G. A detail based method for linear full reference image quality prediction[J]. IEEE Transactions on Image Processing, 2017, 27(1): 179–192. doi: 10.1109/TIP.2017.2757139 CHANDLER D M and HEMAMI S S. VSNR: A wavelet-based visual signal-to-noise ratio for natural images[J]. IEEE Transactions on Image Processing, 2007, 16(9): 2284–2298. doi: 10.1109/TIP.2007.901820 褚江, 陈强, 杨曦晨. 全参考图像质量评价综述[J]. 计算机应用研究, 2014, 31(1): 13–22. doi: 10.3969/j.issn.1001-3695.2014.01.003CHU Jiang, CHEN Qiang, and YANG Xichen. Review on full reference image quality assessment algorithms[J]. Application Research of Computers, 2014, 31(1): 13–22. doi: 10.3969/j.issn.1001-3695.2014.01.003 WANG Zhou and BOVIK A C. Mean squared error: love it or leave it? A new look at signal fidelity measures[J]. IEEE Signal Processing Magazine, 2009, 26(1): 98–117. doi: 10.1109/MSP.2008.930649 HUYNH-THU Q and GHANBARI M. Scope of validity of PSNR in image/video quality assessment[J]. Electronics Letters, 2008, 44(13): 800–801. doi: 10.1049/el:20080522 WANG Zhou, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600–612. doi: 10.1109/TIP.2003.819861 WANG Zhou, SIMONCELLI E P, and BOVIK A C. Multiscale structural similarity for image quality assessment[C]. Proceedings of 37th IEEE Asilomar Conference on Signals, Systems and Computers, Pacific Grove, USA, 2003: 1398–1402. LI Chaofeng and BOVIK A C. Three-component weighted structural similarity index[C]. SPIE Conference on Image Quality and System Performance, San Jose, USA, 2009, 7242: 72420Q–72420Q-9. WANG Zhou and LI Qiang. Information content weighting for perceptual image quality assessment[J]. IEEE Transactions on Image Processing, 2011, 20(5): 1185–1198. doi: 10.1109/TIP.2010.2092435 ZHANG Lin, ZHANG Lei, MOU Xuanqin, et al. FSIM: A feature similarity index for image quality assessment[J]. IEEE Transactions on Image Processing, 2011, 20(8): 2378–2386. doi: 10.1109/TIP.2011.2109730 LIU Anmin, LIN Weisi, and NARWARIA M. Image quality assessment based on gradient similarity[J]. IEEE Transactions on Image Processing, 2012, 21(4): 1500–1512. doi: 10.1109/TIP.2011.2175935 XUE Wufeng, ZHANG Lei, MOU Xuanqin, et al. Gradient magnitude similarity deviation: A highly efficient perceptual image quality index[J]. IEEE Transactions on Image Processing, 2014, 23(2): 684–695. doi: 10.1109/TIP.2013.2293423 ZHANG Xuande, FENG Xiangchu, WANG Weiwei, et al. Edge strength similarity for image quality assessment[J]. IEEE Signal Processing Letters, 2013, 20(4): 319–322. doi: 10.1109/LSP.2013.2244081 WANG Tonghan, JIA Huizhen, and SHU Huazhong. Full-reference image quality assessment algorithm based on gradient magnitude and histogram of oriented gradient[J]. Journal of Southeast University, 2018, 48(2): 276–281. doi: 10.3969/j.issn.1001-0505.2018.02.014 NI Zhangkai, MA Lin, ZENG Huanqiang, et al. Gradient direction for screen content image quality assessment[J]. IEEE Signal Processing Letters, 2016, 23(10): 1394–1398. doi: 10.1109/LSP.2016.2599294 DING Li, HUANG Hua, and ZANG Yu. Image quality assessment using directional anisotropy structure measurement[J]. IEEE Transactions on Image Processing, 2017, 26(4): 1799–1809. doi: 10.1109/TIP.2017.2665972 张帆, 张偌雅, 李珍珍. 基于对称相位一致性的图像质量评价方法[J]. 激光与光电子学进展, 2017, 54(10): 194–202. doi: 10.3788/LOP54.101003ZHANG Fan, ZHANG Ruoya, and LI Zhenzhen. Image quality assessment based on symmetry phase congruency[J]. Laser &Optoelectronics Progress, 2017, 54(10): 194–202. doi: 10.3788/LOP54.101003 PONOMARENKO N, LUKIN V, ZELENSKY A, et al. TID2008: A database for evaluation of full-reference visual quality assessment metrics[OL]. http://www.ponomarenko.info/papers/mre2009tid.pdf. 2016.10. LARSON EC and CHANDLER D. Categorical subjective image quality (CSIQ) database[OL]. http://vision.okstate.edu/csiq, 2016.10. SHEIKH H R, WANG Zhou, BOVIK A C, et al. Image and video quality assessment research at LIVE[OL]. http://live.ece.utexas.edu/rese-arch/quality/. 2016.10. -

下载:

下载:

下载:

下载: