Vehicle Detection in Remote Sensing Images of Dense Areas Based on Deformable Convolution Neural Network

-

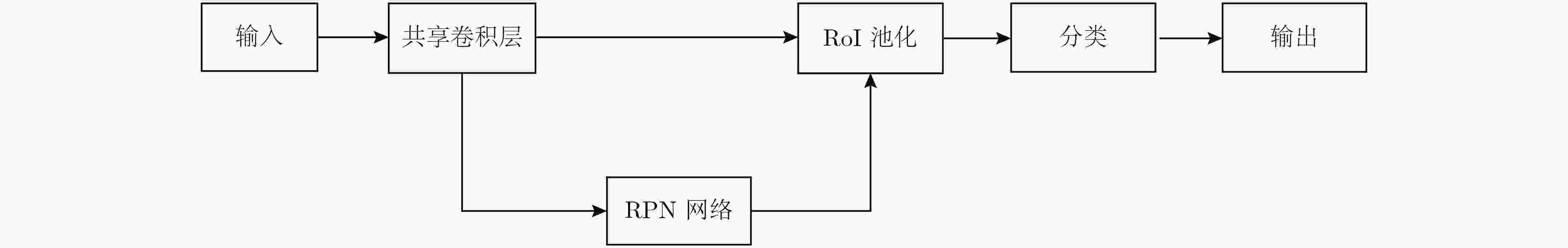

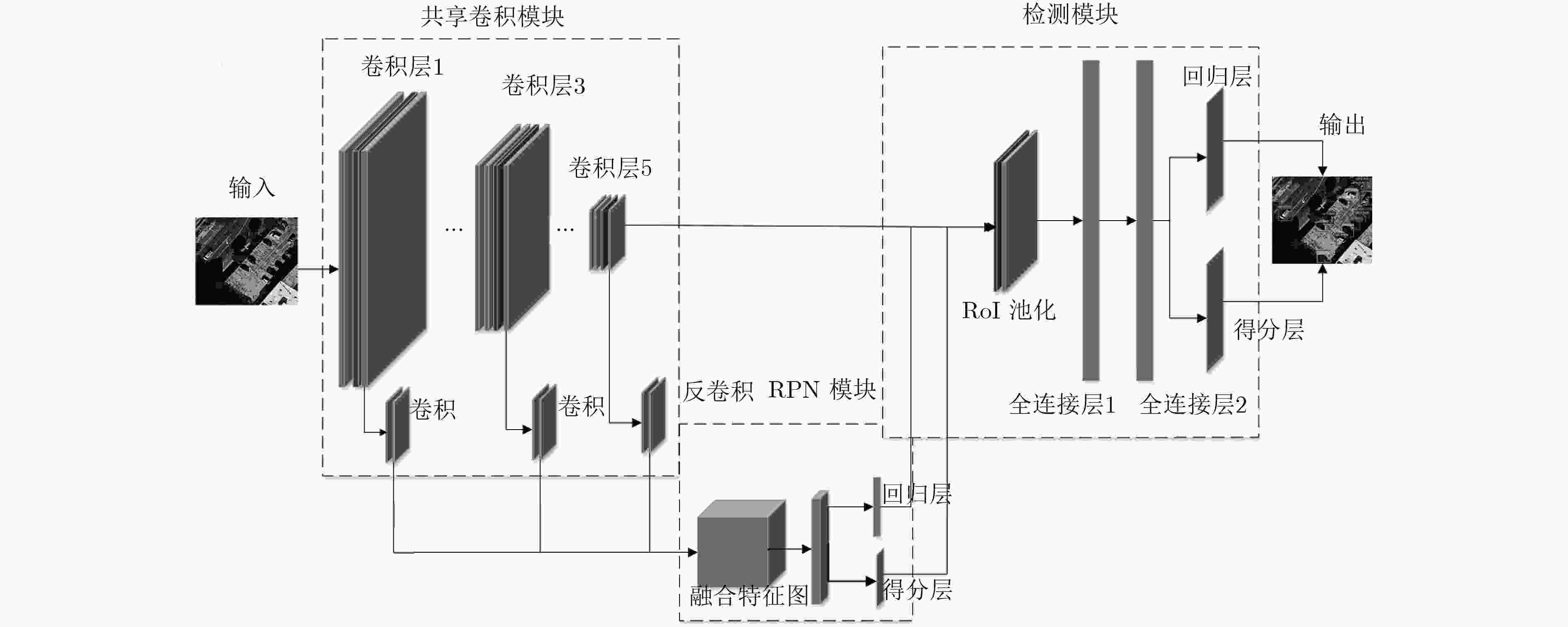

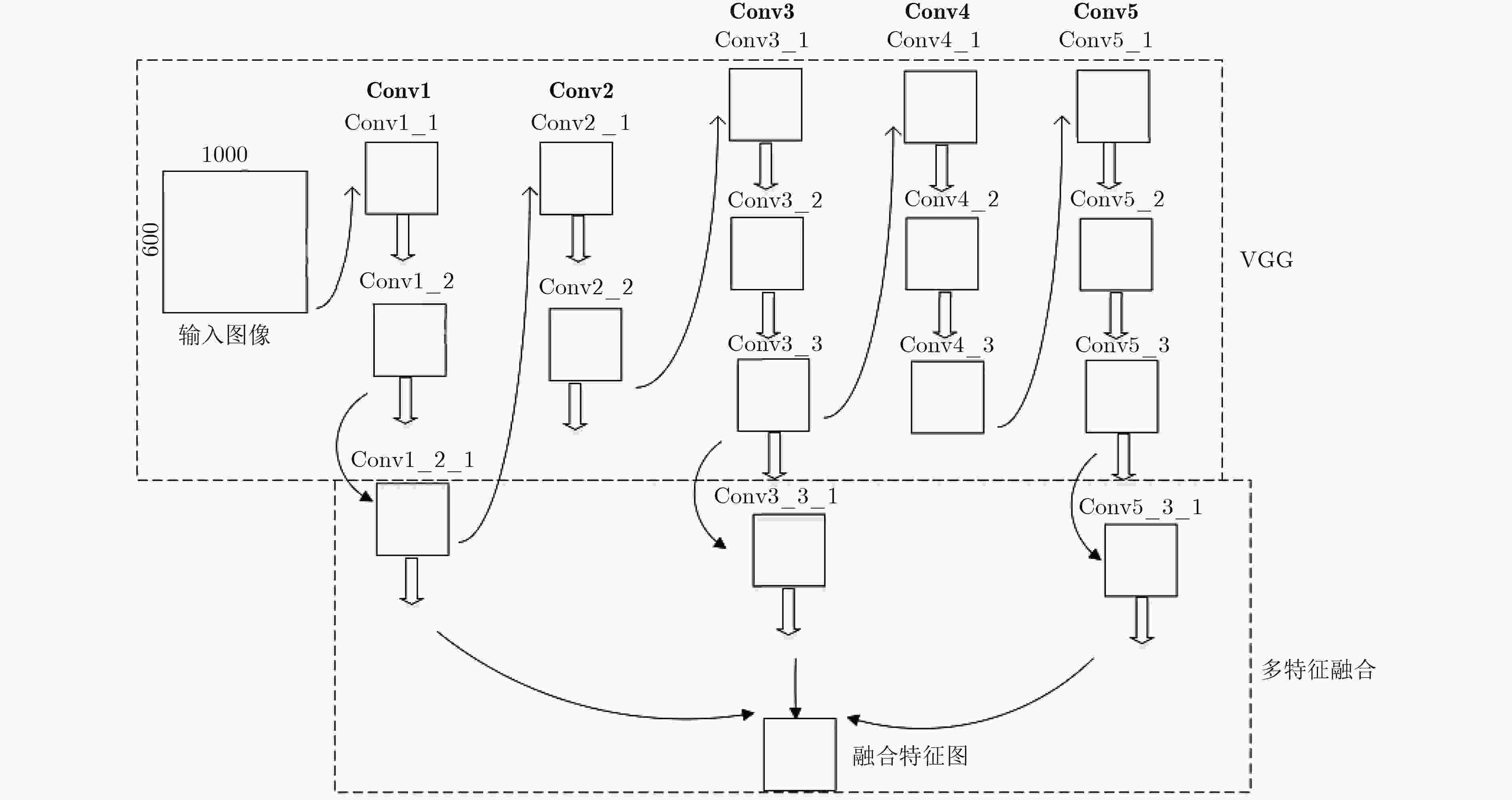

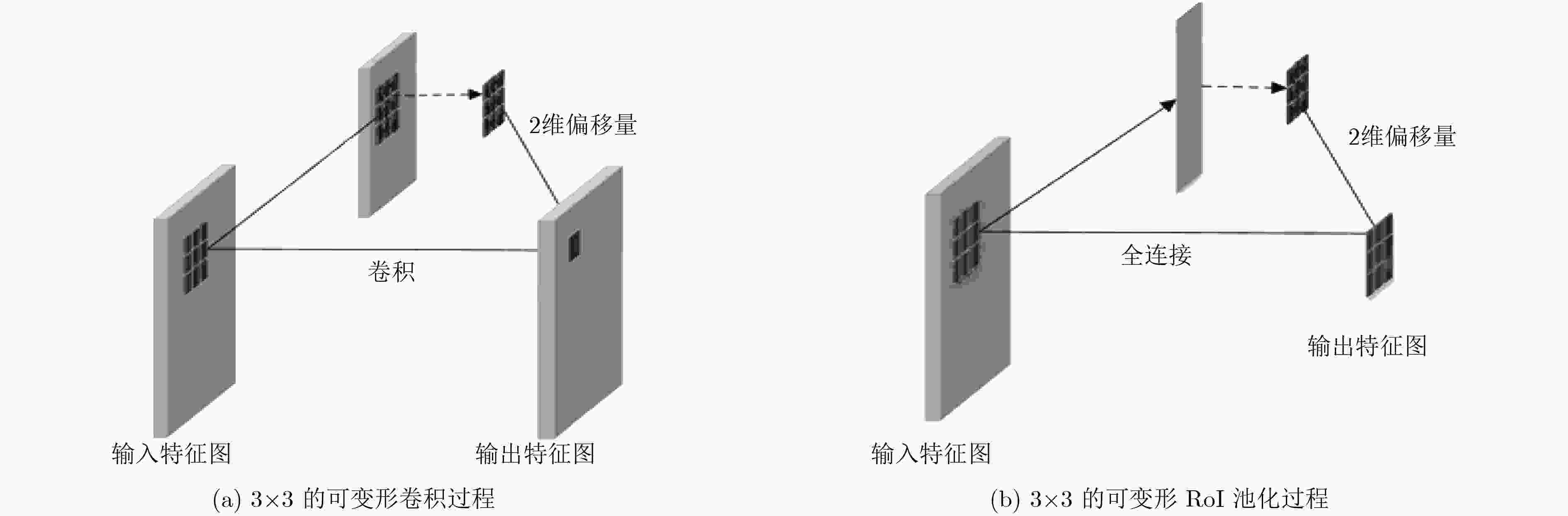

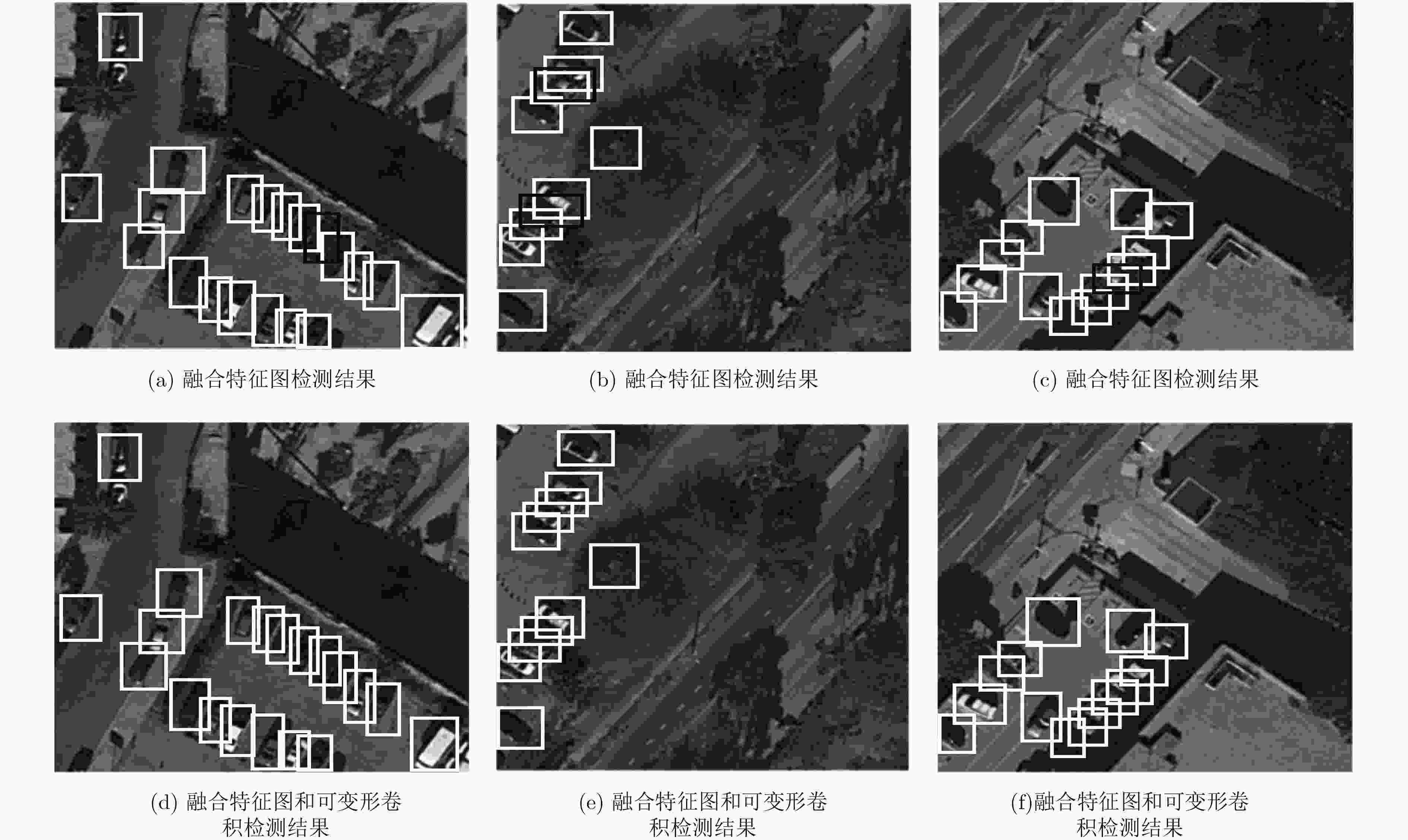

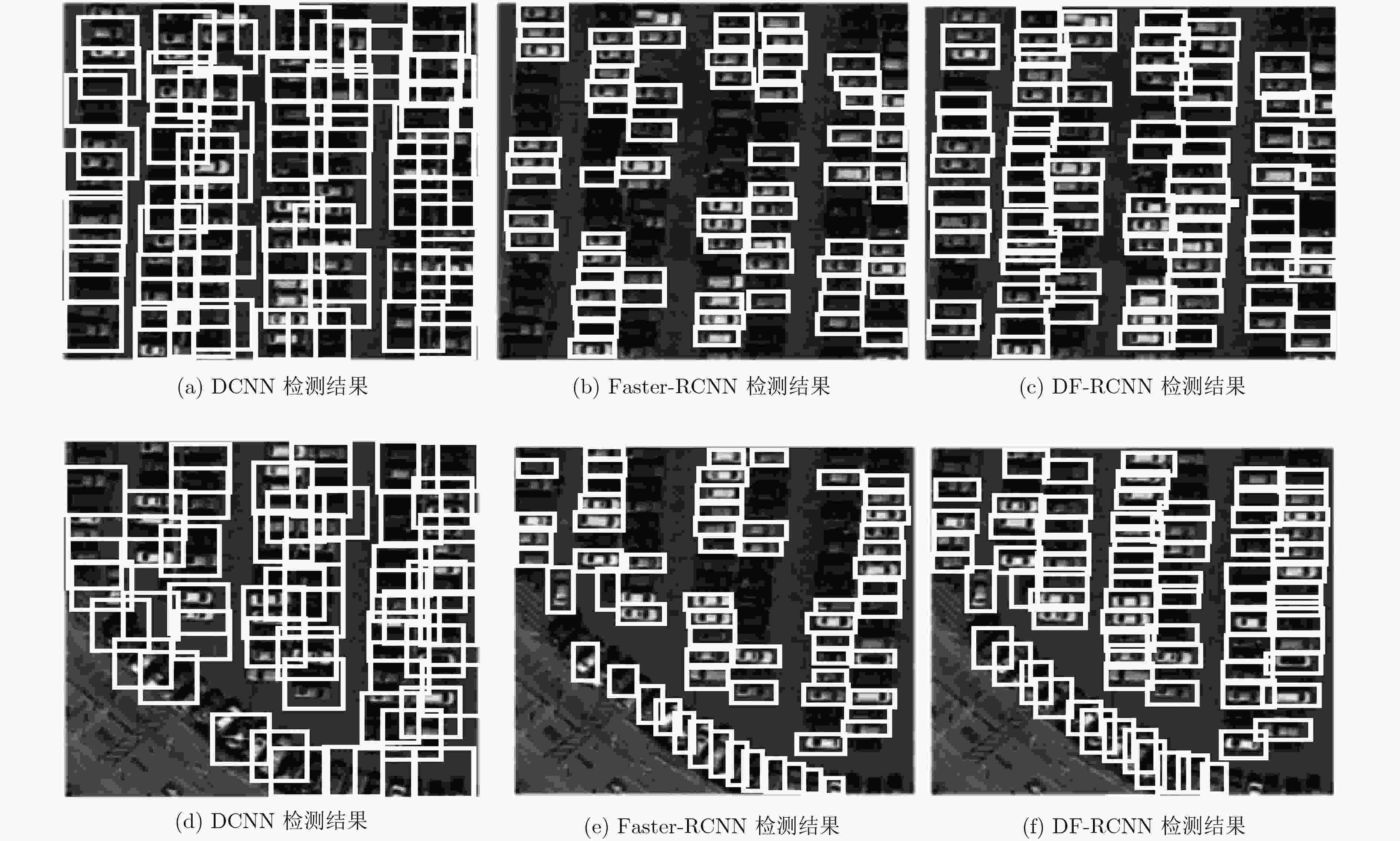

摘要: 车辆检测是遥感图像分析领域的热点研究内容之一,车辆目标的智能提取和识别,对于交通管理、城市建设有重要意义。在遥感领域中,现有基于卷积神经网络的车辆检测方法存在实现过程复杂并且对于车辆密集区域检测效果不理想的缺陷。针对上述问题,该文提出基于端到端的神经网络模型DF-RCNN以提高车辆密集区域的检测精度。首先,在特征提取阶段,DF-RCNN模型将深浅层特征图的分辨率统一并融合;其次,DF-RCNN模型结合可变形卷积和可变形感兴趣区池化模块,通过加入少量的参数和计算量以学习目标的几何形变。实验结果表明,该文提出的模型针对密集区域的车辆目标具有较好的检测性能。Abstract: Vehicle detection is one of the hotspots in the field of remote sensing image analysis. The intelligent extraction and identification of vehicles are of great significance to traffic management and urban construction. In remote sensing field, the existing methods of vehicle detection based on Convolution Neural Network (CNN) are complicated and most of these methods have poor performance for dense areas. To solve above problems, an end-to-end neural network model named DF-RCNN is presented to solve the detecting difficulty in dense areas. Firstly, the model unifies the resolution of the deep and shallow feature maps and combines them. After that, the deformable convolution and RoI pooling are used to study the geometrical deformation of the target by adding a small number of parameters and calculations. Experimental results show that the proposed model has good detection performance for vehicle targets in dense areas.

-

表 1 3 种尺度和 3 种比例映射候选区域尺寸

区域尺寸和比例 202, 1:1 202, 1:2 202, 2:1 302, 1:1 302, 1:2 302, 2:1 402, 1:1 402, 1:2 402, 2:1 映射区域大小 20×20 14×28 28×14 30×30 21×42 42×21 40×40 28×56 57×28 表 2 不同层检测性能比较

模型 检测区域 召回率 准确率 F1指标 层1 密集区域 0.461 0.611 0.525 层3 密集区域 0.623 0.754 0.682 层5 密集区域 0.655 0.923 0.766 层3+5 密集区域 0.714 0.930 0.808 层2+4 密集区域 0.709 0.925 0.803 层1+3+5 密集区域 0.725 0.927 0.814 表 3 结合可变形模块检测性能比较

模型 检测区域 召回率 准确率 F1指标 层1+3+5,可变形卷积 密集区域 0.731 0.932 0.819 层1+3+5,可变形RoI池化 密集区域 0.726 0.925 0.814 层1+3+5,可变形卷积,可变形RoI池化 密集区域 0.744 0.940 0.831 层5,可变形卷积,可变形RoI池化 密集区域 0.725 0.924 0.812 层2+4,可变形卷积,可变形RoI池化 密集区域 0.715 0.922 0.805 层3+5,可变形卷积,可变形RoI池化 密集区域 0.729 0.928 0.817 表 4 不同模型检测性能比较

模型 检测区域 召回率 准确率 F1指标 Faster-RCNN 密集区域 0.655 0.932 0.766 DCNN 密集区域 0.402 0.925 0.560 DF-RCNN 密集区域 0.744 0.940 0.831 Faster-RCNN 非密集区域 0.901 0.942 0.921 DCNN 非密集区域 0.962 0.785 0.865 DF-RCNN 非密集区域 0.910 0.952 0.931 -

SHAO Wen, YANG Wen, LIU Guang, et al. Car detection from high-resolution aerial imagery using multiple features[C]. Geoscience and Remote Sensing Symposium, Munich, Germany, 2012: 4379–4382. MORANDUZZO T and MELGANI F. Automatic car counting method for unmanned aerial vehicle images[J]. IEEE Transactions on Geoscience&Remote Sensing, 2013, 52(3): 1635–1647 doi: 10.1109/TGRS.2013.2253108 KLUCKNER S, PACHER G, GRABNER H, et al. A 3D teacher for car detection in aerial images[C]. International Conference on Computer Vision, Rio de Janeiro, Brazil, 2007: 1–8. TUERMER S, KURZ F, Reinartz P, et al. Airborne vehicle detection in dense urban areas using HoG features and disparity maps[J]. IEEE Journal of Selected Topics in Applied Earth Observations&Remote Sensing, 2013, 6(6): 2327–2337 doi: 10.1109/JSTARS.2013.2242846 CHEN Ziyi, WANG Cheng, WEN Chenglu, et al. Vehicle detection in high-resolution aerial images via sparse representation and superpixels[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 54(1): 103–116 doi: 10.1109/TGRS.2015.2451002 康妙, 计科峰, 冷祥光, 等. 基于栈式自编码器特征融合的SAR图像车辆目标识别[J]. 雷达学报, 2017, 6(2): 167–176 doi: 10.12000/JR16112KANG Miao, JI Kefeng, LENG Xiangguang, et al. SAR target recognition with feature fusion based on stacked autoencoder[J]. Journal of Radars, 2017, 6(2): 167–176 doi: 10.12000/JR16112 王思雨, 高鑫, 孙皓, 等. 基于卷积神经网络的高分辨率SAR图像飞机目标检测方法[J]. 雷达学报, 2017, 6(2): 195–203 doi: 10.12000/JR17009WANG Siyu, GAO Xin, SUN Hao, et al. An aircraft detection method based on convolutional neural networks in high-resolution SAR images[J]. Journal of Radars, 2017, 6(2): 195–203 doi: 10.12000/JR17009 田壮壮, 占荣辉, 胡杰民, 等. 基于卷积神经网络的SAR图像目标识别研究[J]. 雷达学报, 2016, 5(3): 320–325 doi: 10.12000/JR16037TIAN Zhuangzhuang, ZHAN Ronghui, HU Jiemin, et al. SAR ATR based on convolutional neural network[J]. Journal of Radars, 2016, 5(3): 320–325 doi: 10.12000/JR16037 YANG Zi and PUN-CHENG L S C. Vehicle detection in intelligent transportation systems and its applications under varying environments: A review[J]. Image&Vision Computing, 2017, 69: 143–154 doi: 10.1016/j.imavis.2017.09.008 CHEN Xueyun, XIANG Shiming, LIU Chenglin, et al. Vehicle detection in satellite images by hybrid deep convolutional neural networks[J]. IEEE Geoscience&Remote Sensing Letters, 2014, 11(10): 1797–1801 doi: 10.1109/LGRS.2014.2309695 LI Hao, FU Kun, YAN Menglong, et al. Vehicle detection in remote sensing images using denoizing-based convolutional neural networks[J]. Remote Sensing Letters, 2017, 8(3): 262–270 doi: 10.1080/2150704X.2016.1258127 REN Shaoqing, HE Kaiming, SUN Jian, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis&Machine Intelligence, 2017, 39(6): 1137–1149 doi: 10.1109/TPAMI.2016.2577031 DENG Zhipeng, SUN Hao, ZHOU Shilin, et al. Toward fast and accurate vehicle detection in aerial images using coupled region-based convolutional neural networks[J]. IEEE Journal of Selected Topics in Applied Earth Observations&Remote Sensing, 2017, 10(8): 3652–3664 doi: 10.1109/JSTARS.2017.2694890 ELMIKATY M and STATHAKI T. Car detection in aerial images of dense urban areas[J]. IEEE Transactions on Aerospace&Electronic Systems, 2017, 54(1): 51–63 doi: 10.1109/TAES.2017.2732832 DAI Jifeng, QI Haozhi, XIONG Yunwen, et al. Deformable convolutional networks[OL]. http://arxiv.org/abs/1703.06211.2017. LIU Derong, LI Hongliang, and WANG Ding. Feature selection and feature learning for high-dimensional batch reinforcement learning: A survey[J]. International Journal of Automation and Computing, 2015, 12(3): 229–242 doi: 10.1007/s11633-015-0893-y YANG Bin, YAN Junjie, LEI Zhen, et al. Convolutional channel features[C]. IEEE International Conference on Computer Vision, Santiago, Chile, 2015: 82–90. ZHONG Bin, ZHANG Jun, WANG Pengfei, et al. Jointly feature learning and selection for robust tracking via a gating mechanism[J]. Plos One, 2016, 11(8): e0161808 doi: 10.1371/journal.pone.0161808 SIMONYAN K and ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[OL]. http://arxiv.org/abs/1409.1556.2014. HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, United States, 2016: 770–778. ZEILER M D and FERGUS R.Visualizing and Understanding Convolutional Networks[C]. European Conference on Computer Vision, Zurich, Switzerland, 2014: 818–833. -

下载:

下载:

下载:

下载: